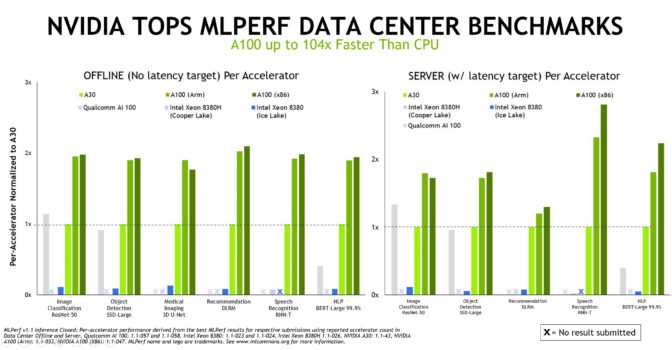

A NVIDIA apresenta os melhores resultados em inferência de AI usando CPUs baseadas em x86 ou Arm, de acordo com os benchmarks divulgados recentemente.

É a terceira vez consecutiva que a NVIDIA estabelece recordes de desempenho e eficiência energética em testes de inferência do MLCommons, um grupo de benchmarking do setor formado em maio de 2018.

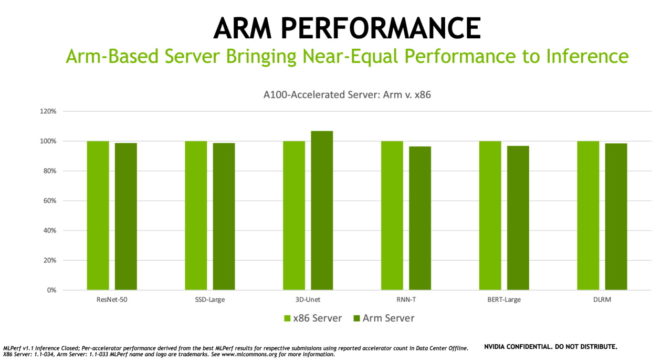

Também é a primeira vez que os testes da categoria de data center são realizados em um sistema baseado em Arm, oferecendo aos usuários mais opções de implantação de AI, a tecnologia mais transformadora da atualidade.

Estatísticas para Comparação

Os computadores com tecnologia fornecida pela plataforma de AI da NVIDIA foram os melhores em todos os sete testes de desempenho de inferência na última rodada com sistemas da NVIDIA e de nove parceiros do ecossistema, como Alibaba, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Inspur Electronic Information, Lenovo, Nettrix e Supermicro.

A NVIDIA é a única empresa a apresentar resultados em todos os testes do MLPerf nesta e em todas as rodadas até o momento.

A inferência é o que acontece quando um computador executa software de AI para reconhecer um objeto ou fazer uma previsão. É um processo que usa um modelo de deep learning para filtrar dados, encontrando resultados que humanos não conseguem alcançar.

Os benchmarks de inferência do MLPerf são baseados nas cargas de trabalho e situações de AI mais comuns de hoje, como visão computacional, diagnósticos por imagens, processamento de linguagem natural, sistemas de recomendação, aprendizagem por reforço e muito mais.

Por isso, independentemente das aplicações de AI implantadas, os usuários podem estabelecer os próprios recordes com a NVIDIA.

Importância do Desempenho

Os modelos de AI e conjuntos de dados continuam crescendo, e os casos de uso da AI já não se limitam mais ao data center e ao edge. É por isso que os usuários precisam de um desempenho confiável e flexível para realizar implantações.

O MLPerf oferece aos usuários a segurança para tomar decisões fundamentadas no momento da compra. Ele tem o apoio de vários líderes do setor, como Alibaba, Arm, Baidu, Google, Intel e NVIDIA, o que faz com que os testes sejam transparentes e objetivos.

Usando Arm na AI Corporativa

A arquitetura Arm é cada vez mais adotada em data centers ao redor do mundo, principalmente devido à eficiência energética, ao aumento de desempenho e à expansão do ecossistema de software que proporciona.

Os benchmarks mais atuais mostram que, como plataformas aceleradas por GPU, os servidores baseados em Arm que usam CPUs Ampere Altra oferecem quase o mesmo desempenho que servidores baseados em x86 com configuração semelhante para trabalhos de inferência de AI. Na verdade, em um dos testes, o servidor baseado em Arm superou um sistema x86 semelhante.

A NVIDIA tem uma longa tradição de oferecer suporte a todas as arquiteturas de CPU. Por isso, temos orgulho de ver que a Arm comprovou sua potência de AI em um benchmark do setor com revisão por pares.

“A Arm, como membro fundador da MLCommons, tem compromisso com o processo de criação de padrões e benchmarks para superar desafios com mais eficiência e promover a inovação no setor de computação acelerada”, disse David Lecomber, diretor sênior de HPC e ferramentas na Arm.

“Os últimos resultados de inferência mostram o preparo dos sistemas baseados em Arm com CPUs baseadas em Arm e GPUs NVIDIA para lidar com uma série de cargas de trabalho de AI no data center”, adicionou.

Parceiros Mostram Seus Poderes de AI

A tecnologia de AI da NVIDIA é auxiliada por um grande ecossistema em constante crescimento.

Sete OEMs apresentaram um total de 22 plataformas aceleradas por GPU nos benchmarks mais recentes.

A maioria desses modelos de servidor são Certificados pela NVIDIA, validados para a execução de diversas cargas de trabalho aceleradas. Além disso, muitos são compatíveis com o NVIDIA AI Enterprise, um software lançado oficialmente no mês passado.

Entre nossos parceiros participantes da rodada, estavam Dell Technologies, Fujitsu, Hewlett Packard Enterprise, Inspur Electronic Information, Lenovo, Nettrix e Supermicro, além do fornecedor de serviços em cloud Alibaba.

O Poder do Software

Um ingrediente indispensável para o sucesso da AI da NVIDIA em todos os casos de uso é nosso pacote completo de softwares.

Para a inferência, ele inclui modelos de AI pré-treinados para uma ampla variedade de casos de uso. O Kit de Ferramentas NVIDIA TAO personaliza os modelos para aplicações específicas usando transfer learning.

Nosso software NVIDIA TensorRT otimiza os modelos de AI para que façam melhor uso da memória e sejam executados mais rapidamente. É usado sistematicamente para testes do MLPerf e está disponível para sistemas baseados em x86 e Arm.

Também utilizamos o software do Servidor de Inferência NVIDIA Triton e recursos de GPU Multi-Instância (MIG – Multi-Instance GPU) nesses benchmarks. Eles oferecem aos desenvolvedores o nível de desempenho que geralmente exige codificadores especializados.

Graças às melhorias contínuas desse pacote de software, a NVIDIA obteve um aumento de até 20% no desempenho e de até 15% na eficiência energética em comparação aos benchmarks de inferência do MLPerf anteriores, divulgados há quatro meses.

Todos os softwares usados nos últimos testes estão disponíveis no repositório do MLPerf para permitir que qualquer pessoa reproduza nossos resultados no benchmark. Sempre incluímos esse código em nossos frameworks e contêineres de deep learning disponíveis no NGC, um hub de softwares para aplicações de GPU.

Ele faz parte de uma oferta completa de AI compatível com todas as principais arquiteturas de processadores, comprovada nos benchmarks mais recentes do setor e disponível para encarar tarefas de AI reais da atualidade.

Para saber mais sobre a plataforma de inferência da NVIDIA, confira a Visão Geral da Tecnologia de Inferência da NVIDIA.