De acordo com os benchmarks do MLPerf divulgados hoje, a NVIDIA oferece as soluções para treinamento de AI com o desempenho mais rápido do mundo entre os produtos disponíveis no mercado.

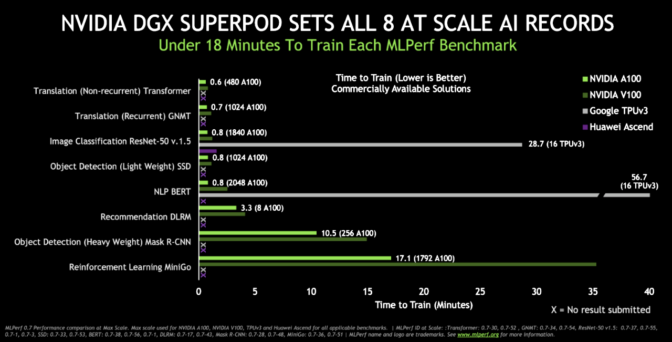

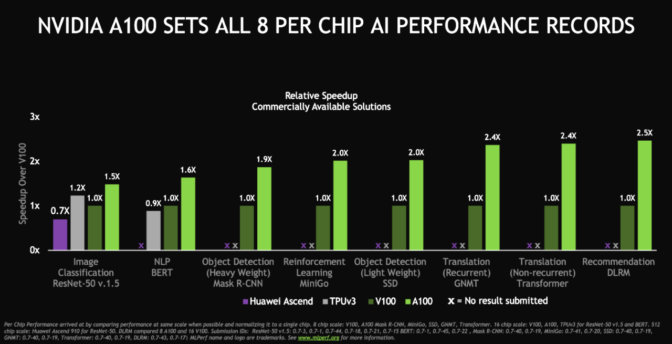

A GPU A100 e o sistema DGX SuperPOD, um cluster gigante de A100s conectadas com a HDR InfiniBand, atingiram oito novos marcos em desempenho cada, quebrando 16 recordes ao total. Porém, quem ganha mesmo são os clientes, que estão usando esse desempenho para transformar seus negócios de maneira mais rápida e mais econômica com a AI.

É a terceira vez consecutiva que a NVIDIA mostra um desempenho excelente nos testes de treinamento do MLPerf, um grupo para a definição de benchmarks do setor formado em maio de 2018. A NVIDIA estabeleceu seis recordes nos primeiros benchmarks de treinamento do MLPerf, em dezembro de 2018, e oito em julho de 2019.

A empresa estabeleceu recordes na categoria mais valorizada pelos clientes, a de produtos disponíveis no mercado. Realizamos os testes usando a arquitetura NVIDIA Ampere mais atual e a arquitetura Volta.

A NVIDIA foi a única empresa a oferecer produtos disponíveis no mercado para todos os testes. A maioria dos produtos concorrentes inscritos se encaixou na categoria de prévia, que abrange produtos que talvez não sejam disponibilizados no próximos meses, ou na categoria de pesquisa, que abrange produtos que não serão disponibilizados no futuro próximo.

NVIDIA Ampere Garante Aceleração em Tempo Recorde

Além de quebrar recordes de desempenho, a A100, primeiro processador baseado na arquitetura Ampere da NVIDIA, chegou ao mercado mais rápido que as GPUs anteriores da empresa. Na época em que foi lançada, era usada nos sistemas DGX de terceira geração da NVIDIA e foi disponibilizada para o público em um serviço em cloud do Google depois de apenas seis semanas.

Outras empresas que estão contribuindo para o aumento da procura pela A100 são as principais operadoras de cloud do mundo, Alibaba Cloud, Amazon Web Services, Baidu Cloud, Microsoft Azure e Tencent Cloud, além de várias fabricantes de servidores, como Dell Technologies, Hewlett Packard Enterprise, Inspur Electronic Information e Supermicro.

Usuários de todo o mundo estão implementando a A100 para enfrentar os desafios mais difíceis nas áreas de AI, ciência de dados e computação científica.

Alguns estão contribuindo para uma nova onda de sistemas de recomendação ou aplicativos de AI conversacional, e outros estão auxiliando na descoberta de tratamentos para a COVID-19. Porém, todos estão se beneficiando do maior salto geracional de desempenho em oito gerações de GPUs NVIDIA.

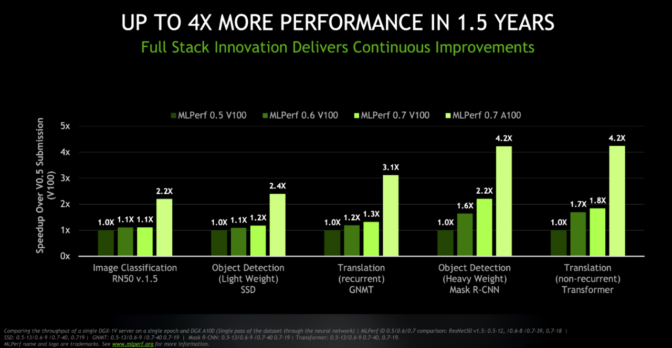

Desempenho Quatro Vezes Melhor em Menos de Dois Anos

Os resultados mais atuais mostram o foco da NVIDIA no aprimoramento contínuo de uma plataforma de AI que abrange processadores, redes, software e sistemas.

Os testes mostram, por exemplo, em taxas de rendimento equivalentes, que o sistema DGX atual com GPUs A100 oferece um desempenho até quatro vezes melhor que o do sistema DGX com GPUs V100 usado na primeira rodada de testes de treinamento do MLPerf. Já o servidor DGX V100 original pode oferecer até o dobro do desempenho agora, graças às otimizações de software mais atuais.

Esses avanços foram observados menos de dois anos após as inovações realizadas na plataforma de AI. As GPUs NVIDIA A100 atuais, em conjunto com as atualizações de software das bibliotecas CUDA-X, aceleram clusters cada vez maiores desenvolvidos com a rede Mellanox HDR 200 Gb/s InfiniBand.

Com a HDR InfiniBand, é possível garantir latências extremamente baixas, uma taxa de transferência de dados alta e mecanismos inteligentes de aceleração de computação de deep learning com a tecnologia Scalable Hierarchical Aggregation and Reduction Protocol (SHARP).

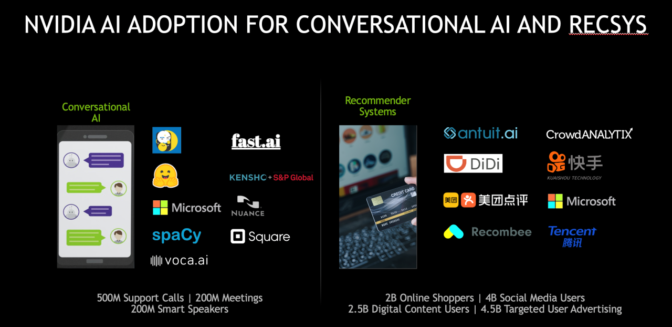

NVIDIA Ganha Destaque em Sistemas de Recomendação e AI Conversacional

Os benchmarks do MLPerf, definidos com o apoio de empresas como Amazon, Baidu, Facebook, Google, Harvard, Intel, Microsoft e Stanford, estão sempre sendo atualizados para continuarem relevantes para a AI, que também está em constante evolução.

Nos benchmarks mais atuais, há dois novos testes em que a NVIDIA apresentou um desempenho excelente. Um avaliou o desempenho nos sistemas de recomendação, uma tarefa de AI cada vez mais comum, e o outro avaliou a AI conversacional usando o BERT, um dos modelos de redes neurais mais complexos usados hoje. Finalmente, o teste de aprendizado por reforço usou o Mini-go com o quadro Go de tamanho 19×19 e foi o teste mais complexo nesta rodada, envolvendo diversas operações, desde o jogo até o treinamento.

As empresas já estão colhendo os frutos desse desempenho nessas aplicações estratégicas da IA.

A Alibaba estabeleceu um recorde de US$ 38 bilhões em vendas no Dia dos Solteiros chinês, em novembro, usando GPUs NVIDIA para oferecer 100 vezes mais consultas por segundo nos sistemas de recomendação do que o número oferecido com CPUs. Já a AI conversacional está dando o que falar, gerando excelentes resultados comerciais em diversos setores, desde finanças até a área da saúde.

A NVIDIA oferece o desempenho necessário para realizar essas tarefas avançadas e a facilidade de uso para incorporá-las.

Software Abre Caminhos Estratégicos para AI

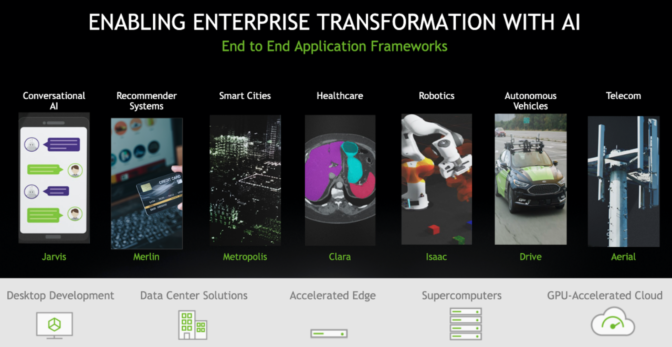

Em maio, a NVIDIA anunciou dois frameworks de aplicação: Jarvis para AI conversacional e o Merlin para sistemas de recomendação, que conta com o framework HugeCTR para treinamento, que contribuiu para os resultados mais atuais do MLPerf.

Eles fazem parte de uma família crescente de frameworks de aplicações para mercados como automotivo (NVIDIA DRIVE), saúde (Clara), robótica (Isaac) e cidades inteligentes / varejo (Metropolis).

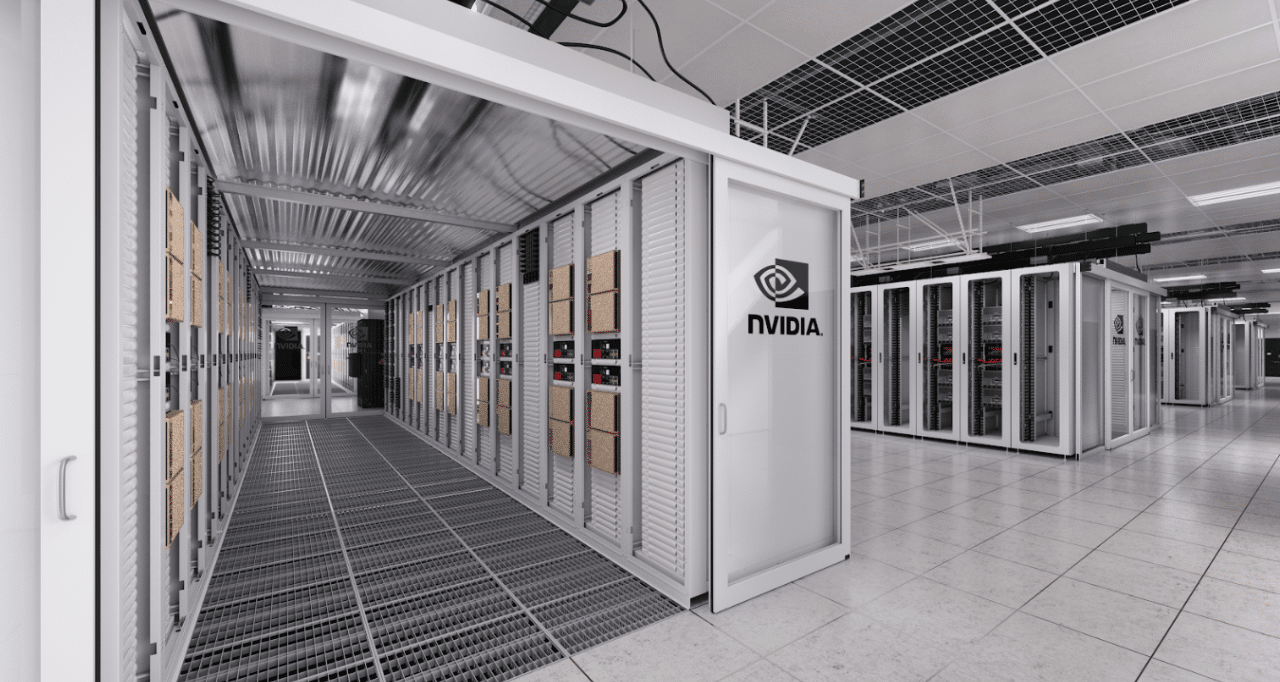

Arquitetura DGX SuperPOD Oferece Velocidade em Escala

A NVIDIA realizou os testes do MLPerf nos sistemas do Selene, um cluster interno baseado no DGX SuperPOD, a arquitetura de referência pública para clusters de GPUs de grande escala que pode ser implementada em semanas. Essa arquitetura amplia os princípios de design e as práticas recomendadas usadas no DGX POD para solucionar os problemas mais desafiadores da AI de hoje.

Recentemente, o Selene apareceu na lista TOP500 como o sistema industrial mais rápido dos Estados Unidos, com um desempenho de AI de mais de 1 exaflops. Ele também é o segundo sistema com maior eficiência energética do mundo, de acordo com a lista Green500.

Os clientes já estão usando as arquiteturas de referência para desenvolver DGX PODs e DGX SuperPODs personalizados. Um deles é o HiPerGator, o supercomputador acadêmico de AI mais rápido dos EUA, que a Universidade da Flórida usará como base para a iniciativa de AI em diversos cursos.

Enquanto isso, um dos principais centros de supercomputação, o Laboratório Nacional Argonne, está usando GPUs A100 para descobrir formas de combater a COVID-19. O Argonne foi o primeiro de mais de seis centros de computação de alto desempenho a adotar as GPUs A100.

Os DGX SuperPODs já estão garantindo resultados comerciais para empresas como a Continental no setor automotivo, a Lockheed Martins no setor aeroespacial e a Microsoft no setor de serviços de computação em cloud.

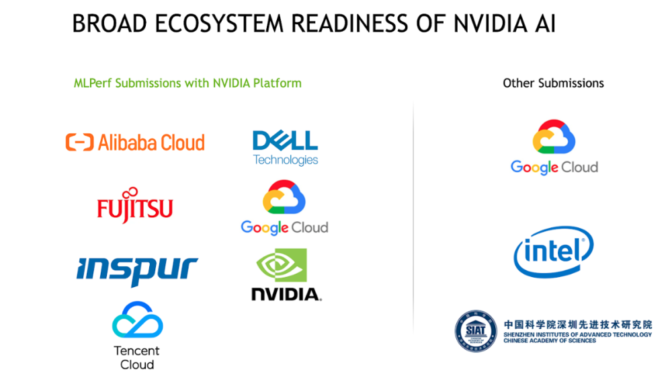

Os sistemas já estão funcionando graças, em parte, a um amplo ecossistema que oferece suporte a GPUs NVIDIA e sistemas DGX.

Desempenho Excelente do Ecossistema da NVIDIA no MLPerf

Das nove empresas que apresentaram resultados, sete foram submetidas a GPUs NVIDIA, incluindo provedores de serviços em cloud (Alibaba Cloud, Google Cloud, Tencent Cloud) e fabricantes de servidores (Dell, Fujitsu e Inspur Electronic Information), destacando a força do ecossistema da NVIDIA.

Muitos desses parceiros usavam contêineres no NGC, o hub de software da NVIDIA, além de estruturas publicamente disponíveis para seus envios.

Os parceiros da MLPerf representam parte de um ecossistema de quase duas dúzias de provedores de serviços em cloud e OEMs com produtos ou planos para instâncias online, servidores e placas PCIe usando as GPUs NVIDIA A100.

Software Aprovado em Teste Disponível no NGC Hoje Mesmo

A maior parte dos programas de software que a NVIDIA e seus parceiros usaram nos benchmarks mais atuais do MLPerf já está disponível para os clientes no NGC.

O NGC oferece vários contêineres otimizados por GPU, scripts de software, modelos pré-treinados e SDKs. Com eles, cientistas de dados e desenvolvedores podem acelerar os workflows de AI em estruturas populares como a TensorFlow e a PyTorch.

As organizações estão adotando esses contêineres para ganhar tempo e gerar resultados comerciais importantes de verdade. No final, esse é o benchmark mais relevante de todos.

Renderização do artista no topo: o novo DGX SuperPOD da NVIDIA, construído em menos de um mês e com mais de 2.000 GPUs NVIDIA A100, varreu todas as categorias de referência do MLPerf para desempenho em escala entre os produtos comercialmente disponíveis.