Em todo o mundo, as fábricas de IA estão crescendo: novos data centers massivos construídos não para servir páginas da web ou e-mail, mas para treinar e implantar a própria inteligência. Os gigantes da internet investiram bilhões em infraestrutura de IA em escala de nuvem para seus clientes. As empresas estão correndo para construir as bases de IA que gerarão a próxima geração de produtos e serviços. Os governos também estão investindo, ansiosos para aproveitar a IA para medicina personalizada e serviços linguísticos adaptados às populações nacionais.

Bem-vindo à era das fábricas de IA, onde as regras estão sendo reescritas e a fiação não se parece em nada com a internet antiga. Esses não são data centers de hiperescala típicos. Eles são algo completamente diferente. Pense neles como mecanismos de alto desempenho costurados de dezenas a centenas de milhares de GPUs, não apenas construídos, mas orquestrados, operados e ativados como uma única unidade. E essa orquestração? É o jogo inteiro.

Esse data center gigante se tornou a nova unidade de computação, e a maneira como essas GPUs são conectadas define o que essa unidade de computação pode fazer. Uma arquitetura de rede não é suficiente. O que é necessário é um design em camadas com tecnologias de ponta, como óptica co-empacotada que antes parecia ficção científica.

A complexidade não é um bug; é a característica definidora. A infraestrutura de IA está divergindo rapidamente de tudo o que veio antes dela e, se não houver repensar como os tubos se conectam, a escala se desfaz. Erre as camadas de rede e toda a máquina para. Faça certo e obtenha um desempenho extraordinário.

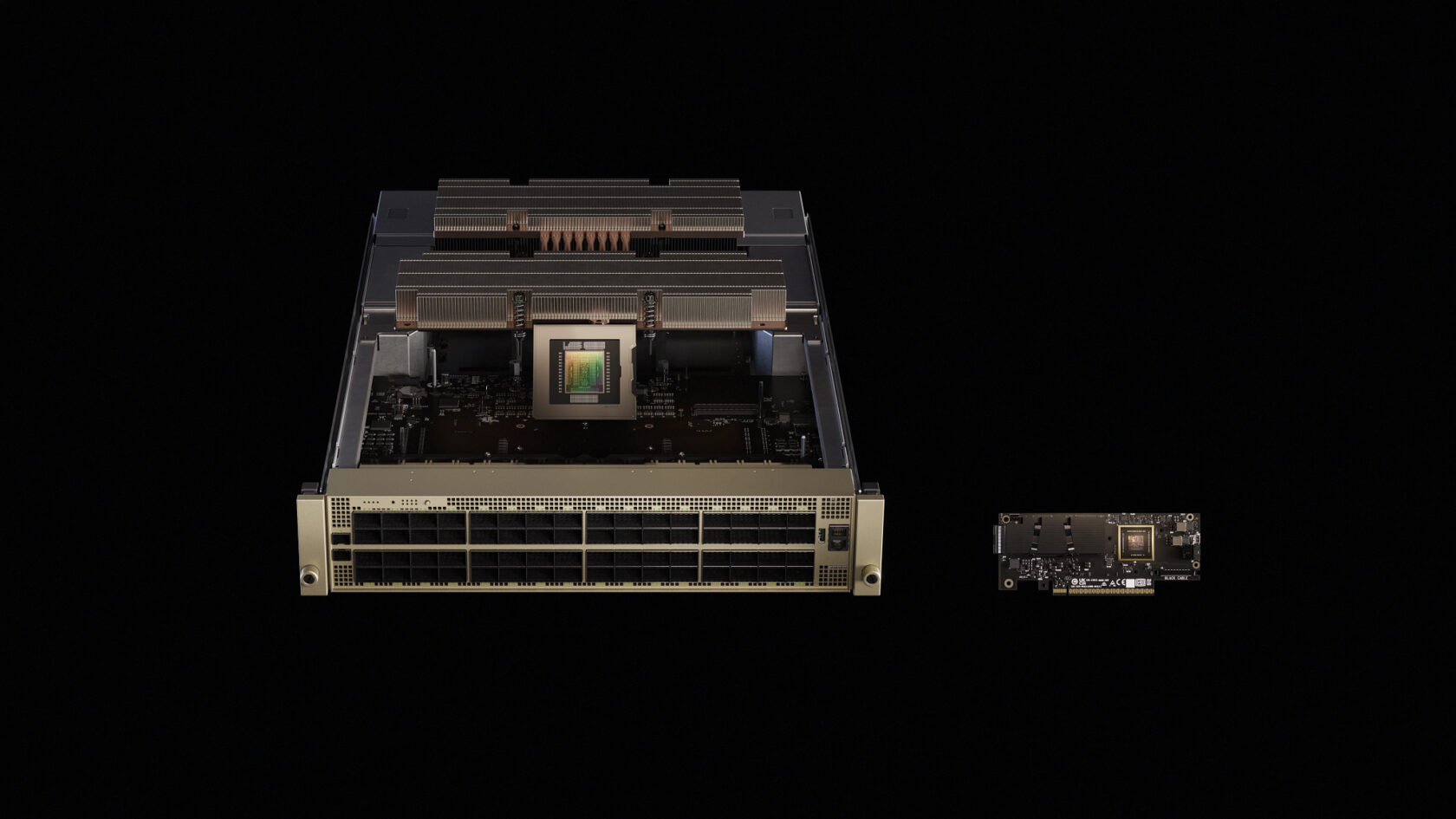

Com essa mudança vem o peso, literalmente. Uma década atrás, os chips eram construídos para serem elegantes e leves. Agora, a aresta de corte se parece com a lombada de cobre de várias centenas de libras de um rack de servidor. Coletores refrigerados a líquido. Barramentos personalizados. Espinhos de cobre. A IA agora exige hardware massivo em escala industrial. E quanto mais profundos os modelos vão, mais essas máquinas aumentam e diminuem.

A coluna NVIDIA NVLink, por exemplo, é construída a partir de mais de 5.000 cabos coaxiais – enrolados firmemente e roteados com precisão. É quase tantos dados por segundo quanto toda a internet. São 130 TB/s de largura de banda de GPU para GPU, totalmente em malha.

Isso não é apenas rápido. É fundamental. A super-estrada da IA agora vive dentro do rack.

O Data Center É O Computador

Treinar os modelos modernos de linguagem grande (LLMs) por trás da IA não é sobre a queima de ciclos em uma única máquina. Trata-se de orquestrar o trabalho de dezenas ou até centenas de milhares de GPUs que são os levantadores pesados da computação de IA.

Esses sistemas dependem de computação distribuída, dividindo cálculos massivos entre nós (servidores individuais), onde cada nó lida com uma fatia da carga de trabalho. No treinamento, essas fatias, normalmente matrizes massivas de números, precisam ser mescladas e atualizadas regularmente. Essa fusão ocorre por meio de operações coletivas, como “all-reduce” (que combina dados de todos os nós e redistribui o resultado) e “all-to-all” (onde cada nó troca dados com todos os outros nós).

Esses processos são suscetíveis à velocidade e capacidade de resposta da rede, o que os engenheiros chamam de latência (atraso) e largura de banda (capacidade de dados), causando paralisações no treinamento.

Para inferência, o processo de execução de modelos treinados para gerar respostas ou previsões, os desafios mudam. Os sistemas de geração aumentada por recuperação, que combinam LLMs com pesquisa, exigem pesquisas e respostas em tempo real. E em ambientes de nuvem, a inferência multilocatário significa manter as cargas de trabalho de diferentes clientes funcionando sem problemas, sem interferência. Isso requer uma rede ultrarrápida e de alto rendimento que possa lidar com uma demanda massiva com isolamento estrito entre os usuários.

A Ethernet tradicional foi projetada para cargas de trabalho de servidor único, não para as demandas de IA distribuída. Tolerar jitter e entrega inconsistente já foi aceitável. Agora, é um gargalo. As arquiteturas tradicionais de switch Ethernet nunca foram projetadas para desempenho consistente e previsível e esse legado ainda molda suas últimas gerações.

A computação distribuída requer uma infraestrutura escalável criada para operação sem jitter, que possa lidar com rajadas de taxa de transferência extrema, fornecer baixa latência, manter o desempenho RDMA previsível e consistente e isolar o ruído da rede. É por isso que a rede InfiniBand é o padrão ouro para supercomputadores de computação de alto desempenho e fábricas de IA.

Com o NVIDIA Quantum InfiniBand, as operações coletivas são executadas dentro da própria rede usando a tecnologia de Scalable Hierarchical Aggregation and Reduction Protocol, dobrando a largura de banda de dados para reduções. Ele usa roteamento adaptativo e controle de congestionamento baseado em telemetria para espalhar fluxos entre caminhos, garantir largura de banda determinística e isolar ruídos. Essas otimizações permitem que o InfiniBand dimensione a comunicação de IA com precisão. É por isso que a infraestrutura NVIDIA Quantum conecta a maioria dos sistemas na lista TOP500 dos supercomputadores mais poderosos do mundo, demonstrando um crescimento de 35% em apenas dois anos.

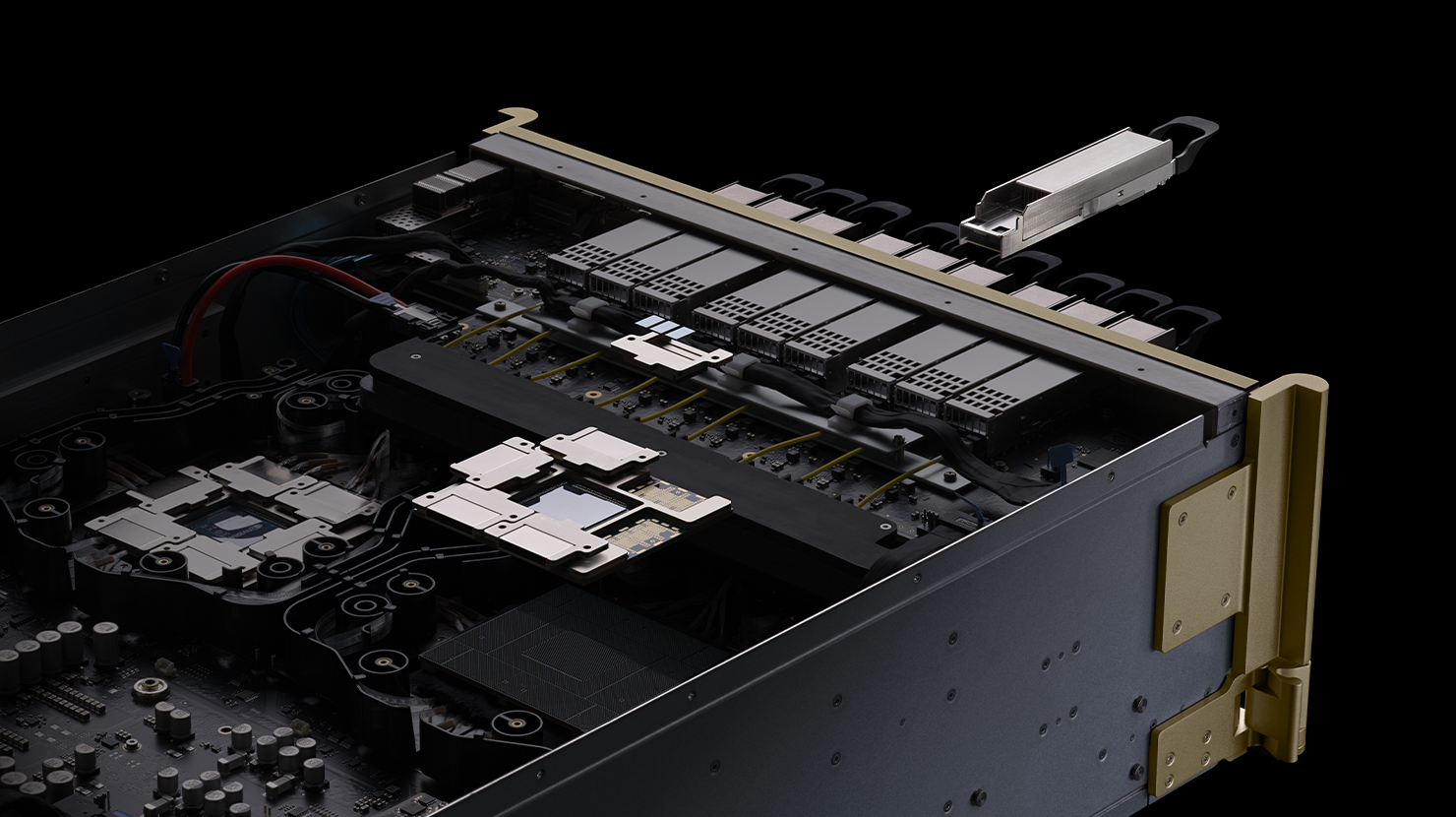

Para clusters que abrangem dezenas de racks, os switches NVIDIA QuantumX800 Infiniband levam o InfiniBand a novos patamares. Cada switch oferece 144 portas de conectividade de 800 Gbps, com SHARPv4 baseado em hardware, roteamento adaptável e controle de congestionamento baseado em telemetria. A plataforma integra fotônica de silício co-empacotada para minimizar a distância entre a eletrônica e a óptica, reduzindo o consumo de energia e a latência. Emparelhado com NVIDIA ConnectX-8 SuperNICs que fornecem 800Gb/s por GPU, essa malha vincula modelos de trilhões de parâmetros e impulsiona a computação na rede.

Mas os hiperescaladores e as empresas investiram bilhões em sua infraestrutura de software Ethernet. Eles precisam de um caminho rápido que use o ecossistema existente para cargas de trabalho de IA. Apresentando o NVIDIA SpectrumX: um novo tipo de Ethernet desenvolvido especificamente para IA distribuída.

SpectrumX Ethernet: Trazendo IA Para a Empresa

O SpectrumX reinventa a Ethernet para IA. Lançado em 2023, o SpectrumX oferece rede sem perdas, roteamento adaptável e isolamento de desempenho. O switch SN5610, baseado no Spectrum4 ASIC, suporta velocidades de porta de até 800Gb/s e usa o controle de congestionamento da NVIDIA para manter 95% da taxa de transferência de dados em escala.

O SpectrumX é Ethernet totalmente baseado em padrões. Além de suportar o Cumulus Linux, ele suporta o sistema operacional de rede SONiC de código aberto, fornecendo flexibilidade aos clientes. Um ingrediente-chave são os NVIDIA SuperNICs baseados em NVIDIA BlueField-3 ou ConnectX-8 que fornecem conectividade RoCE de até 800Gb/s e descarregam reordenação de pacotes e gerenciamento de congestionamento.

O Spectrum-X traz as melhores inovações da InfiniBand, como controle de congestionamento orientado por telemetria, balanceamento de carga adaptável e posicionamento direto de dados, para a Ethernet, permitindo que as empresas escalem para centenas de milhares de GPUs. Sistemas de grande escala com SpectrumX, incluindo o supercomputador de IA mais colossal do mundo, alcançaram 95% de taxa de transferência de dados com degradação zero da latência da aplicação. As malhas Ethernet padrão forneceriam apenas aproximadamente 60% de taxa de transferência devido a colisões de fluxo.

Um Portfólio para ScaleUp e ScaleOut

Nenhuma rede pode atender a todas as camadas de uma fábrica de IA. A abordagem da NVIDIA é combinar a malha certa com a camada certa e, em seguida, unir tudo com software e silício.

NVLink: Escale Dentro do Rack

Dentro de um rack de servidor, as GPUs precisam conversar entre si como se fossem núcleos diferentes no mesmo chip. NVIDIA NVLink e NVLink Switch estendem a memória e a largura de banda da GPU entre os nós. Em um sistema NVIDIA GB300 NVL72, 36 CPUs NVIDIA Grace e 72 GPUs NVIDIA Blackwell Ultra são conectadas em um único domínio NVLink, com uma largura de banda agregada de 130TB/s. A tecnologia NVLink Switch amplia ainda mais essa malha: um único sistema GB300 NVL72 pode oferecer 130TB/s de largura de banda de GPU, permitindo que os clusters suportem 9 vezes a contagem de GPU de um único servidor de 8 GPUs. Com o NVLink, todo o rack se torna uma grande GPU.

Fotônica: O Próximo Salto

Para alcançar milhões de fábricas de IA de GPU, a rede deve quebrar os limites de potência e densidade da óptica conectável. Os switches fotônicos NVIDIA Quantum-X e Spectrum-X integram fotônica de silício diretamente no pacote do switch, fornecendo de 128 a 512 portas de 800Gb/s com larguras de banda totais variando de 100Tb/s a 400Tb/s. Esses switches oferecem 3,5 vezes mais eficiência de energia e resiliência 10 vezes melhor em comparação com a ótica tradicional, abrindo caminho para fábricas de IA em escala de gigawatts.

Cumprindo a Promessa de Padrões Abertos

O SpectrumX e o NVIDIA Quantum InfiniBand são construídos em padrões abertos. O SpectrumX é totalmente Ethernet baseado em padrões com suporte para stacks Ethernet abertos como SONiC, enquanto o NVIDIA Quantum InfiniBand e o Spectrum-X estão em conformidade com as especificações InfiniBand e RDMA over Converged Ethernet (RoCE) da InfiniBand Trade Association. Os principais elementos do stack de software da NVIDIA, incluindo bibliotecas NCCL e DOCA, são executados em uma variedade de hardware, e parceiros como Cisco, Dell Technologies, HPE e Supermicro integram o Spectrum-X em seus sistemas.

Os padrões abertos criam a base para a interoperabilidade, mas os clusters de IA do mundo real exigem uma otimização rígida em todo o stack: GPUs, NICs, switches, cabos e software. Os fornecedores que investem em integração de ponta a ponta oferecem melhor latência e taxa de transferência. O SONiC, o sistema operacional de rede de código aberto reforçado em data centers de hiperescala, elimina o licenciamento e o bloqueio de fornecedores e permite uma personalização intensa, mas as operadoras ainda escolhem pacotes de hardware e software específicos para atender às necessidades de desempenho da IA. Na prática, os padrões abertos por si só não oferecem desempenho determinístico; eles precisam de inovação em camadas.

Rumo às Fábricas de IA de Milhões de GPUs

As fábricas de IA estão crescendo rapidamente. Os governos da Europa estão construindo sete fábricas nacionais de IA, enquanto provedores de nuvem e empresas no Japão, Índia e Noruega estão implementando a infraestrutura de IA com tecnologia NVIDIA. O próximo horizonte são instalações de classe gigawatt com um milhão de GPUs. Para chegar lá, a rede deve evoluir de uma reflexão tardia para um pilar da infraestrutura de IA.

A lição da era do data center de gigawatts é simples: o data center agora é o computador. O NVLink une GPUs dentro do rack. O NVIDIA Quantum InfiniBand os dimensiona através dele. O Spectrum-X traz esse desempenho para mercados mais amplos. A fotônica de silício o torna sustentável. Tudo está aberto onde importa, otimizado onde é importante.