As empresas que buscam aproveitar o poder da IA precisam de modelos personalizados adaptados às necessidades específicas de seu setor.

O NVIDIA AI Foundry é um serviço que permite que as empresas usem dados, computação acelerada e ferramentas de software para criar e implantar modelos personalizados que podem turbinar suas iniciativas de IA generativa.

Assim como a TSMC fabrica chips projetados por outras empresas, o NVIDIA AI Foundry fornece a infraestrutura e as ferramentas para que outras empresas desenvolvam e personalizem modelos de IA usando DGX Cloud, modelos básicos, software NVIDIA NeMo, experiência da NVIDIA, bem como ferramentas e suporte do ecossistema.

A principal diferença é o produto: a TSMC produz chips semicondutores físicos, enquanto a NVIDIA AI Foundry ajuda a criar modelos personalizados. Ambos permitem a inovação e se conectam a um vasto ecossistema de ferramentas e parceiros.

As empresas podem usar o NVIDIA AI Foundry para personalizar modelos de comunidade aberta, incluindo a nova coleção Llama 3.1, bem como NVIDIA Nemotron, CodeGemma by Google DeepMind, CodeLlama, Gemma by Google DeepMind, Mistral, Mixtral, Phi-3, StarCoder2 e outros.

Pioneiros do Setor Impulsionam a Inovação em IA

Os líderes do setor Amdocs, Capital One, Getty Images, KT, Hyundai Motor Company, SAP, ServiceNow e Snowflake estão entre os primeiros a usar o NVIDIA AI Foundry. Esses pioneiros estão preparando o terreno para uma nova era de inovação orientada por IA em software, tecnologia, comunicações e mídia corporativa.

“As empresas que implantam IA podem obter uma vantagem competitiva com modelos personalizados que incorporam conhecimento do setor e de negócios”, disse Jeremy Barnes, vice-presidente de produtos de IA da ServiceNow. “A ServiceNow está usando o NVIDIA AI Foundry para ajustar e implantar modelos que podem se integrar facilmente aos workflows existentes dos clientes.”

Os Pilares do NVIDIA AI Foundry

O NVIDIA AI Foundry é suportado pelos principais pilares de modelos de base, software empresarial, computação acelerada, suporte especializado e um amplo ecossistema de parceiros.

Seu software inclui modelos de base de IA da NVIDIA e da comunidade de IA, bem como a plataforma completa de software NVIDIA NeMo para desenvolvimento rápido de modelos.

O músculo computacional do NVIDIA AI Foundry é o NVIDIA DGX Cloud, uma rede de recursos de computação acelerada coprojetada com as principais nuvens públicas do mundo: Amazon Web Services, Google Cloud e Oracle Cloud Infrastructure. Com o DGX Cloud, os clientes do AI Foundry podem desenvolver e ajustar aplicações personalizados de IA generativa com facilidade e eficiência sem precedentes e dimensionar suas iniciativas de IA conforme necessário, sem investimentos iniciais significativos em hardware. Essa flexibilidade é crucial para empresas que buscam se manter ágeis em um mercado em rápida mudança.

Se um cliente do NVIDIA AI Foundry precisar de assistência, os especialistas do NVIDIA AI Enterprise estão à disposição para ajudar. Os especialistas da NVIDIA podem orientar os clientes em cada uma das etapas necessárias para criar, ajustar e implantar seus modelos com dados proprietários, garantindo que os modelos estejam totalmente alinhados com seus requisitos de negócios.

Os clientes do NVIDIA AI Foundry têm acesso a um ecossistema global de parceiros que podem fornecer uma gama completa de suporte. Accenture, Deloitte, Infosys, Tata Consultancy Services e Wipro estão entre os parceiros da NVIDIA que oferecem serviços de consultoria AI Foundry que abrangem design, implementação e gerenciamento de projetos de transformação digital orientados por IA. A Accenture é a primeira a oferecer sua própria oferta baseada em AI Foundry para desenvolvimento de modelos personalizados, o framework Accenture AI Refinery.

Além disso, parceiros de entrega de serviços, como Data Monsters, Quantiphi, Slalom e SoftServe, ajudam as empresas a navegar pelas complexidades da integração da IA em seus cenários de IT existentes, garantindo que as aplicações de IA sejam escaláveis, seguros e alinhados com os objetivos de negócios.

Os clientes podem desenvolver modelos NVIDIA AI Foundry para produção usando plataformas AIOps e MLOps de parceiros da NVIDIA, incluindo ActiveFence, AutoAlign, Cleanlab, DataDog, Dataiku, Dataloop, DataRobot, Deepchecks, Domino Data Lab, Fiddler AI, Giskard, New Relic, Scale, Tumeryk e Weights & Biases.

Os clientes podem produzir seus modelos do AI Foundry como microsserviços de inferência NVIDIA NIM, que incluem o modelo personalizado, mecanismos otimizados e uma API padrão, para serem executados em sua infraestrutura acelerada preferida.

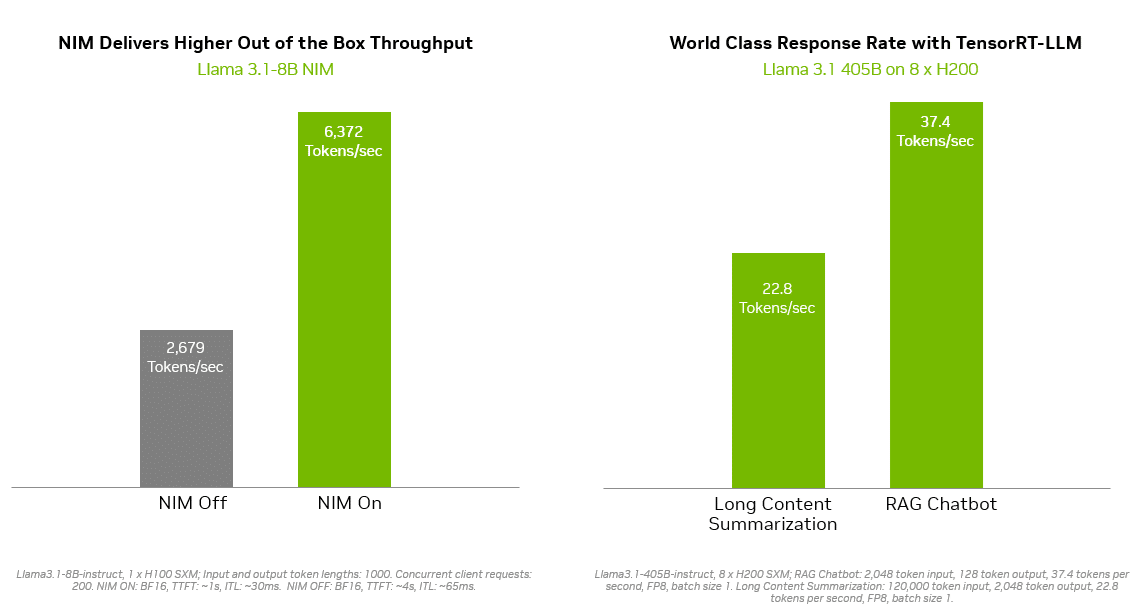

Soluções de inferência como o NVIDIA TensorRT-LLM oferecem eficiência aprimorada para modelos Llama 3.1 para minimizar a latência e maximizar a taxa de transferência. Isso permite que as empresas gerem tokens mais rapidamente, reduzindo o custo total de execução dos modelos em produção. O suporte e a segurança de nível empresarial são fornecidos pelo pacote de software NVIDIA AI Enterprise.

A ampla gama de opções de implantação inclui Sistemas Certificados pela NVIDIA de parceiros globais de fabricação de servidores, incluindo Cisco, Dell Technologies, Hewlett Packard Enterprise, Lenovo e Supermicro, bem como instâncias de nuvem da Amazon Web Services, Google Cloud e Oracle Cloud Infrastructure.

Além disso, a Together AI, uma nuvem líder em aceleração de IA, anunciou hoje que permitirá que seu ecossistema de mais de 100.000 desenvolvedores e empresas use seu stack de inferência acelerada por GPU NVIDIA para implantar endpoints Llama 3.1 e outros modelos abertos na DGX Cloud.

“Toda empresa que executa aplicações de IA generativa deseja uma experiência de usuário mais rápida, com maior eficiência e menor custo”, disse Vipul Ved Prakash, fundador e CEO da Together AI. “Agora, desenvolvedores e empresas que usam o Together Inference Engine podem maximizar o desempenho, a escalabilidade e a segurança no NVIDIA DGX Cloud.”

NVIDIA NeMo Acelera e Simplifica o Desenvolvimento de Modelos Personalizados

Com o NVIDIA NeMo integrado ao AI Foundry, os desenvolvedores têm ao seu alcance as ferramentas necessárias para selecionar dados, personalizar modelos básicos e avaliar o desempenho. As tecnologias NeMo incluem:

- NeMo Curator é uma biblioteca de curadoria de dados acelerada por GPU que melhora o desempenho do modelo de IA generativa preparando conjuntos de dados de alta qualidade e em grande escala para pré-treinamento e ajuste fino.

- NeMo Customizer é um microsserviço escalável e de alto desempenho que simplifica o ajuste fino e o alinhamento de LLMs para casos de uso específicos de domínio.

- NeMo Evaluator fornece avaliação automática de modelos de IA generativa em benchmarks acadêmicos e personalizados em qualquer nuvem ou data center acelerado.

- NeMo Guardrails orquestra o gerenciamento de diálogos, oferecendo suporte à precisão, adequação e segurança em aplicações inteligentes com grandes modelos de linguagem para fornecer proteções para aplicações de IA generativa.

Usando a plataforma NeMo no NVIDIA AI Foundry, as empresas podem criar modelos de IA personalizados que são precisamente adaptados às suas necessidades. Essa personalização permite um melhor alinhamento com os objetivos estratégicos, maior precisão na tomada de decisões e maior eficiência operacional. Por exemplo, as empresas podem desenvolver modelos que entendam o jargão específico do setor, cumpram os requisitos regulatórios e se integrem perfeitamente aos fluxos de trabalho existentes.

“Como próximo passo de nossa parceria, a SAP planeja usar a plataforma NeMo da NVIDIA para ajudar as empresas a acelerar a produtividade orientada por IA impulsionada pelo SAP Business AI”, disse Philipp Herzig, diretor de IA da SAP.

As empresas podem implantar seus modelos de IA personalizados em produção com microsserviços de inferência NVIDIA NeMo Retriever NIM. Isso ajuda os desenvolvedores a buscar dados proprietários para gerar respostas informadas para suas aplicações de IA com geração aumentada por recuperação (RAG).

“A IA segura e confiável não é negociável para empresas que aproveitam a IA generativa, com precisão de recuperação impactando diretamente a relevância e a qualidade das respostas geradas nos sistemas RAG”, disse Baris Gultekin, chefe de IA da Snowflake. “O Snowflake Cortex AI aproveita o NeMo Retriever, um componente do NVIDIA AI Foundry, para fornecer às empresas respostas fáceis, eficientes e confiáveis usando seus dados personalizados.”

Modelos Personalizados Geram Vantagem Competitiva

Uma das principais vantagens do NVIDIA AI Foundry é sua capacidade de enfrentar os desafios exclusivos enfrentados pelas empresas na adoção da IA. Os modelos genéricos de IA podem ficar aquém de atender às necessidades específicas de negócios e aos requisitos de segurança de dados. Os modelos personalizados de IA, por outro lado, oferecem flexibilidade, adaptabilidade e desempenho superiores, tornando-os ideais para empresas que buscam obter uma vantagem competitiva.

Saiba mais sobre como o NVIDIA AI Foundry permite que as empresas aumentem a produtividade e a inovação.