Graças aos fones de ouvido, você pode fazer chamadas em qualquer lugar enquanto faz qualquer coisa. Mas há um problema: as pessoas que estão do outro lado da chamada também ouvem tudo, do barulho do aspirador de pó do seu colega de quarto a conversas de fundo no café de onde você está trabalhando.

Agora, um trabalho feito por um trio de estudantes de pós-graduação na Universidade de Washington que passaram a pandemia confinados juntos em um apartamento barulhento, permite que as pessoas que estão do outro lado da chamada ouçam apenas você, sem escutar todos os barulhos que estão ao seu redor.

Os usuários descobriram que o sistema, chamado de “ClearBuds”, apresentado no mês passado na Conferência Internacional ACM sobre Sistemas Móveis, Aplicações e Serviços, melhorou muito a supressão de ruídos de fundo em comparação a uma alternativa disponível no mercado.

“Você está tirando o áudio de fundo da mesma forma que pode tirar sua imagem de fundo em uma videoconferência”, explicou Vivek Jayaram, estudante de doutorado na Escola Paul G. Allen de Ciência da Computação e Engenharia.

Descrito em um artigo escrito em coautoria com os três colegas de quarto, todos estudantes de pós-graduação em ciência da computação e engenharia da Universidade de Washington, Maruchi Kim, Ishan Chatterjee e Jayaram, o ClearBuds tem duas grandes diferenças em relação aos outros fones de ouvido sem fio.

Em primeiro lugar, o ClearBuds usa dois microfones por fone de ouvido.

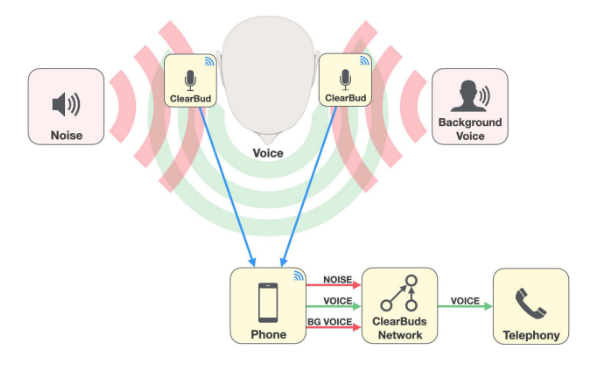

Enquanto a maioria dos fones de ouvido usa dois microfones no mesmo fone, o ClearBuds usa um microfone de ambos os fones de ouvido e cria dois fluxos de áudio.

Isso cria uma resolução espacial maior para o sistema separar melhor os sons que vêm de diferentes direções, explicou Kim. Em outras palavras, torna mais fácil para o sistema escolher a voz do usuário do fone de ouvido.

Em segundo lugar, a equipe criou um algoritmo de rede neural que pode ser executado em um celular para processar os fluxos de áudio para identificar quais sons precisam ser melhorados e quais precisam ser suprimidos.

Para fazer isso, os pesquisadores contaram com duas redes neurais separadas.

A primeira rede neural suprime tudo que não seja uma voz humana.

A segunda melhora a voz da pessoa que está falando. A pessoa que está falando pode ser identificada porque vem de microfones em ambos os fones de ouvido ao mesmo tempo.

Juntos, eles efetivamente mascaram o ruído de fundo e garantem que o usuário do fone de ouvido seja ouvido em voz alta e clara.

Embora o software criado pelos pesquisadores tenha sido leve o suficiente para ser executado em um dispositivo móvel, eles contaram com uma GPU de desktop NVIDIA TITAN para treinar as redes neurais. Eles usaram amostras de áudio sintéticas e áudio real, e o treinamento levou menos de um dia.

E os resultados, relataram os usuários, foram muito melhores em comparação com os fones de ouvido disponíveis no mercado, além de estarem ganhando reconhecimento em todo o setor.

Na conferência ACM MobSys 2022 realizada no mês passado, a equipe ficou em segundo lugar por melhor artigo. Além de Kim, Chatterjee e Jayarm, os coautores do artigo incluíram Ira Kemelmacher-Shlizerman, professora-adjunta da Allen School; Shwetak Patel, professor da Allen School e do departamento de engenharia elétrica e de computação; e Shyam Gollakota e Steven Seitz, ambos professores da Allen School.

Leia o artigo completo aqui: https://dl.acm.org/doi/10.1145/3498361.3538933

Para ter certeza, o sistema descrito no artigo não pode ser adotado imediatamente. Embora muitos fones de ouvido tenham dois microfones por fone, eles só transmitem áudio de um dos fones. Os padrões do setor estão apenas acompanhando a ideia de processar vários fluxos de áudio a partir de fones de ouvido.

No entanto, os pesquisadores têm esperança de que seu trabalho, que é de código aberto, inspire outras pessoas a associar redes neurais e microfones para fornecer chamadas de áudio de melhor qualidade.

As ideias também podem ser úteis para isolar e melhorar conversas que ocorrem sobre alto-falantes inteligentes, aproveitando-as para conjuntos de microfones ad hoc, disse Kim, e até mesmo para rastrear locais de robôs ou missões de busca e salvamento.

Parece bom para nós.

Crédito da imagem em destaque: Raymond Smith, Universidade de Washington