Nota do editor: Esta postagem faz parte da série IA Decodificada, que desmistifica a IA ao tornar a tecnologia mais acessível e que apresenta novos hardware, software, ferramentas e acelerações para usuários de PC RTX.

A demanda por ferramentas para simplificar e otimizar o desenvolvimento de IA generativa está disparando. Aplicações baseadas em geração aumentada de recuperação (RAG) — uma técnica para melhorar a precisão e a confiabilidade de modelos de IA generativa com fatos obtidos de fontes externas especificadas — e modelos personalizados estão permitindo que os desenvolvedores ajustem os modelos de IA às suas necessidades específicas.

Embora esse trabalho possa ter exigido uma configuração complexa no passado, novas ferramentas estão tornando-o mais fácil do que nunca.

O NVIDIA AI Workbench simplifica os fluxos de trabalho de desenvolvedores de IA ajudando os usuários a criar seus próprios projetos RAG, personalizar modelos e muito mais. Ele faz parte do RTX AI Toolkit — um conjunto de ferramentas e kits de desenvolvimento de software para personalizar, otimizar e implementar recursos de IA — lançado na COMPUTEX no início deste mês. O AI Workbench remove a complexidade de tarefas técnicas que podem descarrilar especialistas e interromper iniciantes.

O que é o NVIDIA AI Workbench?

Disponível gratuitamente, o NVIDIA AI Workbench permite que os usuários desenvolvam, experimentem, testem e criem protótipos de aplicativos de IA em sistemas de GPU de sua escolha — de notebooks e workstations a data centers e nuvem. Ele oferece uma nova abordagem para criar, usar e compartilhar ambientes de desenvolvimento habilitados para GPU entre pessoas e sistemas.

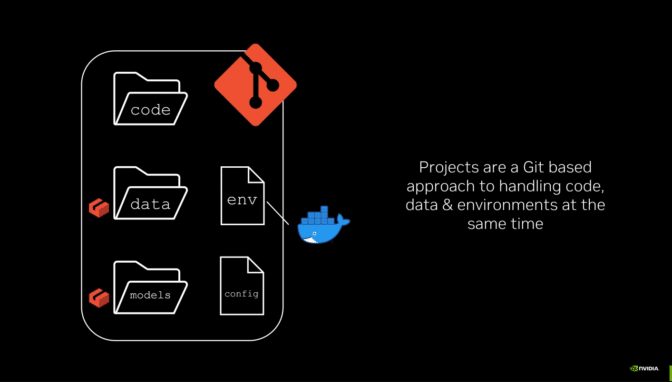

Uma instalação simples coloca os usuários em funcionamento com o AI Workbench em uma máquina local ou remota em apenas alguns minutos. Os usuários podem então iniciar um novo projeto ou replicar um dos exemplos no GitHub. Tudo funciona por meio do GitHub ou GitLab, para que os usuários possam colaborar e distribuir o trabalho facilmente. Saiba mais sobre como começar a usar o AI Workbench.

Como o AI Workbench ajuda a enfrentar os desafios dos projetos de IA

O desenvolvimento de cargas de trabalho de IA pode exigir processos manuais, muitas vezes complexos, desde o início.

Configurar GPUs, atualizar drivers e gerenciar incompatibilidades de versão pode ser trabalhoso. Reproduzir projetos em diferentes sistemas pode exigir a replicação de processos manuais repetidamente. Inconsistências ao replicar projetos, como problemas com fragmentação de dados e controle de versão, podem dificultar a colaboração. Processos de configuração variados, movimentação de credenciais e segredos e alterações no ambiente, dados, modelos e locais de arquivo podem limitar a portabilidade dos projetos.

O AI Workbench torna mais fácil para cientistas de dados e desenvolvedores gerenciarem seu trabalho e colaborarem entre plataformas heterogêneas. Ele integra e automatiza vários aspectos do processo de desenvolvimento, oferecendo:

- Facilidade de configuração: o AI Workbench simplifica o processo de configuração de um ambiente de desenvolvedor acelerado por GPU, mesmo para usuários com conhecimento técnico limitado.

- Colaboração perfeita: o AI Workbench integra-se com ferramentas de controle de versão e gerenciamento de projetos como GitHub e GitLab, reduzindo o atrito durante a colaboração.

- Consistência ao dimensionar do local para a nuvem: o AI Workbench garante consistência em vários ambientes, oferecendo suporte ao dimensionamento para cima ou para baixo de workstations ou PCs locais para data centers ou para a nuvem.

RAG para documentos, mais fácil do que nunca

A NVIDIA oferece projetos de Workbench de desenvolvimento de amostra para ajudar os usuários a começar com o AI Workbench. O Hybrid RAG Workbench Project é um exemplo: ele executa um aplicativo web RAG personalizado baseado em texto com os documentos de um usuário em seu workstation local, PC ou sistema remoto.

Cada Projeto do Workbench é executado em um “contêiner” — software que inclui todos os componentes necessários para executar o aplicativo de IA. O exemplo RAG híbrido emparelha um frontend de interface de bate-papo Gradio na máquina host com um servidor RAG em contêiner — o backend que atende à solicitação de um usuário e roteia consultas de e para o banco de dados de vetores e o modelo de linguagem grande selecionado.

Este Projeto Workbench suporta uma ampla variedade de LLMs disponíveis na página do GitHub da NVIDIA. Além disso, a natureza híbrida do projeto permite que os usuários selecionem onde executar a inferência.

Os desenvolvedores podem executar o modelo de incorporação na máquina host e executar a inferência localmente em um servidor de inferência de geração de texto Hugging Face, em recursos de nuvem de destino usando endpoints de inferência NVIDIA, como o catálogo de API NVIDIA, ou com microsserviços de auto-hospedagem, como NVIDIA NIM ou serviços de terceiros.

O hybrid RAG Workbench Project também inclui:

- Métricas de desempenho: Os usuários podem avaliar como as consultas de usuários baseadas em RAG e não baseadas em RAG desempenham em cada modo de inferência. As métricas rastreadas incluem Tempo de Recuperação, Tempo para o Primeiro Token (TTFT) e Velocidade do Token.

- Transparência de recuperação: um painel mostra os trechos exatos de texto — recuperados do conteúdo mais contextualmente relevante no banco de dados de vetores — que estão sendo alimentados no LLM e melhorando a relevância da resposta para a consulta de um usuário.

- Personalização da resposta: as respostas podem ser ajustadas com uma variedade de parâmetros, como máximo de tokens a serem gerados, penalidade de temperatura e frequência.

Para começar com este projeto, basta instalar o AI Workbench em um sistema local. O RAG Workbench Project híbrido pode ser trazido do GitHub para a conta do usuário e duplicado para o sistema local.

Mais recursos estão disponíveis no guia do usuário da IA Decodificada. Além disso, os membros da comunidade fornecem tutoriais em vídeo úteis, como o de Joe Freeman abaixo.

Personalize, otimize, implemente

Os desenvolvedores geralmente buscam personalizar modelos de IA para casos de uso específicos. O ajuste fino, uma técnica que altera o modelo treinando-o com dados adicionais, pode ser útil para transferência de estilo ou alteração do comportamento do modelo. O AI Workbench também ajuda no ajuste fino.

O Llama-factory AI Workbench Project habilita o QLoRa, um método de ajuste fino que minimiza os requisitos de memória, para uma variedade de modelos, bem como a quantização do modelo por meio de uma interface gráfica de usuário simples. Os desenvolvedores podem usar conjuntos de dados públicos ou seus próprios para atender às necessidades de seus aplicativos.

Uma vez que o ajuste fino esteja concluído, o modelo pode ser quantizado para melhor desempenho e uma pegada de memória menor, então implantado em aplicativos nativos do Windows para inferência local ou no NVIDIA NIM para inferência em nuvem. Encontre um tutorial completo para este projeto no repositório NVIDIA RTX AI Toolkit.

Verdadeiramente híbrido — execute cargas de trabalho de IA em qualquer lugar

O Hybrid-RAG Workbench Project descrito acima é híbrido em mais de uma maneira. Além de oferecer uma escolha de modo de inferência, o projeto pode ser executado localmente em workstations NVIDIA RTX e PCs GeForce RTX, ou escalado para servidores de nuvem remotos e data centers.

A capacidade de executar projetos em sistemas de escolha do usuário — sem a sobrecarga de configuração da infraestrutura — se estende a todos os Projetos do Workbench. Encontre mais exemplos e instruções para ajuste fino e personalização no guia de início rápido do AI Workbench.

A IA generativa está transformando jogos, videoconferências e experiências interativas de todos os tipos. Entenda o que há de novo e o que vem por aí assinando a newsletter de IA Decodificada.