Uma nova pesquisa da Universidade de Washington está refinando modelos climáticos de IA usando deep learning para previsões mais precisas e previsões de longo prazo. O estudo, publicado na Geophysical Research Letters, mostra como o ajuste dos dados atmosféricos iniciais permite que modelos avançados de IA estendam os limites atuais de previsão. À medida que o clima extremo se torna cada vez mais severo e frequente devido às mudanças climáticas, dar aos governos, empresas, público e equipes de emergência mais tempo para se preparar para desastres naturais, como inundações, ondas de calor ou furacões, pode ajudar a reduzir a perda de vidas e propriedades.

“Se um modelo meteorológico perfeito recebe condições iniciais ligeiramente imperfeitas, o erro se acumula com o tempo e resulta em uma previsão imprecisa”, disse o principal autor Trent Vonich, candidato a doutorado na Universidade de Washington. “Isso é especialmente verdadeiro ao modelar um sistema caótico como a atmosfera da Terra. Recentemente, tem havido um grande foco em fazer modelos melhores, ignorando um pouco o fato de que um modelo perfeito é apenas metade do problema. Os modelos de machine learning nos ajudam a resolver isso porque são totalmente diferenciáveis de ponta a ponta, permitindo-nos capturar interações não lineares entre entradas e saídas, algo que as técnicas legadas não podem fazer.”

Embora os sistemas de previsão do tempo de IA de última geração, como o GraphCast do Google e o Pangu-Weather da Huawei, prevejam com segurança o clima futuro com até 10 dias de antecedência, eles são limitados pela precisão dos dados iniciais impulsionados em seu sistema.

Esses modelos foram treinados no enorme conjunto de dados de reanálise ERA5 contendo petabytes de informações. O conjunto de dados captura temperatura a cada hora, velocidade do vento, umidade, pressão do ar, precipitação e cobertura de nuvens em uma grade global de 37 níveis de pressão. Inclui condições meteorológicas históricas, que remontam a 1979, e dados quase em tempo real.

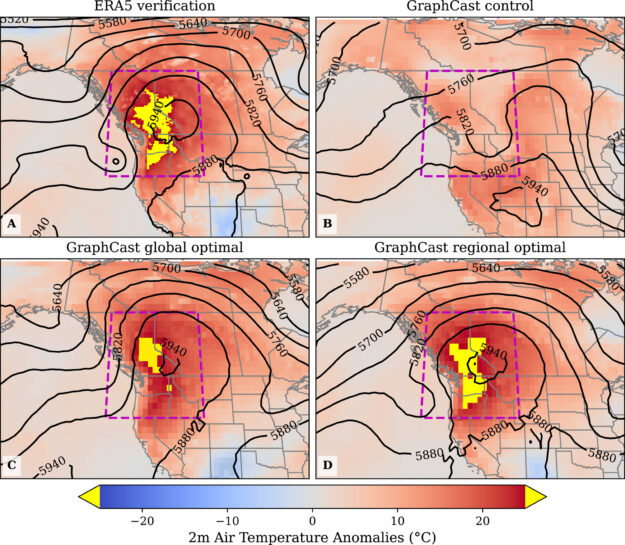

Os pesquisadores se concentraram em refinar as variáveis atmosféricas iniciais que levaram à onda de calor do noroeste do Pacífico de junho de 2021 para melhorar a precisão desse evento extremo. Eles aplicaram a otimização não linear usando o framework JAX acelerado por GPU para otimizar os dados.

De acordo com Vonich, leva apenas 20 minutos para realizar 100 atualizações de condições iniciais em uma GPU NVIDIA A100 Tensor Core.

Os pesquisadores testaram a precisão de seu framework usando dados atmosféricos capturados durante a onda de calor do noroeste do Pacífico de 2021, que foram excluídos do conjunto de dados de treinamento original. Os dados otimizados reduziram os erros de previsão de 10 dias em 90%, prevendo com sucesso a intensidade e o tempo da onda de calor. Também mais do que dobrou a janela de previsão, melhorando as previsões não otimizadas com até 23 dias de antecedência.

“Esta pesquisa pode mostrar que observações e medições meteorológicas mais precisas podem ser tão importantes quanto o desenvolvimento de modelos melhores”, disse Vonich. “Se essa técnica puder ser usada para identificar vieses sistemáticos nas condições iniciais, poderá ter um impacto imediato na melhoria das previsões operacionais. Além disso, mais tempo de espera permite uma maior preparação para as comunidades. Aviação, transporte marítimo e inúmeras outras indústrias também dependem de previsões meteorológicas precisas. As melhorias também podem se traduzir em um benefício econômico para eles.”

Acompanhe o estudo Limite de Previsibilidade da Onda de Calor do Noroeste do Pacífico de 2021 da Análise de Sensibilidade de Deep Learning.