O DeepSeek-R1 é um modelo aberto com recursos de raciocínio de última geração. Em vez de oferecer respostas diretas, modelos de raciocínio como o DeepSeek-R1 realizam várias passagens de inferência sobre uma consulta, conduzindo métodos de cadeia de pensamento, consenso e pesquisa para gerar a melhor resposta.

Executar essa sequência de passes de inferência usando a razão para chegar à melhor resposta é conhecido como escala de tempo de teste. O DeepSeek-R1 é um exemplo perfeito dessa lei de escala, demonstrando por que a computação acelerada é crítica para as demandas da inferência de IA baseada em agentes.

À medida que os modelos podem “pensar” iterativamente sobre o problema, eles criam mais tokens de saída e ciclos de geração mais longos, de modo que a qualidade do modelo continua a ser dimensionada. A computação significativa em tempo de teste é fundamental para permitir inferência em tempo real e respostas de alta qualidade de modelos de raciocínio como o DeepSeek-R1, exigindo implantações de inferência maiores.

O R1 oferece precisão líder para tarefas que exigem inferência lógica, raciocínio, matemática, codificação e compreensão de linguagem, além de oferecer alta eficiência de inferência.

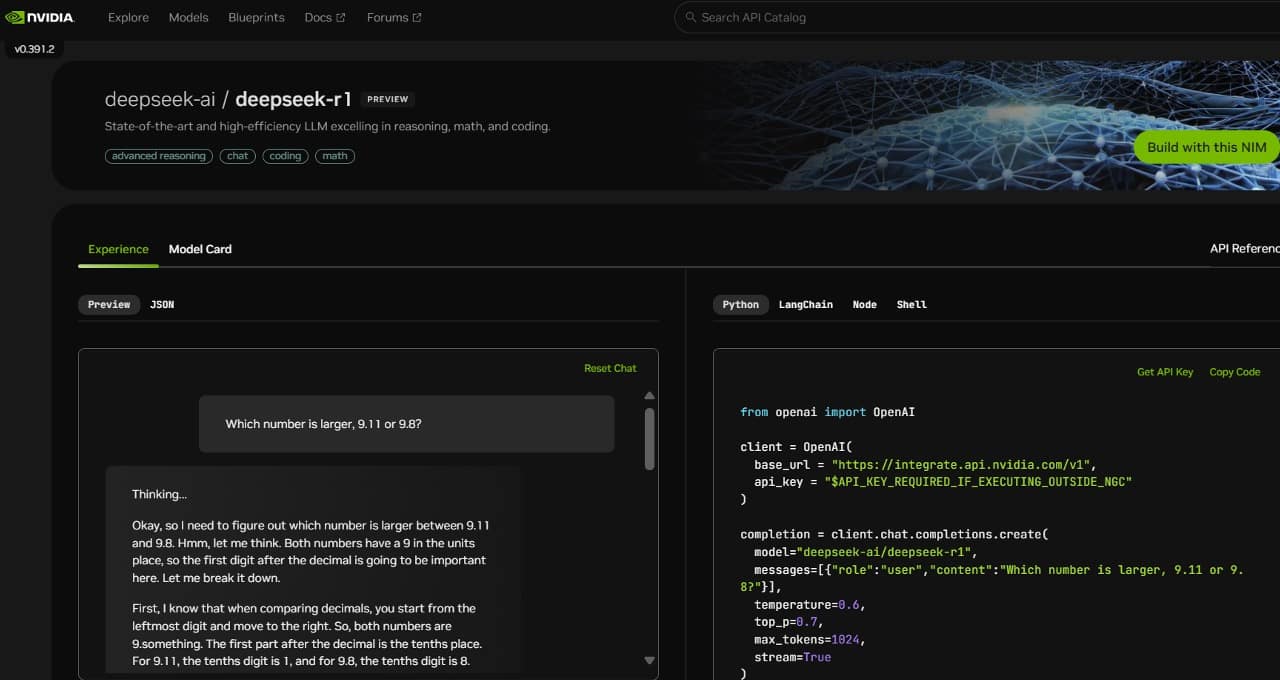

Para ajudar os desenvolvedores a experimentar com segurança esses recursos e criar seus próprios agentes especializados, o modelo DeepSeek-R1 de 671 bilhões de parâmetros agora está disponível como uma prévia do microsserviço NVIDIA NIM no build.nvidia.com. O microsserviço DeepSeek-R1 NIM pode fornecer até 3.872 tokens por segundo em um único sistema NVIDIA HGX H200.

Os desenvolvedores podem testar e experimentar a interface de programação de aplicação (API), que deve estar disponível em breve como um microsserviço NIM para download, parte da plataforma de software NVIDIA AI Enterprise.

O microsserviço NIM DeepSeek-R1 simplifica as implantações com suporte para APIs padrão do setor. As empresas podem maximizar a segurança e a privacidade dos dados executando o microsserviço NIM em sua infraestrutura de computação acelerada preferida. Usando o NVIDIA AI Foundry com o software NVIDIA NeMo, as empresas também poderão criar microsserviços DeepSeek-R1 NIM personalizados para agentes especializados em IA.

DeepSeek-R1: Um Exemplo Perfeito de Escalonamento de Tempo de Teste

O DeepSeek-R1 é um modelo de grande mistura de especialistas (MoE). Ele incorpora impressionantes 671 bilhões de parâmetros, 10 vezes mais do que muitos outros LLMs populares de código aberto, suportando um grande comprimento de contexto de entrada de 128.000 tokens. O modelo também usa um número extremo de especialistas por camada. Cada camada do R1 tem 256 especialistas, com cada token encaminhado para oito especialistas separados em paralelo para avaliação.

Fornecer respostas em tempo real para R1 requer muitas GPUs com alto desempenho de computação, conectadas com comunicação de alta largura de banda e baixa latência para rotear tokens de prompt para todos os especialistas para inferência. Combinado com as otimizações de software disponíveis no microsserviço NVIDIA NIM, um único servidor com oito GPUs H200 conectadas usando NVLink e NVLink Switch pode executar o modelo DeepSeek-R1 completo de 671 bilhões de parâmetros em até 3.872 tokens por segundo. Essa taxa de transferência é possível usando o FP8 Transformer Engine da arquitetura NVIDIA Hopper em todas as camadas e os 900GB/s de largura de banda NVLink para comunicação especializada em MoE.

Obter todas as operações de ponto flutuante por segundo (FLOPS) de desempenho de uma GPU é fundamental para a inferência em tempo real. A arquitetura NVIDIA Blackwell de próxima geração dará ao escalonamento em tempo de teste em modelos de raciocínio como o DeepSeek-R1 um impulso gigante com Tensor Cores de quinta geração que podem fornecer até 20 petaflops de desempenho de computação FP4 de pico e um domínio NVLink de 72 GPUs especificamente otimizado para inferência.

Comece Agora com o Microsserviço NIM DeepSeek-R1

Os desenvolvedores podem experimentar o microsserviço DeepSeek-R1 NIM, agora disponível no build.nvidia.com. Veja como funciona:

Com o NVIDIA NIM, as empresas podem implantar o DeepSeek-R1 com facilidade e garantir a alta eficiência necessária para sistemas de IA agente.

Consulte o aviso sobre informações sobre produtos de software.