Já pensou levantar da cama, ligar o notebook, abrir a câmera e estar pronto para todas as videochamadas? Com a ajuda da AI desenvolvida pelos pesquisadores da NVIDIA, você pode.

O Vid2Vid Cameo, um dos modelos de deep learning por trás do kit de desenvolvimento de software NVIDIA Maxine para videochamadas, usa redes generativas adversariais (GANs – Generative Adversarial Networks) para sintetizar vídeos realistas com avatares usando apenas a imagem 2D de uma pessoa.

Para usá-lo, os participantes precisam fazer upload de uma imagem de referência, que pode ser uma foto real da pessoa ou um avatar animado, antes de entrar em uma videochamada. Durante a reunião, o modelo de AI captura o movimento em tempo real de cada pessoa e o aplica na imagem estática carregada anteriormente.

Assim, os participantes da reunião podem fazer upload de uma foto sua e aparecer como se estivessem usando roupa social, mesmo estando de pijama e com os cabelos bagunçados. A AI associa os movimentos faciais do usuário à foto de referência. Quando a pessoa vira para a esquerda, a tecnologia ajusta o ponto de vista para que fique parecendo que o participante está de frente para a câmera.

Além de ajudar os participantes a melhorar sua aparência, essa técnica de AI também diminui em até 10 vezes a largura de banda necessária para videochamadas, evitando travamentos e atrasos. Em breve, ela estará disponível no SDK NVIDIA Video Codec sob o nome de AI Face Codec.

“A largura de banda da internet de muitas pessoas é limitada, mas elas ainda querem fazer videochamadas fluidas com a família e os amigos. Além de ajudá-los, a tecnologia também pode ser usada para auxiliar o trabalho de animadores, editores de fotos e desenvolvedores de games”, afirmou Ming-Yu Liu, pesquisador da NVIDIA e coautor do projeto.

O Vid2Vid Cameo foi apresentado recentemente na famosa Conference on Computer Vision and Pattern Recognition como um dos 28 trabalhos da NVIDIA no evento virtual. Ele também está disponível no Playground AI, um ambiente em que todos podem conferir demonstrações de nossas pesquisas em primeira mão.

A AI Rouba a Cena

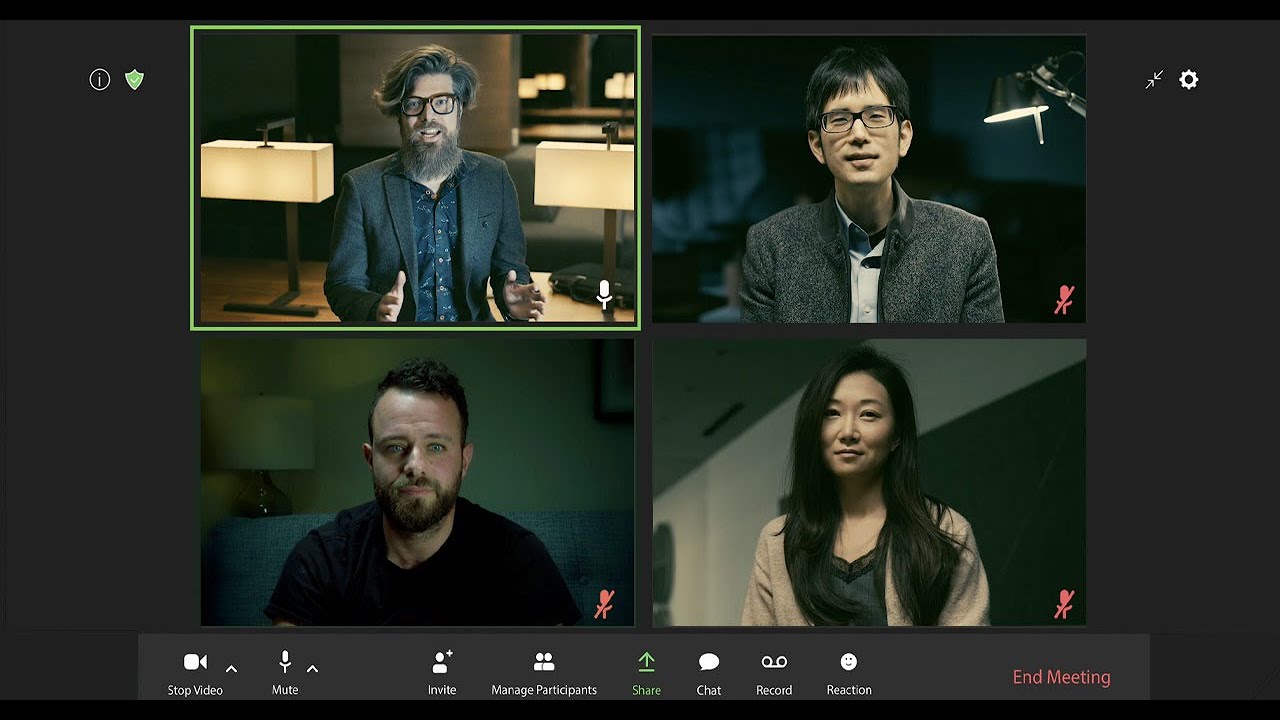

Em uma homenagem aos filmes clássicos de assalto (e a uma série de sucesso da Netflix), os pesquisadores da NVIDIA testaram o modelo representativo com GANs em uma reunião virtual. A demonstração destaca os principais recursos do Vid2Vid Cameo, como redirecionamento facial, avatares animados e compactação de dados.

Em breve, os recursos serão disponibilizados no SDK NVIDIA Maxine, que oferece aos desenvolvedores modelos pré-treinados otimizados para efeitos de vídeo, áudio e realidade aumentada em videochamadas e livestreams.

Os desenvolvedores já podem adotar os efeitos de AI do Maxine, como remoção inteligente de ruído, redimensionamento de vídeo e estimativa de pose corporal. O SDK gratuito também pode ser usado com a plataforma NVIDIA Jarvis para aplicações de AI de conversação, como transcrição e tradução.

Olá da AI

O Vid2Vid Cameo precisa de apenas dois elementos para criar uma representação realista com AI para videochamadas: uma foto da pessoa e um stream de vídeo que define como a imagem deve ser animada.

Desenvolvido em sistemas NVIDIA DGX, o modelo foi treinado usando um conjunto de dados de 180 mil vídeos de alta qualidade de representações. A rede aprendeu a identificar 20 pontos principais que podem ser usados para modelar o movimento facial sem intervenção humana. Os pontos codificam a localização de características como olhos, boca e nariz.

Depois, o modelo extrai os pontos principais da imagem de referência da pessoa que está ligando, que pode ser enviada para outros participantes da videochamada com antecedência ou reutilizada de reuniões anteriores. Assim, em vez de enviar streams pesados de vídeo de um participante para o outro em tempo real, as plataformas de videochamadas podem enviar apenas dados do movimento dos principais pontos faciais da pessoa que está ligando.

No lado da pessoa que está recebendo a chamada, o modelo com GANs usa as informações para sintetizar um vídeo que imita a aparência da imagem de referência.

Ao compactar e enviar pela rede apenas a posição e os pontos principais da cabeça em vez de streams completos de vídeo, a técnica reduz em 10 vezes a largura de banda necessária para videoconferências, proporcionando ao usuário uma experiência mais fluida. É possível ajustar o modelo para que ele transmita um número maior ou menor de pontos principais e se adapte a diferentes níveis de largura de banda sem afetar a qualidade visual.

O ponto de vista do vídeo gerado com a representação também pode ser ajustado à vontade para mostrar o perfil ou o ângulo frontal do usuário, além de pontos mais baixos ou mais altos da câmera. O recurso também pode ser aplicado por editores de fotos que trabalham com imagens estáticas.

Os pesquisadores da NVIDIA descobriram que o Vid2Vid Cameo supera os modelos de última geração, produzindo resultados mais realistas e mais nítidos. Isso vale tanto para a imagem de referência e o vídeo da mesma pessoa quanto para a transferência do movimento de uma pessoa para a imagem de referência de outra com o auxílio da AI.

É possível usar esse último recurso para aplicar os movimentos faciais da pessoa que está falando e animar um avatar digital em uma videochamada ou até mesmo conferir expressões e movimentos realistas a um personagem de videogame ou desenho animado.

O artigo sobre o Vid2Vid Cameo foi escrito pelos pesquisadores Ting-Chun Wang, Arun Mallya e Ming-Yu Liu da NVIDIA. A equipe da Área de Pesquisa na NVIDIA é formada por mais de 200 cientistas de todo o mundo especializados em áreas como AI, visão computacional, automóveis autônomos, robótica e gráficos.

Gostaríamos de agradecer a Edan Moses, que fez a dublagem do Professor na versão em inglês de “La Casa De Papel”, da Netflix, por sua contribuição para o vídeo acima de nossa pesquisa mais atual em AI.