Os chatbots são usados por milhões de pessoas em todo o mundo todos os dias, alimentados por servidores em nuvem impulsionados em GPU NVIDIA. Agora, essas ferramentas inovadoras estão chegando aos PCs com Windows equipados com NVIDIA RTX para IA generativa local, rápida e personalizada.

Chat com RTX, já está disponível e gratuito para download, é uma demonstração técnica que permite aos usuários personalizar um chatbot com seu próprio conteúdo, acelerado por uma GPU local NVIDIA GeForce RTX Série 30 ou superior com pelo menos 8 GB de memória de acesso aleatório de vídeo, ou VRAM.

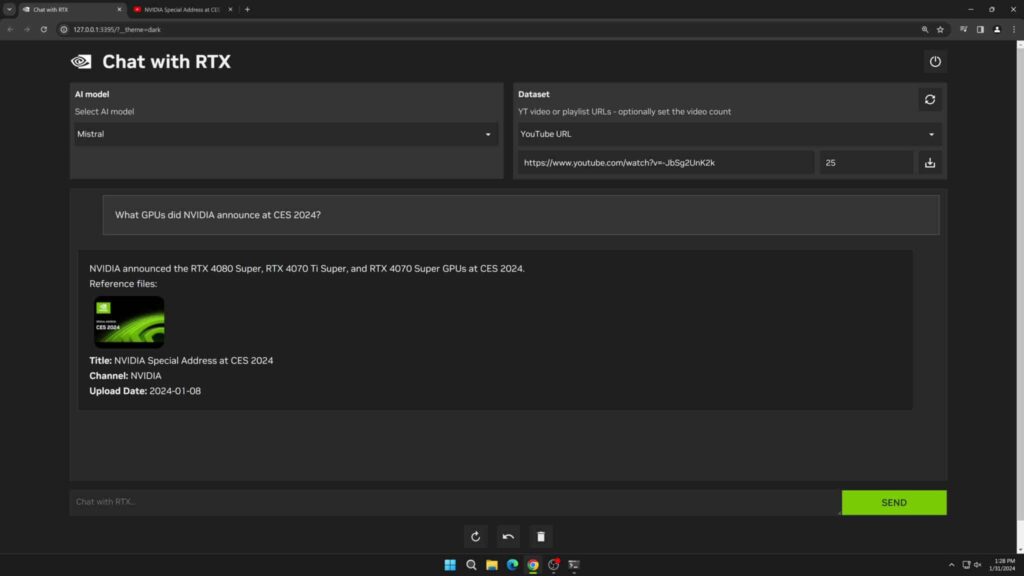

Pode me perguntar qualquer coisa

O Chat com RTX usa Geração Aumentada de Recuperação (Retrieval-Augmented Generation RAG), software NVIDIA TensorRT-LLM e aceleração NVIDIA RTX para trazer recursos de IA generativa para PCs Windows locais com tecnologia GeForce. Os usuários podem conectar de forma rápida e fácil arquivos locais em um PC como um conjunto de dados a um grande modelo de linguagem de código aberto, como Mistral ou Llama 2, permitindo consultas para respostas rápidas e contextualmente relevantes.

Em vez de pesquisar notas ou conteúdo salvo, os usuários podem simplesmente digitar consultas. Por exemplo, alguém poderia perguntar: “Qual foi o restaurante que meu parceiro recomendou enquanto estava em Las Vegas?” e o Chat with RTX verificará os arquivos locais para os quais o usuário aponta e fornecerá a resposta com contexto.

A ferramenta oferece suporte a vários formatos de arquivo, incluindo .txt, .pdf, .doc/.docx e .xml. Aponte o aplicativo para a pasta que contém esses arquivos e a ferramenta os carregará em sua biblioteca em apenas alguns segundos.

Os usuários também podem incluir informações de vídeos e playlists do YouTube. Adicionar um URL de vídeo ao Chat com RTX permite que os usuários integrem esse conhecimento ao seu chatbot para consultas contextuais. Por exemplo, peça recomendações de viagens com base no conteúdo dos vídeos de influenciadores favoritos ou obtenha tutoriais rápidos e instruções com base nos principais recursos educacionais.

Como o Chat with RTX é executado localmente em PCs e workstations Windows RTX, os resultados fornecidos são rápidos — e os dados do usuário permanecem no dispositivo. Em vez de depender de serviços LLM baseados em nuvem, o Chat with RTX permite que os usuários processem dados confidenciais em um PC local sem a necessidade de compartilhá-los com terceiros ou de ter uma conexão com a Internet.

Além de uma GPU GeForce RTX Série 30 ou superior com no mínimo 8 GB de VRAM, o Chat com RTX requer Windows 10 ou 11 e os drivers de GPU NVIDIA mais recentes.

Nota do editor: Identificamos um problema no Chat com RTX que causa falha na instalação quando o usuário seleciona um diretório de instalação diferente. Isso será corrigido em uma versão futura. Por enquanto, os usuários devem usar o diretório de instalação padrão (“C:\Users\<username>\AppData\Local\NVIDIA\ChatWithRTX”).

Desenvolva aplicações baseadas em LLM com RTX

O Chat com RTX mostra o potencial de aceleração de LLMs com GPUs RTX. A aplicação é construída a partir do projeto de referência do desenvolvedor TensorRT-LLM RAG, disponível no GitHub. Os desenvolvedores podem usar o projeto de referência para desenvolver e implantar seus próprios aplicativos baseados em RAG para RTX, acelerados pelo TensorRT-LLM. Saiba mais sobre como criar aplicações baseadas em LLM .

Saiba mais sobre o Chat com RTX .

Explore sessões e experiências de IA Generativa na NVIDIA GTC, a conferência global sobre IA e computação acelerada, que acontecerá de 18 a 21 de março em San Jose, Califórnia online.