Ming-Yu Liu e Arun Mallya estavam em uma videochamada quando a imagem de um deles começou a travar e depois congelou.

É uma situação desagradável na vida durante a pandemia pela qual muitos já passaram. Porém, ao contrário de nós, Liu e Mallya puderam resolver o problema.

Eles são pesquisadores de AI da NVIDIA e especialistas em visão computacional. Com a ajuda do colega Ting-Chun Wang, eles notaram que era possível usar uma rede neural no lugar do codec de vídeo geralmente usado para compactar e descompactar vídeos para transmissão pela rede.

Com o trabalho desenvolvido por eles, é possível realizar uma videochamada com 1/10 da largura de banda da rede geralmente necessária. A novidade promete reduzir consideravelmente o consumo da largura de banda.

“Queremos oferecer uma experiência melhor em videochamadas com a AI para que até pessoas com acesso a uma largura de banda extremamente baixa possam fazer videochamadas, em vez de chamadas de voz”, afirmou Mallya.

Conexões Melhores Graças a GANs

A técnica funciona até quando os participantes da chamada estão usando chapéu, óculos, fones de ouvido ou máscara. Além disso, só por diversão, eles adicionaram alguns recursos às demonstrações, e os usuários podem mudar o cabelo e as roupas digitalmente ou criar um avatar.

Um recurso mais sério que está em desenvolvimento usa a rede neural para ajustar a posição da cabeça da pessoa que está ligando para que ela tenha um contato visual melhor. O recurso acaba com aquele famoso problema que passa a impressão de que a pessoa não está olhando para a tela ou de que ela está olhando para a câmera acoplada ao monitor, e não diretamente para você.

“Com técnicas de visão computacional, podemos localizar a cabeça de uma pessoa em diversos ângulos e acreditamos que isso ajudará as pessoas a ter um contato visual melhor”, afirmou Wang.

Diga olá para a forma mais recente de a AI tornar a vida virtual mais real.

Como Funcionam as Videochamadas Assistidas por AI

O mecanismo por trás das videochamadas assistidas por AI é simples.

Primeiro, o remetente transmite uma imagem de referência da pessoa que está ligando, como os sistemas atuais que geralmente usam uma transmissão de vídeo compactada. Depois, em vez de enviar uma transmissão pesada de imagens com muitos pixels, ele envia dados do local de alguns pontos principais ao redor dos olhos, do nariz e da boca do usuário.

Uma rede adversária generativa no local do destinatário usa a imagem inicial e os principais pontos do rosto para recriar as imagens seguintes em uma GPU local. Assim, o volume de dados enviados pela rede é muito menor.

A pesquisa de Liu com GANs ganhou destaque no ano passado com a GauGAN, uma ferramenta de AI que transforma os desenhos das pessoas em obras de arte fotorrealistas. A ferramenta GauGAN já foi usada para criar mais de um milhão de imagens e está disponível na página de Projetos de AI.

“A pandemia nos motivou, porque agora todo mundo está participando de videoconferências, então estudamos como reduzir os problemas de largura de banda para que as operadoras possam atender mais pessoas ao mesmo tempo”, afirmou Liu.

GPUs Solucionam Problemas de Largura de Banda

A abordagem faz parte de uma tendência no setor de substituir os gargalos da rede por tarefas computacionais que podem ser realizadas mais facilmente com recursos locais ou do cloud.

“Atualmente, muitas empresas querem transformar os problemas de largura de banda em problemas de computação, porque geralmente é difícil aumentar a largura de banda e é mais fácil aumentar a capacidade de computação”, afirmou Andrew Page, Diretor de Produtos Avançados do Grupo de Mídia da NVIDIA.

Instrumentos de AI Melhoram Serviços de Vídeo

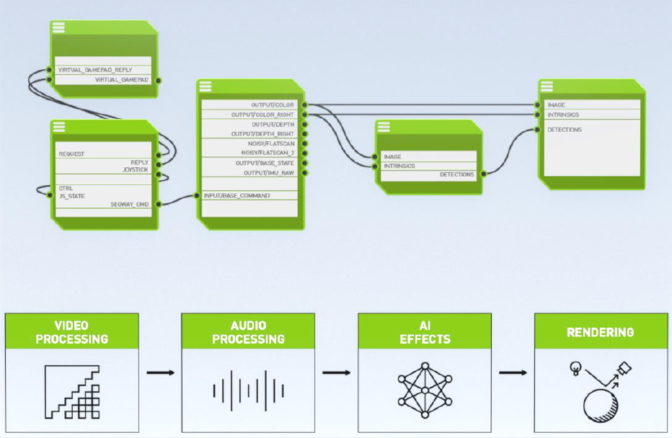

A compressão de vídeo GAN é um dos vários recursos que chegam ao NVIDIA Maxine, uma plataforma de streaming de vídeo com AI em cloud para aprimorar a videoconferência e as chamadas. Ele contém recursos de AI de áudio, vídeo e conversação em um único kit de ferramentas que oferece suporte a uma ampla gama de dispositivos.

Anunciada no GTC de Outubro, a Maxine permite que os provedores de serviço forneçam vídeo em super resolução com tradução em tempo real, remoção de ruído de fundo e legenda baseada no contexto. Os usuários podem desfrutar de recursos como alinhamento de rosto, suporte para assistentes virtuais e animação realista de avatares.

“As videoconferências estão passando por uma revolução”, afirmou Page. “Durante a pandemia, todos nós vimos os problemas relacionados a essa tecnologia, mas o vídeo veio para ficar e agora faz parte de nossa vida, porque somos seres visuais.”

A Maxine aproveita o poder das GPUs NVIDIA com o Tensor Cores executando software como o NVIDIA Jarvis, um SDK para AI de conversação que oferece um conjunto de recursos de voz e texto. Juntos, eles oferecem recursos de AI que são úteis hoje e servem como base para os produtos e serviços de vídeo de amanhã.

Saiba mais sobre a Pesquisa na NVIDIA. E assista ao CEO da NVIDIA, Jensen Huang, falando sobre todas as novidades do GTC no vídeo abaixo.

Você pode ativar as legendas em Português. Vá em Setting” > “Configuration” > Auto-translate”