A primeira instância de GPU da Amazon Web Services foi lançada 10 anos atrás, com a NVIDIA M2050. Na época, as aplicações baseadas em CUDA eram focadas principalmente na aceleração de simulações científicas, pois o crescimento da AI e do deep learning ainda estava longe.

Desde então, a AWS ampliou o conjunto de instâncias de GPU em cloud, que conta com a K80 (p2), a K520 (g3), a M60 (g4), a V100 (p3/p3dn) e a T4 (g4).

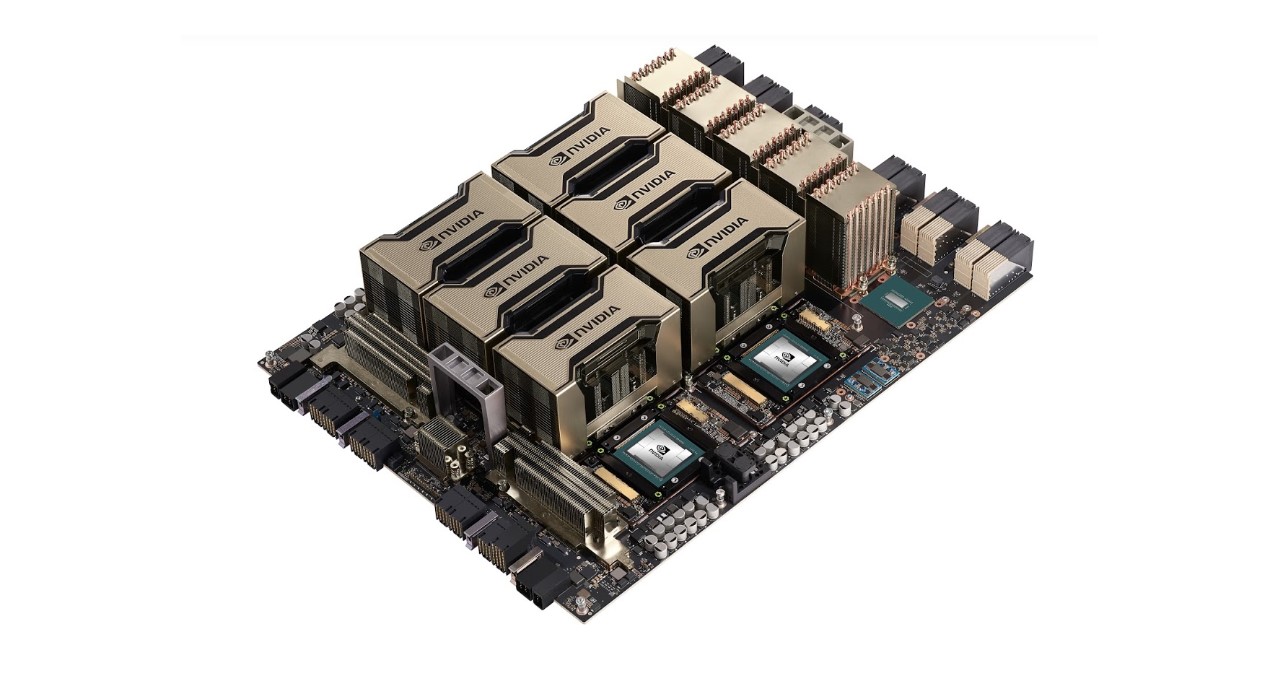

Com o lançamento da nova instância P4d, a AWS está contribuindo para mais uma década promissora de computação acelerada com a GPU NVIDIA A100 Tensor Core mais atual.

A instância P4d oferece o desempenho mais alto da AWS, a plataforma mais econômica baseada em GPU para o treinamento de softwares de machine learning e computação de alto desempenho. As instâncias reduzem o tempo de treinamento de modelos de machine learning em até 3 vezes com FP16 e em até 6 vezes com TF32 em comparação com a precisão FP32 padrão.

Elas também realizam inferências com um desempenho excepcional. Em outubro, as GPUs NVIDIA A100 se destacaram nos benchmarks de inferência do MLPerf, oferecendo um desempenho até 237 vezes mais rápido do que as CPUs.

Cada instância P4d conta com oito GPUs NVIDIA A100 e, com os UltraClusters da AWS, os clientes podem ter acesso flexível e sob demanda a mais de 4 mil GPUs ao mesmo tempo com o Elastic Fabric Adaptor (EFA) da AWS e a um armazenamento adaptável e de alto desempenho com o Amazon FSx. A P4d oferece uma rede de 400 Gbps e usa as tecnologias da NVIDIA, como o NVLink, o NVSwitch, o NCCL e o GPUDirect RDMA, para acelerar ainda mais as cargas de trabalho de treinamento de deep learning. O NVIDIA GPUDirect RDMA no EFA garante uma rede de baixa latência, transferindo dados de GPU para GPU entre servidores sem que eles precisem passar pela CPU e pela memória do sistema.

Cada instância P4d conta com oito GPUs NVIDIA A100 e, com os UltraClusters da AWS, os clientes podem ter acesso flexível e sob demanda a mais de 4 mil GPUs ao mesmo tempo com o Elastic Fabric Adaptor (EFA) da AWS e a um armazenamento adaptável e de alto desempenho com o Amazon FSx. A P4d oferece uma rede de 400 Gbps e usa as tecnologias da NVIDIA, como o NVLink, o NVSwitch, o NCCL e o GPUDirect RDMA, para acelerar ainda mais as cargas de trabalho de treinamento de deep learning. O NVIDIA GPUDirect RDMA no EFA garante uma rede de baixa latência, transferindo dados de GPU para GPU entre servidores sem que eles precisem passar pela CPU e pela memória do sistema.

Além disso, a instância P4d é compatível com vários serviços da AWS, como o Amazon Elastic Container Services, o Amazon Elastic Kubernetes Service, o AWS ParallelCluster e o Amazon SageMaker. Ela também consegue usar todos os softwares otimizados e conteinerizados disponíveis no NGC, como softwares de HPC, frameworks de AI, modelos pré-treinados, pacotes Helm e softwares de inferência, como o TensorRT e o Servidor de Inferência Triton.

As instâncias P4d já estão disponíveis no leste e no oeste dos Estados Unidos, e serão disponibilizadas para outras regiões em breve. As instâncias podem ser compradas sob demanda, com savings plans, com instâncias reservadas ou como instâncias spot.

A primeira década da computação em cloud de GPU proporcionou mais de 100 exaflops de computação de AI para o mercado. Com a chegada da instância P4d do Amazon EC2 com GPUs NVIDIA A100, a próxima década da computação em cloud de GPU começará com o pé direito.

A NVIDIA e a AWS estão garantindo que os softwares continuem testando os limites da AI em várias aplicações. Queremos logo ver o que os clientes farão com eles.

Acesse a AWS e comece a usar as instâncias P4d hoje mesmo.