Os bancos usam AI para saber se podem oferecer crédito aos clientes e o valor concedido. Os departamentos de radiologia implantam AI para facilitar a distinção entre tecidos saudáveis e tumores. Já as equipes de RH usam a tecnologia para identificar quais das centenas de currículos devem ser enviados aos recrutadores.

Esses são só alguns exemplos de como a AI está sendo adotada em todos os setores. Com tantos riscos, as empresas e os governos que adotaram a AI e o machine learning estão sob uma pressão cada vez maior para mostrar transparência na forma como os modelos de AI tomam decisões.

Charles Elkan, diretor administrativo da Goldman Sachs, faz uma ótima analogia de grande parte do estado atual da AI, em que as organizações analisam o quão confiável ela é e como refutar as objeções aos sistemas de AI:

Não entendemos exatamente como cães farejadores de bombas fazem o trabalho deles, mas confiamos muito nas decisões que eles tomam.

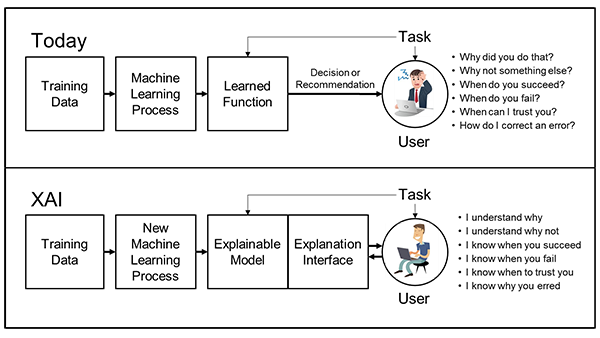

Para entender melhor como os modelos de AI tomam decisões, as organizações estão recorrendo à inteligência artificial explicável.

O Que É AI Explicável?

A AI explicável (XAI – Explainable AI) é um conjunto de ferramentas e técnicas usadas pelas organizações para ajudar as pessoas a entender melhor por que um modelo toma certas decisões e como ele funciona. A XAI é:

- Um conjunto de práticas recomendadas: ela segue alguns dos melhores procedimentos e regras que os cientistas de dados usam há anos para ajudar outras pessoas a entender como um modelo é treinado. Saber como e com quais dados um modelo foi treinado nos ajuda a entender quando faz e não faz sentido usá-lo, além de identificar as fontes de parcialidade às quais o modelo pode ter sido exposto.

- Um conjunto de princípios de design: os pesquisadores estão cada vez mais focados em simplificar a criação de sistemas de AI para que seja mais fácil entendê-los desde o princípio.

- Um conjunto de ferramentas: os sistemas estão ficando mais fáceis de entender, e é possível refinar ainda mais os modelos de treinamento incorporando aprendizados neles e oferecendo-os a outras pessoas para que elas os incorporem nos modelos delas.

Como Funciona a AI Explicável?

Embora ainda haja bastante discussão sobre a padronização dos processos de XAI, alguns pontos principais são comuns entre os setores que a implementam:

- Para quem temos que explicar o modelo?

- Quão detalhada precisa ser a explicação?

- Precisamos explicar o modelo geral ou uma decisão específica?

Os cientistas de dados estão focados em todas essas questões, mas o principal é: o que estamos tentando explicar?

Vamos à explicação da origem do modelo:

- Como o modelo foi treinado?

- Que dados foram usados?

- Como o impacto da parcialidade nos dados de treinamento foi mensurado e mitigado?

Na ciência de dados, fazer essas perguntas seria o mesmo que perguntar em que universidade um cirurgião estudou, quem foram seus professores, o que ele estudou e quais notas ele teve. Para saber essas informações com precisão, é mais importante observar o processo e os documentos do que a AI em si, mas ainda são fundamentais para estabelecer a confiança em um modelo.

Embora seja relativamente fácil explicar a origem de um modelo, na prática é difícil, já que atualmente muitas ferramentas não permitem uma coleta eficiente de informações. A NVIDIA disponibiliza essas informações sobre seus modelos pré-treinados. Essas ferramentas você encontra no catálogo do NGC, um hub de SDKs e modelos de AI e computação de alto desempenho otimizados por GPU que ajudam as empresas a criar aplicações rapidamente.

Vamos à explicação do modelo geral:

Às vezes chamada de interpretabilidade do modelo, essa área de pesquisa segue ativa. A maioria das explicações do modelo se encaixa em uma das duas categorias:

Em uma técnica às vezes chamada de “modelagem proxy“, os modelos mais simples e de fácil compreensão, como árvores de decisão, podem ser usados para descrever o modelo de AI mais detalhado. Essas explicações dão uma “noção” geral do modelo, mas os prós e os contras da aproximação e da simplicidade do modelo proxy ainda são mais subjetivos do que objetivos.

A modelagem proxy é sempre uma aproximação e, por mais que seja bem aplicada, pode criar oportunidades para que as decisões reais sejam muito diferentes do esperado dos modelos proxy.

A segunda abordagem é o “design para interpretabilidade“. Ela limita as opções de design e treinamento da rede de AI para tentar criar a rede geral a partir de partes menores que têm um comportamento mais simples forçado. Esse design pode gerar modelos avançados, mas com um comportamento que é muito mais fácil de explicar.

Porém, isso não é tão fácil quanto parece, e a remoção de componentes e estruturas da caixa de ferramentas do cientista de dados faz com o que o nível de eficiência e precisão diminua. Essa abordagem também pode exigir uma potência computacional muito maior.

Por que a XAI Explica Melhor as Decisões Individuais

A área que mais entendemos da XAI é a tomada de decisões individuais: o motivo pelo qual uma pessoa não recebeu aprovação para um empréstimo, por exemplo.

Técnicas como a LIME e a SHAP oferecem respostas matemáticas muito literais para essa questão, e os resultados dessa matemática podem ser apresentados a cientistas de dados, gerentes, reguladores e consumidores. Para alguns dados, como imagens, áudios e textos, resultados semelhantes podem ser visualizados com o uso da “atenção” nos modelos, forçando o próprio modelo a mostrar seu processo.

No caso dos valores de Shapley usados na SHAP, há algumas provas matemáticas das técnicas subjacentes que são interessantes principalmente considerando a pesquisa sobre a teoria dos jogos da década de 1950. Atualmente, há pesquisas sobre o uso dessas explicações de decisões individuais que visam explicar o modelo como um todo, focando especialmente no agrupamento e forçando várias restrições de fluidez na matemática subjacente.

A desvantagem dessas técnicas é que, do ponto de vista computacional, elas são complexas. Além disso, se não há muito esforço durante o treinamento do modelo, os resultados podem depender muito dos valores dos dados inseridos. Algumas pessoas também argumentam que, como os cientistas de dados só podem calcular valores aproximados de Shapley, as características interessantes e corroboráveis desses números também são apenas aproximadas, reduzindo consideravelmente seu valor.

Embora ainda seja válido manter o debate vivo, é evidente que, com o uso do tipo de modelo adequado, a adoção de um método de explicabilidade de modelo que mostre à liderança sênior os riscos do modelo e a monitoração dos resultados reais com explicações individuais, é possível criar modelos de AI com um comportamento fácil de entender.

Para obter mais detalhes dos exemplos de trabalhos de XAI, confira as palestras apresentadas pela Wells Fargo e pelo ScotiaBank no NVIDIA GTC21.