A criação de objetos 3D para o desenvolvimento de cenas para games, mundos virtuais incluindo o metaverso, design de produto ou efeitos visuais, é tradicionalmente um processo meticuloso em que profissionais qualificados equilibram detalhes e fotorrealismo em relação a prazos e pressões orçamentárias.

Leva muito tempo para fazer algo que pareça e funcione como no mundo físico. E o problema fica mais difícil quando vários objetos e personagens precisam interagir em um mundo virtual. Simular a física torna-se tão importante quanto simular a luz. Um robô em uma fábrica virtual, por exemplo, precisa ter não só a mesma aparência, mas também a mesma capacidade de peso e o mesmo recurso de frenagem que sua contraparte física.

É difícil. Porém, as oportunidades são enormes, afetando setores de trilhões de dólares tão variados quanto transporte, área da saúde, telecomunicações e entretenimento, além do design de produtos. No fim das contas, mais conteúdo será criado no mundo virtual do que no físico.

Para simplificar e encurtar esse processo, a NVIDIA lançou hoje novas pesquisas e um amplo pacote de ferramentas que aplicam o poder dos gráficos neurais à criação e à animação de objetos e mundos 3D.

Esses SDKs, incluindo o NeuralVDB, uma atualização inovadora para o OpenVDB padrão do setor, e o Kaolin Wisp, uma biblioteca Pytorch que estabelece um framework para pesquisa de campos neurais, facilitam o processo criativo para designers, possibilitando que milhões de usuários que não são profissionais de design criem conteúdo 3D.

Os gráficos neurais são um novo campo que entrelaça AI e gráficos para criar um pipeline gráfico acelerado que aprende com os dados. A integração da AI melhora os resultados, ajuda a automatizar as escolhas de design e oferece oportunidades novas, embora ainda não imaginadas, para artistas e criadores. Os gráficos neurais redefinirão como os mundos virtuais são criados, simulados e vivenciados pelos usuários.

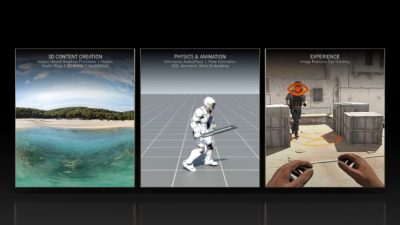

Esses SDKs e pesquisas contribuem para cada estágio do pipeline de criação de conteúdo, incluindo:

Criação de Conteúdo 3D

- Kaolin Wisp: uma adição ao Kaolin, uma biblioteca PyTorch que possibilita pesquisas mais rápidas em deep learning 3D, reduzindo de semanas para dias o tempo necessário para testar e implementar novas técnicas. O Kaolin Wisp é uma biblioteca orientada à pesquisa para campos neurais, estabelecendo um pacote comum de ferramentas e um framework para acelerar novas pesquisas em campos neurais.

- Primitivos de Gráficos Neurais Instantâneos: uma nova abordagem para capturar o formato dos objetos do mundo real e a inspiração por trás do NVIDIA Instant NeRF, um modelo de renderização inverso que transforma uma coleção de imagens estáticas em uma cena 3D digital. Essa técnica e o código GitHub associado aceleram o processo em até 1.000 vezes.

- MoMa 3D: um novo pipeline de renderização inversa que permite aos usuários importar rapidamente um objeto 2D para um engine gráfico para criar um objeto 3D que possa ser modificado com materiais, iluminação e física realistas.

- GauGAN360: a próxima evolução do NVIDIA GauGAN, um modelo de AI que transforma esboços em obras-primas fotorrealistas. O GauGAN360 gera panoramas de 360 graus em 8K que podem ser transferidos para cenas do Omniverse.

- Omniverse Avatar Cloud Engine (ACE): uma nova coleção de APIs no cloud, microsserviços e ferramentas para criar, personalizar e implementar aplicações humanas digitais. O ACE foi desenvolvido no Unified Compute Framework da NVIDIA, permitindo aos desenvolvedores integrar perfeitamente as principais tecnologias de AI da NVIDIA em suas aplicações de avatar.

Física e Animação

- NeuralVDB: uma melhoria inovadora no OpenVDB, o padrão atual do setor para armazenamento volumétrico de dados. Usando machine learning, o NeuralVDB introduz representações neurais compactas, reduzindo significativamente o espaço da memória para permitir dados 3D de resolução mais alta.

- Omniverse Audio2Face: uma tecnologia de AI que gera animações faciais expressivas a partir de uma única fonte de áudio. Ela é útil para aplicações interativas em tempo real ou como uma ferramenta tradicional de criação de animações faciais.

- Incorporação de Habilidades de Animação (ASE – Animation Skills Embedding): uma abordagem que permite que personagens simulados fisicamente atuem de uma maneira mais responsiva e realista em situações desconhecidas. Ela usa deep learning para ensinar os personagens como responder a novas tarefas e ações.

- Kit de Ferramentas TAO: um framework para permitir que os usuários criem um modelo preciso de estimativa de pose de alto desempenho, que pode avaliar o que uma pessoa pode estar fazendo em uma cena usando a visão computacional muito mais rapidamente do que os métodos atuais.

Experiência

- Rastreamento Ocular de Recursos de Imagem: um modelo de pesquisa que liga a qualidade da renderização de pixels ao tempo de reação de um usuário. Ao prever a melhor combinação de qualidade de renderização, propriedades de exibição e condições de visualização para a menor latência, ele permitirá melhor desempenho em aplicações de computação gráfica interativas e de ritmo rápido, como games competitivos.

- Óculos Holográficos para Realidade Virtual: uma colaboração com a Universidade de Stanford em um novo design de óculos VR que oferece imagens holográficas 3D coloridas em um revolucionário conjunto óptico de 2,5mm de espessura.

Confira a NVIDIA na SIGGRAPH para ver mais dos últimos avanços em pesquisa e tecnologia em gráficos, AI e mundos virtuais. Confira as inovações mais recentes da Pesquisa na NVIDIA e acesse o pacote completo de SDKs, ferramentas e bibliotecas da NVIDIA.