De assistentes de IA fazendo pesquisas profundas a veículos autônomos tomando decisões de navegação em frações de segundo, a adoção da IA está explodindo em todos os setores.

Por trás de cada uma dessas interações está a inferência, o estágio após o treinamento em que um modelo de IA processa entradas e produz saídas em tempo real.

Os modelos de raciocínio de IA mais avançados de hoje, capazes de lógica de várias etapas e tomada de decisão complexa, geram muito mais tokens por interação do que os modelos mais antigos, gerando um aumento no uso de tokens e a necessidade de infraestrutura que possa fabricar inteligência em escala.

As fábricas de IA são uma forma de atender a essas necessidades crescentes.

Mas executar inferência em uma escala tão grande não é apenas jogar mais computação no problema.

Para implantar a IA com a máxima eficiência, a inferência deve ser avaliada com base na estrutura Think SMART:

- Escala e eficiência

- Desempenho multidimensional

- Arquitetura e codesign

- Retorno sobre o investimento impulsionado pelo desempenho

- Ecossistema de tecnologia e base instalada

Escala e Complexidade

À medida que os modelos evoluem de aplicativos compactos para sistemas massivos e multiespecialistas, a inferência deve acompanhar cargas de trabalho cada vez mais diversificadas, desde responder a consultas rápidas e únicas até raciocínios em várias etapas envolvendo milhões de tokens.

A expansão do tamanho e da complexidade dos modelos de IA introduz grandes implicações para a inferência, como intensidade de recursos, latência e taxa de transferência, energia e custos, bem como diversidade de casos de uso.

Para atender a essa complexidade, os provedores de serviços de IA e as empresas estão ampliando sua infraestrutura, com novas fábricas de IA entrando em operação de parceiros como CoreWeave, Dell Technologies, Google Cloud e Nebius.

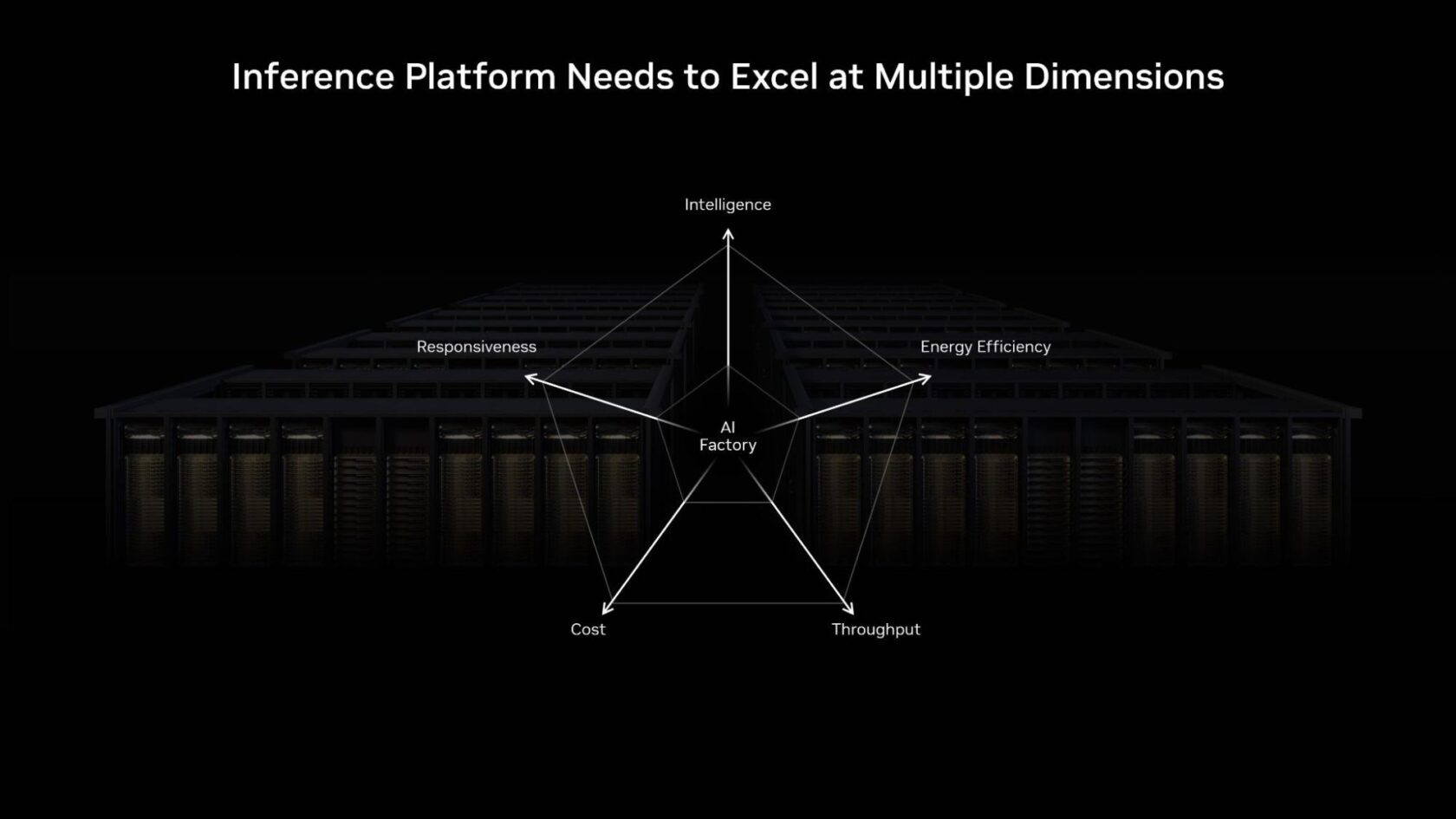

Desempenho Multidimensional

Dimensionar implantações complexas de IA significa que as fábricas de IA precisam de flexibilidade para atender tokens em um amplo espectro de casos de uso, equilibrando precisão, latência e custos.

Algumas cargas de trabalho, como tradução de fala para texto em tempo real, exigem latência ultrabaixa e um grande número de tokens por usuário, sobrecarregando os recursos computacionais para máxima capacidade de resposta. Outros são insensíveis à latência e voltados para a taxa de transferência pura, como gerar respostas para dezenas de perguntas complexas simultaneamente.

Mas os cenários em tempo real mais populares operam em algum lugar no meio: exigindo respostas rápidas para manter os usuários satisfeitos e alta taxa de transferência para atender simultaneamente a milhões de usuários – tudo isso minimizando o custo por token.

Por exemplo, a Plataforma de inferência NVIDIA é construída para equilibrar a latência e a taxa de transferência, alimentando benchmarks de inferência em modelos como gpt-oss,Busca Profunda-R1 e Lhama 3.1.

O que Avaliar para Alcançar o Desempenho Multidimensional Ideal

- Inteligência: Avalie como o tamanho e a complexidade do modelo impactam o desempenho e o custo. Modelos maiores podem oferecer uma inteligência mais avançada, mas exigem muito mais recursos computacionais, afetando a eficiência geral.

- Resposta: Equilibre a experiência do usuário com a escalabilidade do sistema. Alocar mais recursos de computação por consulta melhora a resposta, enquanto compartilhar recursos entre usuários maximiza a taxa de processamento total e a receita.

- Eficiência energética: Meça o desempenho em tokens por segundo por watt para entender de fato a produtividade dentro dos limites de energia. Maior eficiência energética se traduz diretamente em melhores resultados econômicos e sustentabilidade em larga escala.

- Custo: Avalie o desempenho por dólar investido para garantir uma implantação de IA escalável e econômica. A sustentabilidade financeira vem do equilíbrio entre resposta em baixa latência e alta eficiência de processamento em diferentes tipos de inferência.

- Vazão: Monitore quantos tokens seu sistema processa por segundo e como ele se adapta de forma flexível à demanda. Otimizar a vazão de tokens é essencial para escalar operações e maximizar resultados.

Arquitetura e Codesign de Software

O desempenho da inferência de IA precisa ser projetado desde o início. Ele vem de hardware e software trabalhando em sincronia: GPUs, rede e código ajustados para evitar gargalos e aproveitar cada ciclo ao máximo.

Arquitetura poderosa sem orquestração inteligente desperdiça potencial; Um ótimo software sem hardware rápido e de baixa latência significa desempenho lento. A chave é arquitetar um sistema para que ele possa transformar prompts em respostas úteis de forma rápida, eficiente e flexível.

As empresas podem usar a infraestrutura NVIDIA para criar um sistema que ofereça desempenho ideal.

Arquitetura Otimizada para Inferência em Escala de Fábrica de IA

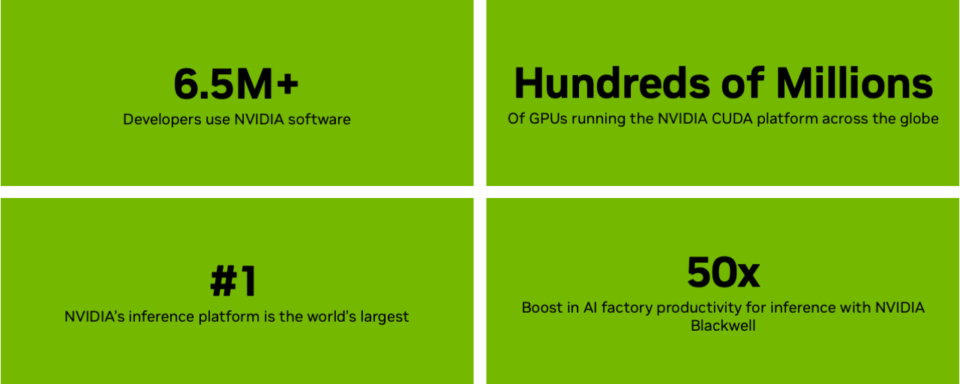

A plataforma NVIDIA Blackwell desbloqueia um aumento de 50 vezes na produtividade da fábrica de IA para inferência, o que significa que as empresas podem otimizar a taxa de transferência e a capacidade de resposta interativa, mesmo ao executar os modelos mais complexos.

O sistema em escala de rack NVIDIA GB200 NVL72 conecta 36 CPUs NVIDIA Grace e 72 GPUs Blackwell com interconexão NVIDIA NVLink, oferecendo potencial de receita 40x maior, taxa de transferência 30 vezes maior, 25 vezes mais eficiência energética e 300 vezes mais eficiência hídrica para cargas de trabalho exigentes de raciocínio de IA.

Além disso, o NVFP4 é um formato de baixa precisão que oferece desempenho máximo no NVIDIA Blackwell e reduz as demandas de energia, memória e largura de banda sem perder o ritmo da precisão, para que os usuários possam fornecer mais consultas por watt e custos mais baixos por token.

Plataforma de Inferência Full-stack Acelerada na Blackwell

Permitir a inferência na escala de fábrica de IA requer mais do que arquitetura acelerada. Requer uma plataforma full-stack com várias camadas de soluções e ferramentas que podem trabalhar em conjunto.

As implantações modernas de IA exigem dimensionamento automático dinâmico de uma a milhares de GPUs. A plataforma NVIDIA Dynamo orienta a inferência distribuída para atribuir GPUs dinamicamente e otimizar fluxos de dados, oferecendo até 4 vezes mais desempenho sem aumentos de custo. Novas integrações de nuvem melhoram ainda mais a escalabilidade e a facilidade de implantação.

Para cargas de trabalho de inferência focadas em obter o desempenho ideal por GPU, como acelerar uma grande mistura de modelos especializados, estruturas como o NVIDIA TensorRT-LLM estão ajudando os desenvolvedores a obter um desempenho inovador.

Com seu novo fluxo de trabalho centrado no PyTorch, o TensorRT-LLM simplifica a implantação de IA, eliminando a necessidade de gerenciamento manual do mecanismo. Essas soluções não são apenas poderosas por si só, elas são criadas para funcionar em conjunto. Por exemplo, usando o Dynamo e o TensorRT-LLM, provedores de inferência de missão crítica, como o Baseten, podem fornecer imediatamente desempenho de modelo de última geração, mesmo em modelos de nova fronteira, como o gpt-oss.

No lado do modelo, famílias como o NVIDIA Nemotron são construídas com dados de treinamento abertos para transparência, enquanto ainda geram tokens com rapidez suficiente para lidar com tarefas avançadas de raciocínio com alta precisão – sem aumentar os custos de computação. E com o NVIDIA NIM, esses modelos podem ser empacotados em microsserviços prontos para serem executados, tornando mais fácil para as equipes implementá-los e escalar em todos os ambientes, ao mesmo tempo em que alcançam o menor custo total de propriedade.

Juntas, essas camadas (orquestração dinâmica, execução otimizada, modelos bem projetados e implantação simplificada) formam a espinha dorsal da habilitação de inferência para provedores de nuvem e empresas.

Retorno sobre o Investimento Impulsionado pelo Desempenho

À medida que a adoção da IA cresce, as organizações procuram cada vez mais maximizar o retorno sobre o investimento de cada consulta do usuário.

O desempenho é o maior impulsionador do retorno do investimento. Um aumento de 4 vezes no desempenho da arquitetura NVIDIA Hopper para a Blackwell gera um crescimento de lucro de até 10 vezes dentro de um orçamento de energia semelhante.

Em data centers com energia limitada e fábricas de IA, gerar mais tokens por watt se traduz diretamente em maior receita por rack. Gerenciar a taxa de transferência do token com eficiência, equilibrando latência, precisão e carga do usuário, é crucial para manter os custos baixos.

A indústria está vendo rápidas melhorias de custos, chegando a reduzir custos por milhão de tokens em 80% por meio de otimizações em toda a pilha. Os mesmos ganhos são alcançáveis em execução gpt-oss e outros modelos de código aberto do ecossistema de inferência da NVIDIA, seja em data centers de hiperescala ou em PCs de IA locais.

Ecossistema de Tecnologia e Base Instalada

À medida que os modelos avançam, apresentando janelas de contexto mais longas, mais tokens e comportamentos de tempo de execução mais sofisticados, seu desempenho de inferência aumenta.

Os modelos abertos são uma força motriz nesse impulso, acelerando mais de 70% das cargas de trabalho de inferência de IA hoje. Eles permitem que startups e empresas criem agentes, copilotos e aplicativos personalizados em todos os setores.

As comunidades de código aberto desempenham um papel crítico no ecossistema de IA generativa, promovendo a colaboração, acelerando a inovação e democratizando o acesso. A NVIDIA tem mais de 1.000 projetos de código aberto no GitHub, além de 450 modelos e mais de 80 conjuntos de dados em Hugging Face. Isso ajuda a integrar estruturas populares como JAX ,PyTorch, vLLM e TensorRT-LLM na plataforma de inferência da NVIDIA, garantindo o máximo desempenho de inferência e flexibilidade entre as configurações.

É por isso que a NVIDIA continua a contribuir para o código aberto Projetos como LLM-D e colabore com líderes do setor em modelos abertos, incluindo Llama, Google Gemma, NVIDIA Nemotron, DeepSeek e gpt-oss, ajudando a levar os aplicativos de IA da ideia à produção em uma velocidade sem precedentes.

O Resultado Final para Inferência Otimizada

A plataforma de inferência da NVIDIA, juntamente com a estrutura Think SMART para implantar cargas de trabalho de IA modernas, ajuda as empresas a garantir que sua infraestrutura possa acompanhar as demandas de modelos em rápido avanço – e que cada token gerado ofereça valor máximo.

Saiba mais sobre como a inferência impulsiona o potencial de geração de receita das fábricas de IA.

Para atualizações mensais, inscreva-se no boletim informativo NVIDIA Think SMART.