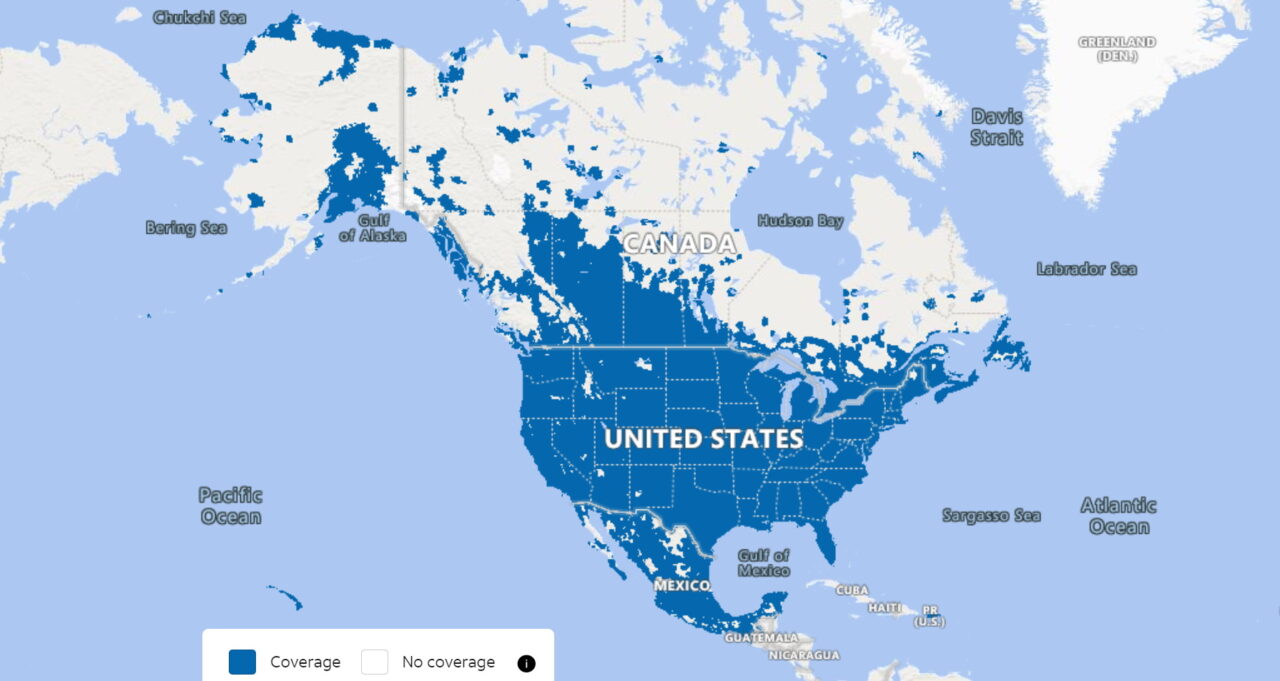

A rede sem fio da AT&T conecta mais de 100 milhões de assinantes das Ilhas Aleutas às Florida Keys, gerando um mar de big data.

Abhay Dabholkar dirige um grupo de pesquisa que atua como um farol à procura das melhores ferramentas para navegar.

“É divertido, podemos brincar com novas ferramentas que podem fazer a diferença no trabalho diário da AT&T e, quando damos aos funcionários as melhores e mais recentes ferramentas, isso aumenta a satisfação no trabalho”, disse Dabholkar, um distinto arquiteto de AI. que está na empresa há mais de uma década.

Recentemente, a equipe testou em servidores com GPU o Acelerador NVIDIA RAPIDS para Apache Spark, software que distribui o trabalho entre nós em um cluster.

Ele processou um mês de dados móveis, 2,8 trilhões de linhas de informações, em apenas cinco horas. Isso é 3,3 vezes mais rápido a um custo 60% menor do que qualquer teste anterior.

Um Momento Uau

“Foi um momento UAU, porque em clusters de CPU leva mais de 48 horas para processar apenas sete dias de dados: no passado, tínhamos os dados, mas não podíamos usá-los porque levava muito tempo para processá-los.” ele disse.

Especificamente, o teste comparou o que é chamado de ETL, o processo de extração, transformação e carregamento que limpa os dados antes que eles possam ser usados para treinar os modelos de AI que revelam novos insights.

“Agora, estamos pensando que as GPUs podem ser usadas para ETL e todos os tipos de cargas de trabalho de processamento em lote que fazemos no Spark, por isso estamos explorando outras bibliotecas RAPIDS para estender o trabalho de engenharia de recursos para ETL e machine learning”, disse ele.

Hoje, a AT&T executa ETL em servidores de CPU e, em seguida, move dados para servidores de GPU para treinamento. Fazer tudo em um pipeline de GPU pode economizar tempo e custo, acrescentou.

Agradar os Clientes, Acelerar o Design da Rede

A economia pode aparecer em uma ampla variedade de casos de uso.

Por exemplo, os usuários podem descobrir mais rapidamente onde obtêm conexões ideais, melhorando a satisfação do cliente e reduzindo a rotatividade. “Podemos decidir os parâmetros para nossas torres e antenas 5G mais rapidamente também”, disse ele.

Identificar qual área na área de fibra da AT&T para lançar um caminhão de suporte pode exigir cálculos geoespaciais demorados, algo que RAPIDS e GPUs podem acelerar, disse Chris Vo, membro sênior da equipe que supervisionou os testes RAPIDS.

“Provavelmente recebemos de 300 a 400 terabytes de dados novos por dia, então essa tecnologia pode ter um impacto incrível: os relatórios que geramos ao longo de duas ou três semanas podem ser feitos em poucas horas”, disse Dabholkar.

Três Casos de Uso e Contagem

Os pesquisadores estão compartilhando seus resultados com membros da equipe da plataforma de dados da AT&T.

“Recomendamos que, se um trabalho estiver demorando muito e você tiver muitos dados, ative as GPUs, com o Spark, o mesmo código que é executado em CPUs é executado em GPUs”, disse ele.

Até agora, equipes separadas encontraram seus próprios ganhos em três casos de uso diferentes; outras equipes também planejam executar testes em suas cargas de trabalho.

Dabholkar está otimista que as unidades de negócios levarão os resultados dos testes aos sistemas de produção.

“Somos uma empresa de telecomunicações com todos os tipos de conjuntos de dados processando petabytes de dados diariamente, e isso pode melhorar significativamente nossas economias”, disse ele.

Outros usuários, incluindo o Internal Revenue Service dos EUA, estão em uma jornada semelhante. É um caminho que muitos seguirão, já que o Apache Spark é usado por mais de 13.000 empresas, incluindo 80% das 500 da Fortune.

Registre-se gratuitamente no GTC para ouvir Chris Vo, da AT&T, falar sobre seu trabalho, aprender mais sobre ciência de dados nessas sessões e ouvir a apresentação de abertura do CEO da NVIDIA, Jensen Huang.