Há muito tempo, as equipes de IT trabalham para otimizar a infraestrutura de hardware e software a fim de lidar com o número cada vez maior de aplicações corporativas. Além de garantir a capacidade de dimensionamento dessas aplicações, as equipes de IT corporativas precisam ter a quantidade certa de recursos necessários para executá-las da melhor forma e assegurar que o tempo de atividade continue alto e consistente.

Agora, uma nova onda de mudanças na área de aplicações fez com que as empresas passassem a se orientar mais por dados com análises avançadas e AI para desenvolver produtos de ponta com desktops virtuais com muitos gráficos.

Os requisitos exclusivos dessas aplicações complexas geralmente eliminam a possibilidade de usar o grupo padrão otimizado de recursos no data center.

Dedicar a infraestrutura a aplicações essenciais para os negócios, sem dúvida, não é algo ruim, principalmente no curto prazo. Porém, com um número maior de aplicações usando um grupo compartilhado de recursos, é possível aumentar a eficiência.

Para incorporar novas aplicações aos ambientes de data center, as equipes de IT enfrentam três desafios comuns:

- Atender às intensas demandas de recursos gráficos, computacionais e de rede das aplicações modernas;

- Fazer a manutenção de aplicações com workflows complexos e

- Lidar com uma nova infraestrutura isolada quando as aplicações não podem usar recursos compartilhados.

Felizmente, a computação acelerada e os avanços na unificação de arquiteturas de data center podem solucionar esses problemas. Porém, primeiro, vamos conhecer os três principais obstáculos da IT corporativaUma onda de mudança no cenário de aplicativos fez com que as empresas se tornassem mais impulsionadas por dados com análises avançadas e IA, e desenvolvendo produtos com desktops virtuais ricos em gráficos..

Demandas Intensivas de Recursos

Aplicações modernas que usam muitos dados, como o treinamento de modelos de AI com o TensorFlow, exigem um grande número de ciclos de computação, e geralmente os modelos de AI operacionais precisam de respostas em tempo real. Além disso, muitas dessas cargas de trabalho podem ser dimensionadas, como um pipeline de preparação e análise de dados orquestrado pelo Apache Spark, que normalmente demanda grandes transferências de dados em vários sistemas.

Aplicações modernas que usam muitos dados, como o treinamento de modelos de AI com o TensorFlow, exigem um grande número de ciclos de computação, e geralmente os modelos de AI operacionais precisam de respostas em tempo real. Além disso, muitas dessas cargas de trabalho podem ser dimensionadas, como um pipeline de preparação e análise de dados orquestrado pelo Apache Spark, que normalmente demanda grandes transferências de dados em vários sistemas.

Designers e engenheiros são desafiados a criar produtos e conteúdo de melhor qualidade com imagens fotorrealistas mais rapidamente. Além disso, agora que muitas pessoas estão trabalhando em casa, as aplicações de desktop virtual estão exigindo mais recursos gráficos do que nunca. O vídeo e o áudio, por exemplo, precisam ser de alta qualidade para que as aplicações de videochamada sejam eficazes.

As infraestruturas tradicionais de data center não conseguem oferecer a potência computacional necessária para executar essas aplicações e atender aos níveis de serviço exigidos pelos negócios.

Workflows Complexos

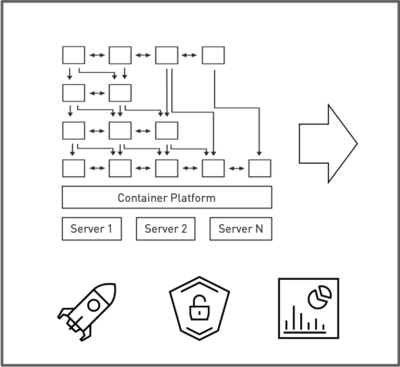

As aplicações modernas também estão passando a ter uma arquitetura nativa no cloud, na qual um grande número de microsserviços em contêineres são organizados em workflows complexos.

As aplicações modernas também estão passando a ter uma arquitetura nativa no cloud, na qual um grande número de microsserviços em contêineres são organizados em workflows complexos.

Os clusters lógicos de aplicações são acionados, desativados e dimensionados rapidamente conforme a variação da demanda. Com isso, surgem desafios de gerenciamento, escalabilidade, segurança e visibilidade. Além disso, esse aumento de tamanho e escala gera um grande volume de tráfego de rede no data center, o que está se tornando outro problema para garantir os níveis de serviço desejados.

Novas Aplicações, Novos Silos

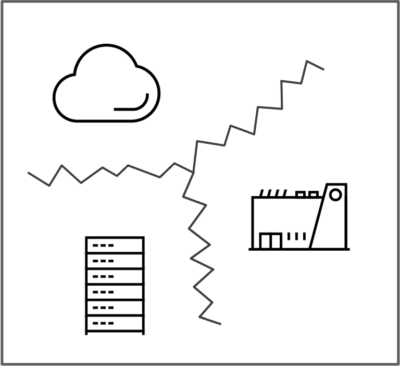

Por causa dos desafios relacionados às demandas de recursos e da complexidade dos workflows, as organizações geralmente acabam implementando essas aplicações em clusters de uso único no local ou no cloud.

Por causa dos desafios relacionados às demandas de recursos e da complexidade dos workflows, as organizações geralmente acabam implementando essas aplicações em clusters de uso único no local ou no cloud.

Esses novos silos exigem processos, protocolos, conjuntos de ferramentas e, às vezes, até mesmo equipes para gerenciar a infraestrutura. Como essas aplicações não se encaixam no formato padrão, elas não podem usar a infraestrutura otimizada que executa a maioria das aplicações empresariais.

O resultado é uma sobrecarga operacional maior, e geralmente esses silos não atendem aos padrões de visibilidade, segurança e governança da IT. Isso ocorre principalmente se as equipes organizacionais deixam de recorrer à equipe de IT e vão direto ao cloud público.

A Solução para Esses Desafios da IT Empresarial

Para superar esses desafios, a IT empresarial pode usar ferramentas baseadas nos avanços mais atuais em virtualização de servidores, infraestrutura definida por software, recursos de cloud híbrido e, mais recentemente, orquestração de aplicações nativas no cloud e em contêineres.

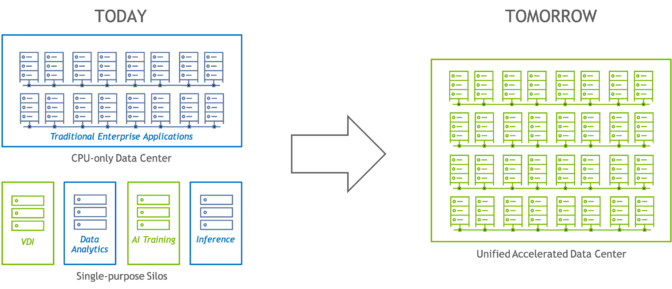

Uma solução é mudar a infraestrutura de IT empresarial na qual aplicações modernas e tradicionais podem ser executadas da melhor forma possível com um grupo compartilhado de recursos.

Atualmente, a maioria das aplicações empresariais no data center são executadas com um grupo compartilhado de recursos gerenciados por uma plataforma de virtualização ou orquestração. Essa estratégia maximiza o uso da infraestrutura principal e aumenta a eficiência operacional. Assim, todas as outras aplicações que não podem usar o grupo compartilhado são executadas em um silo, no qual a eficiência operacional é bem mais baixa.

Atualmente, a maioria das aplicações empresariais no data center são executadas com um grupo compartilhado de recursos gerenciados por uma plataforma de virtualização ou orquestração. Essa estratégia maximiza o uso da infraestrutura principal e aumenta a eficiência operacional. Assim, todas as outras aplicações que não podem usar o grupo compartilhado são executadas em um silo, no qual a eficiência operacional é bem mais baixa.

Em colaboração com os principais parceiros de plataforma, como a VMware e a Red Hat, a NVIDIA está mudando a arquitetura de data center para que aplicações modernas que exigem uma infraestrutura acelerada possam ser executadas com aplicações tradicionais usando Sistemas Certificados pela NVIDIA, sistemas operacionais e plataformas de gerenciamento otimizados nos últimos 15 anos.

Essas soluções são aceleradas pelas tecnologias da NVIDIA, como as potentes GPUs, os softwares de GPU virtual e a rede NVIDIA Mellanox, e são integradas às principais plataformas de virtualização e orquestração de contêineres. Com essa combinação, a equipe de IT tem mais facilidade no gerenciamento, na implementação, nas operações e no monitoramento.

Saiba mais sobre essa arquitetura e computação acelerada para IT empresarial.