À medida que a IA generativa e os grandes modelos de linguagem (LLMs) continuam a impulsionar as inovações, os requisitos de computação para treinamento e inferência cresceram em um ritmo surpreendente.

Para atender a essa necessidade, o Google Cloud anunciou a disponibilidade geral de suas novas instâncias A3, equipadas com GPUs NVIDIA H100 Tensor Core. Essas GPUs trazem um desempenho sem precedentes para todos os tipos de aplicações de IA com seu Transformer Engine construído especificamente para acelerar LLMs.

A disponibilidade das instâncias A3 vem na esteira da NVIDIA ser nomeada Generative AI Partner of the Year do Google Cloud, um prêmio que reconhece a colaboração profunda e contínua das empresas para acelerar a IA generativa no Google Cloud.

O esforço conjunto assume várias formas, desde o design da infraestrutura até a ampla habilitação de software, para facilitar a criação e a implantação de aplicações de IA na plataforma Google Cloud.

Na conferência Google Cloud Next, o fundador e CEO da NVIDIA, Jensen Huang, se juntou ao CEO do Google Cloud, Thomas Kurian, para a palestra do evento para celebrar a disponibilidade geral das instâncias A3 alimentadas por GPU NVIDIA H100 e falar sobre como o Google está usando as GPUs NVIDIA H100 e A100 para pesquisa interna e inferência em sua DeepMind e outras divisões.

Durante a discussão, Huang apontou para os níveis mais profundos de colaboração que permitiram a aceleração da GPU NVIDIA para o framework PaxML para criar LLMs massivos. Este framework de machine learning baseado em Jax foi desenvolvido especificamente para treinar modelos em larga escala, permitindo experimentação e paralelização avançadas e totalmente configuráveis.

O PaxML foi usado pelo Google para construir modelos internos, incluindo o DeepMind, bem como projetos de pesquisa, e usará GPUs NVIDIA. As empresas também anunciaram que o PaxML está disponível imediatamente no registro de contêineres NVIDIA NGC.

Ampliam-se as Startups de IA Generativa

Hoje, existem mais de mil startups de IA generativa construindo aplicações de próxima geração, muitos usando a tecnologia NVIDIA no Google Cloud. Alguns notáveis incluem Writer e Runway.

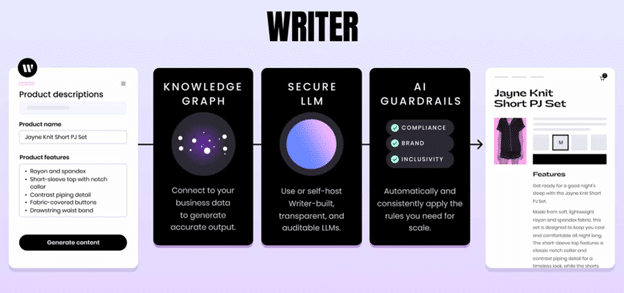

A Writer usa LLMs baseados em transformers para permitir que as equipes de marketing criem rapidamente cópias para páginas da Web, blogs, anúncios e muito mais. Para fazer isso, a empresa aproveita o NVIDIA NeMo, um framework de aplicações do NVIDIA AI Enterprise que ajuda as empresas a organizar seus conjuntos de dados de treinamento, construir e personalizar LLMs e executá-los em produção em escala.

Usando otimizações do NeMo, os desenvolvedores da Writer passaram de trabalhar com modelos com centenas de milhões de parâmetros para modelos de 40 bilhões de parâmetros. A lista de clientes da startup inclui nomes conhecidos como Deloitte, L’Oreal, Intuit, Uber e muitas outras empresas da Fortune 500.

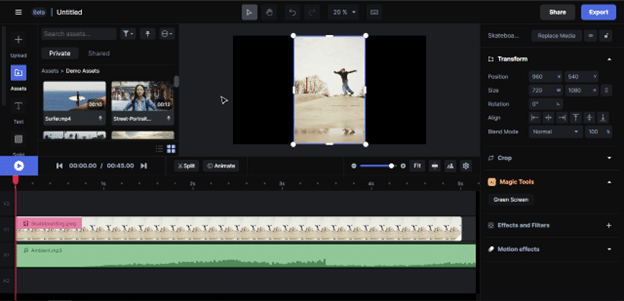

A Runway usa IA para gerar vídeos em qualquer estilo. O modelo de IA imita estilos específicos solicitados por determinadas imagens ou por meio de um prompt de texto. Os usuários também podem usar o modelo para criar novo conteúdo de vídeo usando imagens existentes. Essa flexibilidade permite que cineastas e criadores de conteúdo explorem e projetem vídeos de uma maneira totalmente nova.

O Google Cloud foi o primeiro CSP a trazer a GPU NVIDIA L4 para a nuvem. Além disso, as empresas colaboraram para permitir que o serviço Dataproc do Google aproveite o RAPIDS Accelerator para Apache Spark para fornecer aumentos significativos de desempenho para ETL, disponível hoje com Dataproc no Google Compute Engine e em breve para Serverless Dataproc.

As empresas também disponibilizaram o NVIDIA AI Enterprise no Google Cloud Marketplace e integraram o software de aceleração NVIDIA ao ambiente de desenvolvimento Vertex AI.

Encontre mais detalhes sobre instâncias de GPU da NVIDIA no Google Cloud e como a NVIDIA está potencializando a IA generativa e veja como as organizações estão executando suas aplicações corporativas de alta prioridade com o NVIDIA NeMo no Google Cloud acelerado por GPU.

Inscreva-se para receber notícias sobre IA generativa para se manter atualizado sobre os mais recentes avanços, desenvolvimentos e tecnologias.