As GPUs GeForce RTX 5090 e 5080 da NVIDIA — baseadas na inovadora arquitetura NVIDIA Blackwell — oferecem taxas de quadros até 8x mais rápidas com a tecnologia NVIDIA DLSS 4, menor latência com NVIDIA Reflex 2 e fidelidade gráfica aprimorada com shaders neurais NVIDIA RTX.

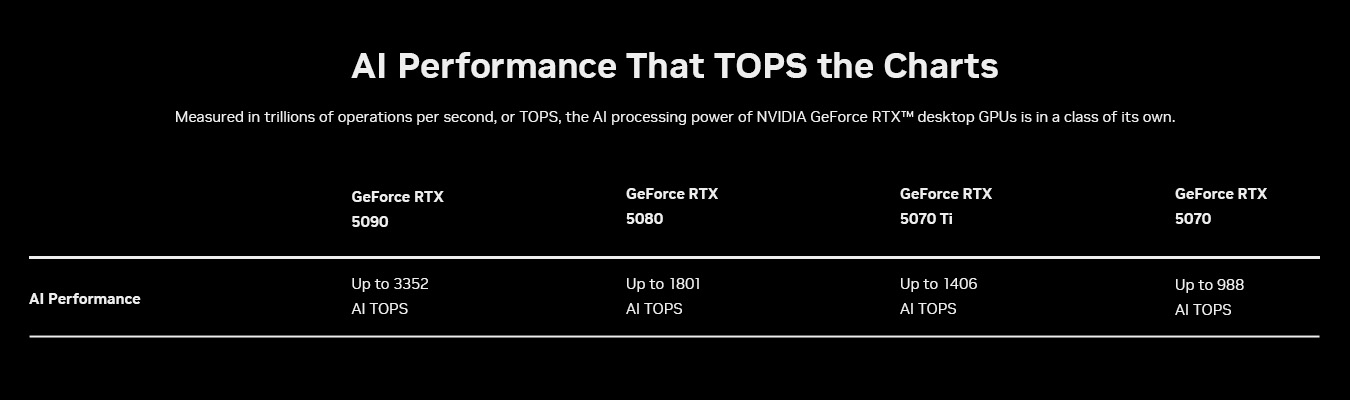

Essas GPUs foram criadas para acelerar as mais recentes cargas de trabalho de IA generativa, fornecendo até 3.352 trilhões de operações de IA por segundo (TOPS), permitindo experiências incríveis para entusiastas de IA, jogadores, criadores e desenvolvedores.

Para ajudar desenvolvedores e entusiastas de IA a aproveitar esses recursos, a NVIDIA revelou na feira CES do mês passado o NVIDIA NIM e o AI Blueprints para RTX. Os NVIDIA NIM microservices são modelos de IA generativa pré-empacotados que permitem que desenvolvedores e entusiastas comecem facilmente com IA generativa, iterem rapidamente e aproveitem o poder do RTX para acelerar a IA em PCs com Windows. Os NVIDIA AI Blueprints são projetos de referência que mostram aos desenvolvedores como usar microsserviços NIM para criar a próxima geração de experiências de IA.

NIM e AI Blueprints são otimizados para GPUs GeForce RTX Série 50. Essas tecnologias funcionam perfeitamente juntas para ajudar desenvolvedores e entusiastas a criar, iterar e entregar experiências de IA de ponta em PCs de IA.

NVIDIA NIM acelera IA generativa em PCs

Embora o desenvolvimento de modelos de IA esteja avançando rapidamente, levar essas inovações para PCs continua sendo um desafio para muitas pessoas. Modelos postados em plataformas como Hugging Face devem ser curados, adaptados e quantizados para rodar em PC. Eles também precisam ser integrados em novas interfaces de programação de aplicativos (APIs) de IA para garantir compatibilidade com ferramentas existentes e convertidos em backends de inferência otimizados para desempenho máximo.

Os NVIDIA NIM microservices para PCs e workstations RTX com IA podem facilitar a complexidade desse processo ao fornecer acesso a modelos de IA desenvolvidos pela NVIDIA e conduzidos pela comunidade. Esses microsserviços são fáceis de baixar e conectar por meio de APIs padrão do setor e abrangem as principais modalidades essenciais para PCs de IA. Eles também são compatíveis com uma ampla gama de ferramentas de IA e oferecem opções de implantação flexíveis, seja em PCs, em data centers ou na nuvem.

Os NIM microservices incluem tudo o que é necessário para executar modelos otimizados em PCs com GPUs RTX, incluindo mecanismos pré-criados para GPUs específicas, o kit de desenvolvimento de software (SDK) NVIDIA TensorRT, a biblioteca NVIDIA TensorRT-LLM de código aberto para inferência acelerada usando Tensor Cores e muito mais.

A Microsoft e a NVIDIA trabalharam juntas para habilitar NIM microservices e Blueprints de IA para RTX no Windows Subsystem for Linux (WSL2). Com o WSL2, os mesmos contêineres de IA que rodam em GPUs de data center agora podem rodar eficientemente em PCs RTX, facilitando para os desenvolvedores criar, testar e implantar modelos de IA em todas as plataformas.

Além disso, os NIM e os AI Blueprints aproveitam as principais inovações da arquitetura Blackwell na qual a série GeForce RTX 50 foi construída, incluindo Tensor Cores de quinta geração e suporte para precisão FP4.

Núcleos tensores impulsionam o desempenho da IA de última geração

Os cálculos de IA são incrivelmente exigentes e exigem grandes quantidades de poder de processamento. Seja gerando imagens e vídeos ou entendendo a linguagem e tomando decisões em tempo real, os modelos de IA dependem de centenas de trilhões de operações matemáticas para serem concluídas a cada segundo. Para acompanhar, os computadores precisam de hardware especializado construído especificamente para IA.

Em 2018, as GPUs NVIDIA GeForce RTX mudaram o jogo ao introduzir os Tensor Cores — processadores de IA dedicados projetados para lidar com essas cargas de trabalho intensivas. Ao contrário dos núcleos de computação tradicionais, os Tensor Cores são criados para acelerar a IA realizando cálculos de forma mais rápida e eficiente. Essa inovação ajudou a trazer jogos com tecnologia de IA, ferramentas criativas e aplicativos de produtividade para o mainstream.

A arquitetura Blackwell leva a aceleração de IA para o próximo nível. Os Tensor Cores de quinta geração em GPUs Blackwell oferecem até 3.352 TOPS de IA para lidar com tarefas de IA ainda mais exigentes e executar simultaneamente vários modelos de IA. Isso significa experiências mais rápidas orientadas por IA, desde renderização em tempo real até assistentes inteligentes, que abrem caminho para maior inovação em jogos, criação de conteúdo e muito mais.

FP4 — Modelos menores, maior desempenho

Outra maneira de otimizar o desempenho da IA é por meio da quantização, uma técnica que reduz o tamanho dos modelos, permitindo que eles sejam executados mais rapidamente e reduzindo os requisitos de memória.

Insira o FP4 — um formato de quantização avançado que permite que modelos de IA rodem mais rápido e mais enxutos sem comprometer a qualidade da saída. Comparado com o FP16, ele reduz o tamanho do modelo em até 60% e mais que dobra o desempenho, com degradação mínima.

Por exemplo, o modelo FLUX.1 [dev] da Black Forest Labs no FP16 requer mais de 23 GB de VRAM, o que significa que ele só pode ser suportado pela GeForce RTX 4090 e GPUs profissionais. Com o FP4, o FLUX.1 [dev] requer menos de 10 GB, então ele pode rodar localmente em mais GPUs GeForce RTX.

Em uma GeForce RTX 4090 com FP16, o modelo FLUX.1 [dev] pode gerar imagens em 15 segundos com apenas 30 passos. Com uma GeForce RTX 5090 com FP4, as imagens podem ser geradas em pouco mais de cinco segundos.

O FP4 é suportado nativamente pela arquitetura Blackwell, tornando mais fácil do que nunca implantar IA de alto desempenho em PCs locais. Ele também é integrado aos microsserviços NIM, otimizando efetivamente modelos que antes eram difíceis de quantificar. Ao permitir um processamento de IA mais eficiente, o FP4 ajuda a trazer experiências de IA mais rápidas e inteligentes para a criação de conteúdo.

Projetos de IA impulsionam fluxos de trabalho avançados de IA em PCs RTX

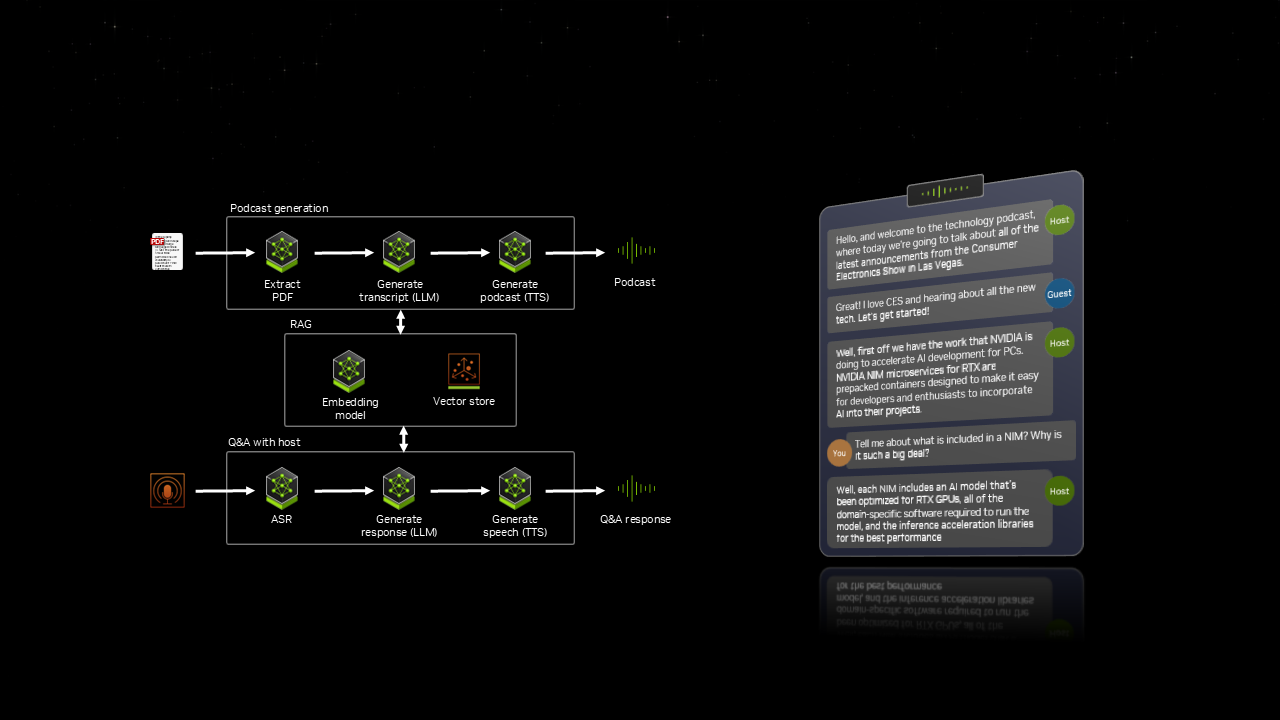

Os NVIDIA AI Blueprints, criados com NIM microservices, fornecem implementações de referência otimizadas e pré-empacotadas que facilitam o desenvolvimento de projetos avançados com tecnologia de IA, seja para humanos digitais, geradores de podcast ou assistentes de aplicativos.

Na CES, a NVIDIA demonstrou o PDF to Podcast, um blueprint que permite aos usuários converter um PDF em um podcast divertido e até mesmo criar uma sessão de perguntas e respostas com o apresentador do podcast de IA depois. Esse fluxo de trabalho integra sete modelos de IA diferentes, todos trabalhando em sincronia para oferecer uma experiência dinâmica e interativa.

Com o AI Blueprints, os usuários podem rapidamente passar da experimentação ao desenvolvimento de IA em PCs e workstations RTX.

Blueprints de NIM e IA em breve para PCs e workstations RTX

A IA generativa está expandindo os limites do que é possível em jogos, criação de conteúdo e muito mais. Com NIM microservices e AI Blueprints, os últimos avanços em IA não estão mais limitados à nuvem — eles agora estão otimizados para PCs RTX. Com GPUs RTX, desenvolvedores e entusiastas podem experimentar, construir e implementar IA localmente, diretamente de seus PCs e workstations.

Os NIM microservices e os Blueprints de IA chegarão em breve, com suporte inicial de hardware para GPUs profissionais GeForce RTX 50 Series, GeForce RTX 4090 e 4080 e NVIDIA RTX 6000 e 5000. GPUs adicionais serão suportadas no futuro.