O Black Forest Labs, um dos principais laboratórios de pesquisa de IA do mundo, acaba de mudar o jogo no que se trata de geração de imagens.

Os modelos de imagem FLUX.1 do laboratório conquistaram atenção global por fornecerem visuais de alta qualidade com aderência excepcional e rapidez. Agora, com seu novo modelo FLUX.1 Kontext, o laboratório está mudando fundamentalmente a forma como os usuários podem orientar e refinar o processo de geração de imagens.

Para obter os resultados desejados, os artistas de IA hoje costumam usar uma combinação de modelos e ControlNets — modelos de IA que ajudam a guiar as saídas de um gerador de imagens. Isso geralmente envolve a combinação de vários ControlNets ou o uso de técnicas avançadas como a usada no NVIDIA AI Blueprint para geração de imagens guiadas em 3D, em que um rascunho de cena 3D é usado para determinar a composição de uma imagem.

O novo modelo FLUX.1 Kontext simplifica isso ao fornecer um único modelo que pode executar tanto a geração quanto a edição de imagens, usando linguagem natural.

A NVIDIA colaborou com a Black Forest Labs para otimizar o FLUX.1 Kontext [dev] para GPUs NVIDIA RTX usando o kit de desenvolvimento de software NVIDIA TensorRT e quantização para fornecer inferência mais rápida com menores requisitos de VRAM.

Para criadores e desenvolvedores, as otimizações do TensorRT significam edições mais rápidas, iterações mais suaves e mais controle — diretamente de suas máquinas com tecnologia RTX.

O FLUX.1 Kontext [dev] Flex: Geração de imagens em contexto

Em maio, a Black Forest Labs introduziu a família de modelos de imagem FLUX.1 Kontext, que aceita prompts de texto e imagem.

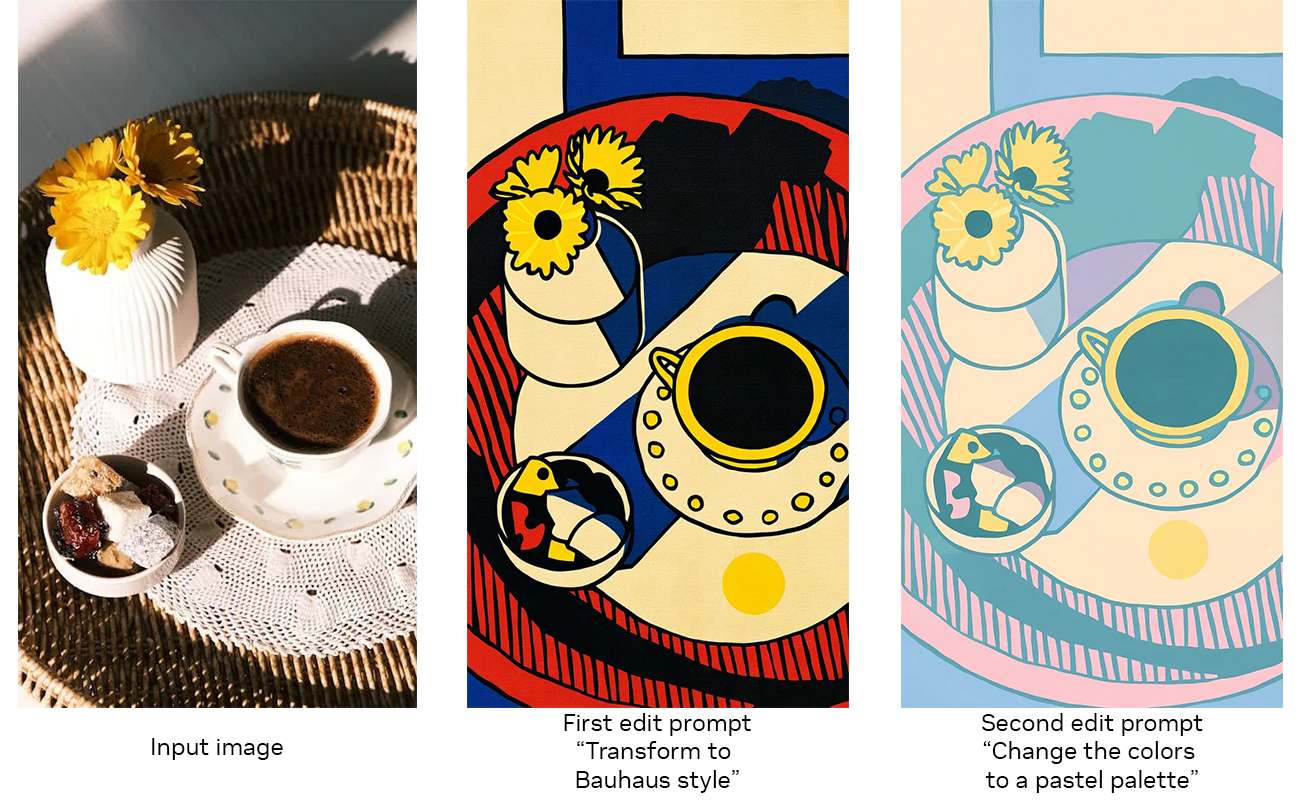

Esses modelos permitem que os usuários comecem a partir de uma imagem de referência e orientem as edições com linguagem simples, sem a necessidade de ajustes finos ou workflows complexos com vários ControlNets.

O FLUX.1 Kontext é um modelo generativo aberto desenvolvido para edição de imagens, utilizando um processo de geração guiado e passo a passo que facilita o controle da evolução de uma imagem, seja refinando pequenos detalhes ou transformando uma cena inteira. Como o modelo aceita entradas de texto e imagem, os usuários podem facilmente referenciar um conceito visual e orientar sua evolução de forma natural e intuitiva. Isso permite edições de imagem coerentes e de alta qualidade, fiéis ao conceito original.

Os principais recursos do FLUX.1 Kontext incluem:

- Consistência dos personagens: preserve características únicas em várias cenas e ângulos.

- Edição localizada: modifique elementos específicos sem alterar o restante da imagem.

- Transferência de estilo: aplique a aparência de uma imagem de referência a novas cenas.

- Desempenho em tempo real: a geração de baixa latência oferece suporte a iteração e feedback rápidos.

Na semana passada, o Black Forest Labs lançou os pesos FLUX.1 Kontext para download no Hugging Face, bem como as variantes aceleradas pelo TensorRT correspondentes.

Tradicionalmente, a edição avançada de imagens exigia instruções complexas e máscaras, mapas de profundidade ou mapas de bordas difíceis de criar. O FLUX.1 Kontext [dev] apresenta uma interface muito mais intuitiva e flexível, combinando edições passo a passo com otimização de ponta para inferência de modelos de difusão.

O modelo [dev] enfatiza flexibilidade e controle. Ele oferece suporte a recursos como consistência de caracteres, preservação de estilo e ajustes de imagem localizados, com funcionalidade ControlNet integrada para prompts visuais estruturados.

O FLUX.1 Kontext [dev] já está disponível no ComfyUI e no Black Forest Labs Playground, com uma versão do NVIDIA NIM Microservices prevista para ser lançada em agosto.

Otimizado para RTX com aceleração TensorRT

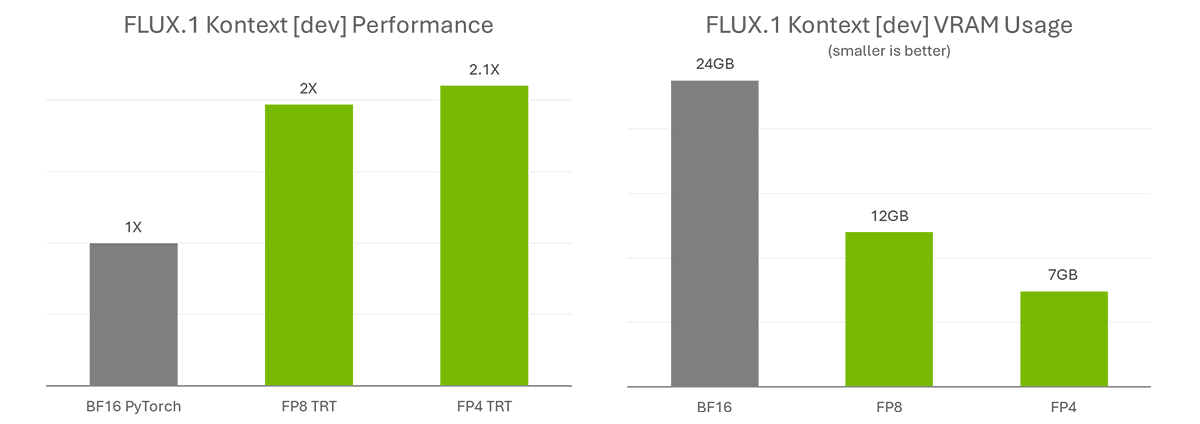

O FLUX.1 Kontext [dev] acelera a criatividade simplificando workflows complexos. Para otimizar ainda mais o trabalho e ampliar a acessibilidade, a NVIDIA e a Black Forest Labs colaboraram para quantizar o modelo — reduzindo os requisitos de VRAM para que mais pessoas possam executá-lo localmente — e o otimizaram com o TensorRT para dobrar seu desempenho.

A etapa de quantização permite que o tamanho do modelo seja reduzido de 24 GB para 12 GB no FP8 (Ada) e 7 GB no FP4 (Blackwell). O ponto de verificação do FP8 é otimizado para GPUs GeForce RTX Série 40, que possuem aceleradores FP8 em seus Tensor Cores. O ponto de verificação do FP4 é otimizado para GPUs GeForce RTX Série 50 pelo mesmo motivo e utiliza um novo método chamado SVDQuant, que preserva a alta qualidade da imagem enquanto reduz o tamanho do modelo.

TensorRT — uma estrutura para acessar os Tensor Cores em GPUs NVIDIA RTX para desempenho máximo — fornece aceleração de mais de 2x em comparação com a execução do modelo BF16 original com PyTorch.

Saiba mais sobre as otimizações da NVIDIA e como começar a usar o FLUX.1 Kontext [dev] no Blog Técnico da NVIDIA.

Comece a usar o FLUX.1 Kontext

FLUX.1 Kontext [dev] está disponível no Hugging Face (Torch e TensorRT).

Entusiastas de IA interessados em testar esses modelos podem baixar as variantes do Torch e usá-las no ComfyUI. O Black Forest Labs também disponibilizou um ambiente online para testar o modelo.

Para usuários avançados e desenvolvedores, a NVIDIA está trabalhando em um código de exemplo para facilitar a integração de pipelines do TensorRT em workflows. Confira o repositório DemoDiffusion, que será lançado ainda este mês.

Mas espere, tem mais!

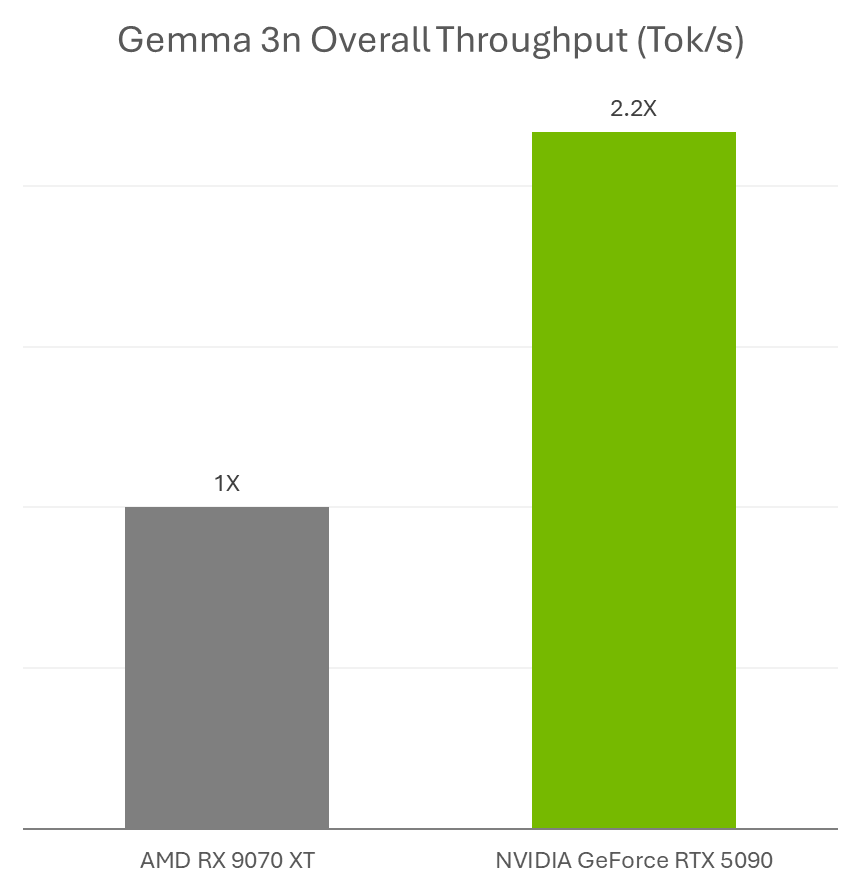

Na semana passada, o Google anunciou o lançamento do Gemma 3n, um novo modelo de linguagem pequena multimodal ideal para execução em GPUs NVIDIA GeForce RTX e na plataforma NVIDIA Jetson para IA de ponta e robótica.

Entusiastas de IA podem usar modelos Gemma 3n com acelerações RTX no Ollama e Llama.cpp com seus aplicativos favoritos, como AnythingLLM e LM Studio.

Além disso, os desenvolvedores podem implementar facilmente modelos Gemma 3n usando o Ollama e se beneficiar das acelerações RTX. Saiba mais sobre como executar o Gemma 3n no Jetson e no RTX.

Além disso, o Hackathon Plug and Play: Project G-Assist Plug-In da NVIDIA — que acontece virtualmente até quarta-feira, 16 de julho — convida desenvolvedores a explorar a IA e criar plug-ins G-Assist personalizados. Anot a data para o webinar sobre o G-Assist Plug-In na quarta-feira, 9 de julho, das 10h às 11h (horário do Pacífico), para saber mais sobre os recursos e fundamentos do Project G-Assist e participar de uma sessão de perguntas e respostas ao vivo.

Participe do servidor Discord da NVIDIA para se conectar com desenvolvedores da comunidade e entusiastas de IA para discussões sobre o que é possível com RTX com IA.

A cada semana, a série de blogs RTX AI Garage apresenta inovações e conteúdo de IA voltados para a comunidade para aqueles que desejam aprender mais sobre microsserviços NVIDIA NIM e AI Blueprints, além de criar agentes de IA , fluxos de trabalho criativos, humanos digitais, aplicativos de produtividade e muito mais em PCs e workstations de IA.

Conecte-se ao NVIDIA AI PC no Facebook , Instagram , TikTok e X — e mantenha-se informado assinando o boletim informativo RTX AI PC.

Siga a NVIDIA Workstation no LinkedIn e no X.

Veja o aviso sobre informações do produto de software.