Na esteira do ChatGPT, todas as empresas estão tentando descobrir sua estratégia de IA, trabalho que rapidamente levanta a questão: e a segurança?

Alguns podem se sentir sobrecarregados com a perspectiva de garantir novas tecnologias. A boa notícia é que as políticas e práticas em vigor hoje fornecem excelentes pontos de partida.

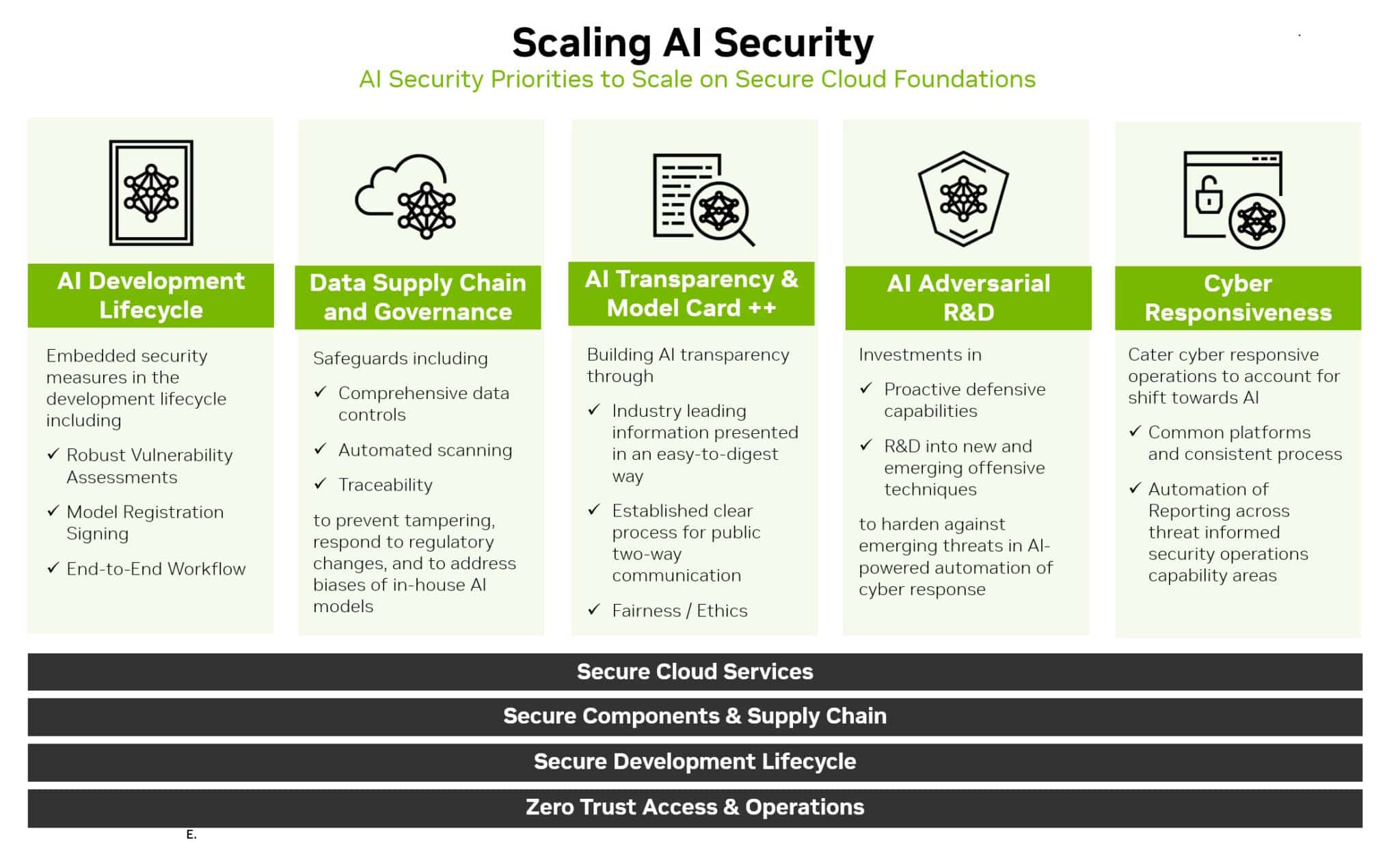

Na verdade, o caminho a seguir está em estender as bases existentes de segurança corporativa e na nuvem. É uma jornada que pode ser resumida em seis passos:

- Expandir a análise das ameaças

- Ampliar os mecanismos de resposta

- Proteger a cadeia de fornecimento de dados

- Usar a IA para dimensionar esforços

- Ser transparente

- Criar melhorias contínuas

Aprecie o Horizonte Expandido

O primeiro passo é se familiarizar com o novo cenário.

A segurança agora precisa cobrir o ciclo de vida de desenvolvimento de IA. Isso inclui novas superfícies de ataque, como dados de treinamento, modelos e as pessoas e processos que os utilizam.

Extrapolar os tipos conhecidos de ameaças para identificar e antecipar as emergentes. Por exemplo, um invasor pode tentar alterar o comportamento de um modelo de IA acessando dados enquanto está treinando o modelo em um serviço na nuvem.

Os pesquisadores de segurança e as equipes que investigaram vulnerabilidades no passado serão ótimos recursos novamente. Eles precisarão de acesso a sistemas e dados de IA para identificar e agir em novas ameaças, bem como ajudar a construir relacionamentos de trabalho sólidos com a equipe de ciência de dados.

Ampliar as Defesas

Uma vez que ameaças sejam identificadas, defina maneiras de se defender delas.

Monitore o desempenho do modelo de IA de perto. Suponha que ele irá derivar, abrindo novas superfícies de ataque, assim como pode ser assumido que as defesas de segurança tradicionais serão violadas.

Também se baseie nas práticas de PSIRT (Equipe de Resposta a Incidentes de Segurança do Produto) que já deveriam estar em vigor.

Por exemplo, a NVIDIA lançou políticas de segurança de produtos que abrangem seu portfólio de IA. Várias empresas, incluindo o Open Worldwide Application Security Project, lançaram implementações personalizadas por IA dos principais elementos de segurança, como o método comum de enumeração de vulnerabilidades usado para identificar ameaças tradicionais de IT.

Adapte e aplique a modelos de IA e workflows de defesas tradicionais como:

- Manter o controle de rede e os planos de dados separados

- Remover quaisquer dados de identificação pessoais ou inseguros

- Usar segurança e autenticação de confiança zero

- Definir logs de eventos, alertas e testes apropriados

- Definir controles de fluxo quando apropriado

- Estender as salvaguardas existentes

- Proteger os conjuntos de dados usados para treinar modelos de IA. Eles são valiosos e vulneráveis.

Mais uma vez, as empresas podem aproveitar as práticas existentes. Crie cadeias seguras de fornecimento de dados, semelhantes às criadas para proteger canais para software. É importante estabelecer controle de acesso para dados de treinamento, assim como outros dados internos são protegidos.

Algumas lacunas podem necessitar ser preenchidas. Hoje, os especialistas em segurança sabem como usar arquivos hash de aplicações para garantir que ninguém tenha alterado seu código. Esse processo pode ser desafiador para escalar conjuntos de dados do tamanho de petabytes usados para treinamento de IA.

A boa notícia é que os pesquisadores veem a necessidade e estão trabalhando em ferramentas para resolvê-la.

Dimensione a Segurança com IA

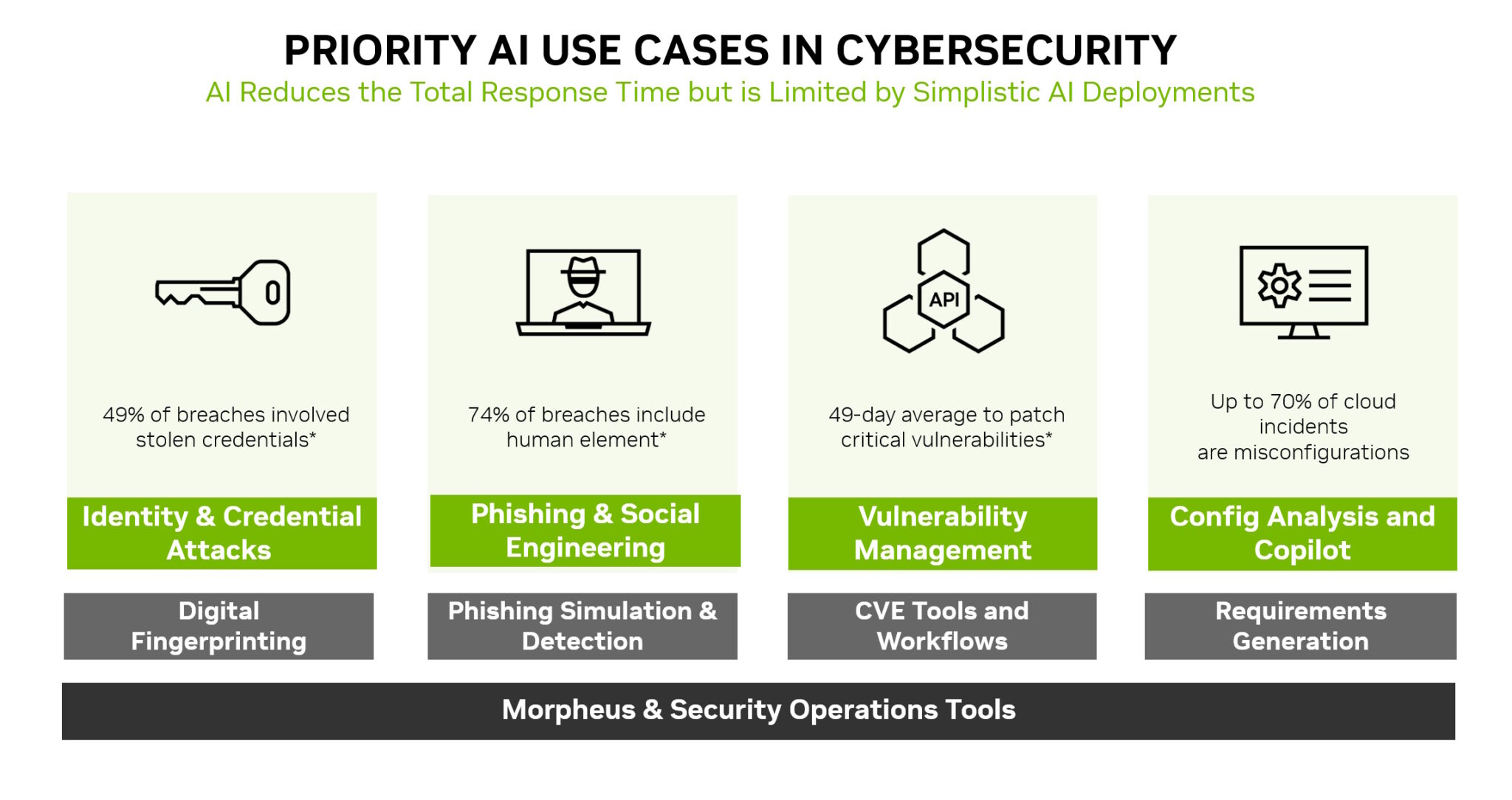

A IA não é apenas uma nova área de ataque para defender, é também uma nova e poderosa ferramenta de segurança.

Os modelos de machine learning podem detectar mudanças sutis que nenhum ser humano pode ver em montanhas de tráfego de rede. Isso torna a IA uma tecnologia ideal para prevenir muitos dos ataques mais usados, como roubo de identidade, phishing, malware e ransomware.

O NVIDIA Morpheus, um framework de segurança cibernética, pode criar aplicações de IA que criam, leem e atualizam impressões digitais que verificam muitos tipos de ameaças. Além disso, a IA generativa e o Morpheus podem permitir novas maneiras de detectar tentativas de spear phishing.

Segurança Adora Clareza

A transparência é um componente-chave de qualquer estratégia de segurança. Informe os clientes sobre quaisquer novas políticas e práticas de segurança de IA que tenham sido implementadas.

Por exemplo, a NVIDIA publica detalhes sobre os modelos de IA no NGC, seu hub para software acelerado. Chamados de cartões modelo, eles agem como declarações de verdade em empréstimos, descrevendo IAs, os dados nos quais foram treinados e quaisquer restrições para seu uso.

A NVIDIA usa um conjunto expandido de campos em seus cartões modelo, para que os usuários tenham clareza sobre o histórico e os limites de uma rede neural antes de colocá-la em produção. Isso ajuda a promover a segurança, estabelecer confiança e garantir que os modelos sejam robustos.

Definir Viagens, Não Destinos

Esses seis passos são apenas o começo de uma jornada. Processos e políticas como esses precisam evoluir.

A prática emergente da computação confidencial, por exemplo, está estendendo a segurança em serviços na nuvem, onde os modelos de IA geralmente são treinados e executados em produção.

A indústria já está começando a ver versões básicas de scanners de código para modelos de IA. Eles são um sinal do que está por vir. As equipes precisam ficar de olho no horizonte para as melhores práticas e ferramentas à medida que chegam.

Ao longo do caminho, a comunidade precisa compartilhar o que aprende. Um excelente exemplo disso ocorreu no recente Generative Red Team Challenge.

No fim das contas, trata-se de criar uma defesa coletiva. Estamos todos fazendo essa jornada para a segurança de IA juntos, um passo de cada vez.