Para enfrentar um dos maiores desafios da computação da história, é necessária muita computação.

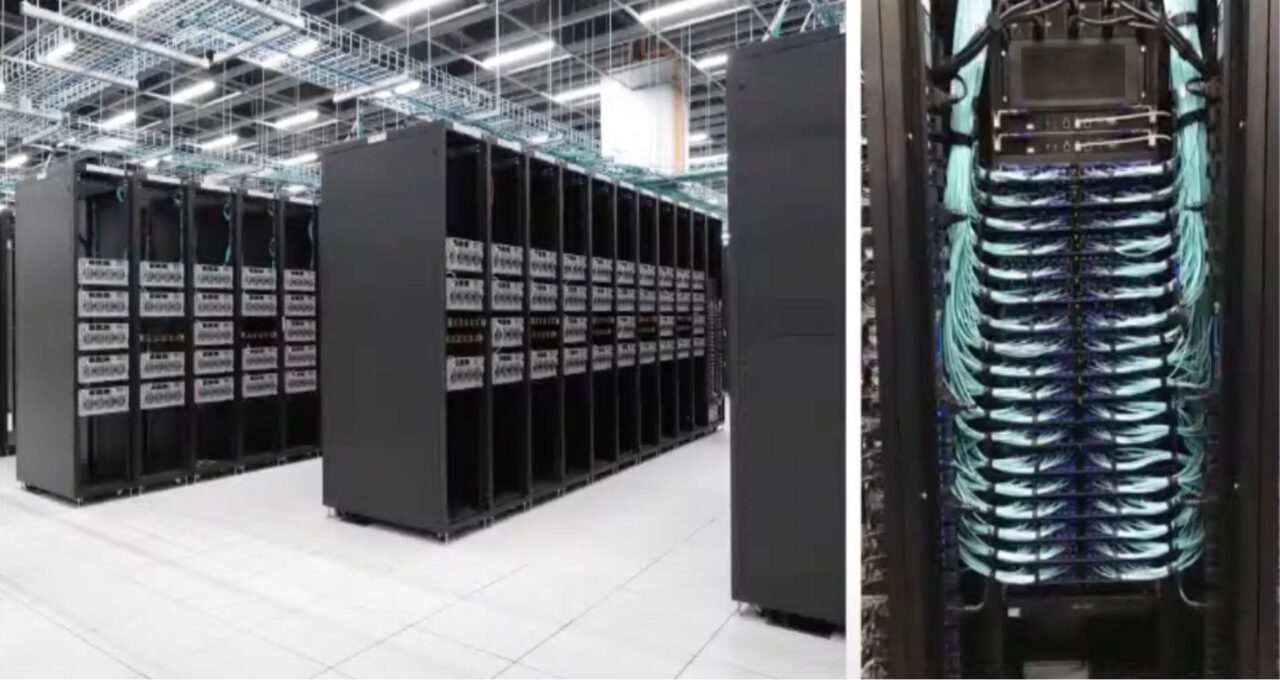

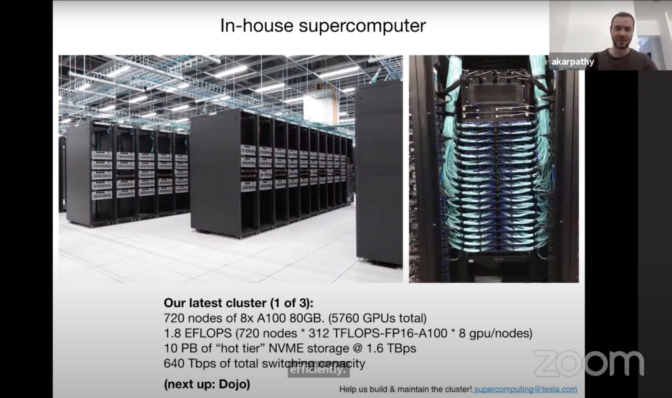

Na CVPR em junho passado, Andrej Karpathy, diretor sênior de AI da Tesla, revelou o supercomputador interno que a montadora está usando para treinar redes neurais profundas para os recursos de piloto automático e condução autônoma. O cluster usa 720 nós de 8 GPUs NVIDIA A100 Tensor Core (5.760 GPUs ao todo) para garantir um desempenho líder de 1,8 exaflops.

“Esse supercomputador é muito incrível. Acredito mesmo que, em matéria de flops, ele deve ser o 5º melhor supercomputador do mundo”, afirmou Karpathy.

Com níveis inéditos de computação para o setor automotivo no ciclo de desenvolvimento, a Tesla está possibilitando que engenheiros de automóveis autônomos façam seu trabalho com eficiência e inovação.

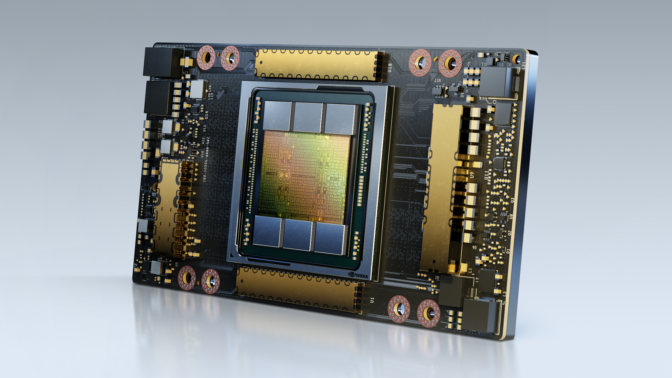

As GPUs NVIDIA A100 oferecem aceleração em todas as escalas para agilizar os data centers de melhor desempenho do mundo. Com a arquitetura NVIDIA Ampere, a GPU A100 oferece um desempenho até 20 vezes melhor que o da geração anterior e pode ser particionada em sete instâncias de GPU para se ajustar dinamicamente às demandas em mudança.

O cluster de GPUs faz parte da solução de condução autônoma com integração vertical da Tesla, que usa mais de 1 milhão de carros já presentes na estrada para refinar e criar recursos para a melhoria contínua.

Do Carro ao Data Center

O desenvolvimento cíclico da Tesla começa no carro. Uma rede neural profunda executada no “modo oculto” percebe e faz previsões enquanto o carro está rodando sem de fato controlar o automóvel.

Essas previsões e os erros ou as falhas de identificação são todos registrados. Os engenheiros da Tesla usam as instâncias para criar um conjunto de dados de treinamento de cenários difíceis e diversos para refinar a DNN.

O resultado é uma coleção de cerca de 1 milhão de clipes de 10 segundos gravados a 36 frames por segundo, totalizando o valor impressionante de 1,5 petabyte de dados. Depois, a DNN é executada nesses cenários no data center várias vezes até que ela funcione sem nenhum erro. Por fim, ela é enviada de volta para o veículo e começa o processo novamente.

Karpathy contou que treinar uma DNN dessa forma e com um volume tão grande de dados exige “uma potência computacional enorme”, o que levou a Tesla a construir e implantar o supercomputador da geração atual com GPUs A100 de alto desempenho.

Iteração Contínua

Além do treinamento extensivo, o supercomputador da Tesla oferece aos engenheiros de automóveis autônomos o desempenho necessário para experimentar e fazer iterações no processo de desenvolvimento.

Karpathy explicou que a atual estrutura de DNNs que a montadora está implantando permite que uma equipe de 20 engenheiros trabalhe em uma única rede ao mesmo tempo, isolando diferentes características para o desenvolvimento paralelo.

Essas DNNs podem ser executadas em conjuntos de dados de treinamento em velocidades mais rápidas do que antes para iterações rápidas.

“A visão computacional é basicamente o que fazemos, e ela possibilita o piloto automático. Para que ela funcione, precisamos treinar uma rede neural grande e fazer vários testes. É por isso que investimos muito na computação”, declarou Karpath