A computação moderna de alto desempenho (HPC) está permitindo mais do que apenas cálculos rápidos: ela está impulsionando sistemas de IA que estão desbloqueando avanços científicos.

A HPC passou por muitas iterações, cada uma desencadeada por um reaproveitamento criativo de tecnologias. Por exemplo, os primeiros supercomputadores usavam componentes prontos para uso. Mais tarde, os pesquisadores construíram clusters poderosos a partir de computadores pessoais e até adaptaram placas gráficas de jogos para trabalhos científicos.

Os sistemas HPC de hoje, muitos impulsionados pela computação acelerada da NVIDIA, são projetados para velocidade. A mais recente lista TOP500 dos supercomputadores mais poderosos do mundo, revelada na ISC 2025, ressalta isso, com a NVIDIA impulsionando 77% dos sistemas da lista.

Ao mesmo tempo, recursos inovadores como o Tensor Cores fornecem cálculos mais rápidos para operações comuns, como multiplicação de matrizes, e o aumento do uso de técnicas como precisão mista (uma técnica que combina vários formatos de precisão de ponto flutuante mais abaixo) estão aumentando o desempenho e a eficiência energética, impulsionando saltos em campos como ciência climática e medicina.

NVIDIA Capacita Líderes do TOP500

A NVIDIA continua a liderar o caminho em supercomputação, impulsionando 381 sistemas da última lista TOP500. Isso inclui uma nova entrada no top 10, o supercomputador JUPITER do Jülich Supercomputing Centre, que estreou em 4º lugar.

Oitenta e três dos 100 principais sistemas do TOP500 agora usam computação acelerada em comparação com apenas 17 que usam apenas CPUs.

Além disso, os dois principais sistemas da última lista Green500 dos supercomputadores FP64 mais eficientes em termos de energia do mundo são equipados com NVIDIA GH200 Grace Hopper Superchips, e nove dos 10 principais são acelerados pela NVIDIA.

Tensor Cores Para Ciência

O desempenho da IA não vem apenas do aumento do volume de operações de ponto flutuante. Cada vez mais, está enraizado na fusão de hardware com software, como por meio do uso de Tensor Cores.

Os Tensor Cores são componentes avançados dentro das GPUs NVIDIA criadas para acelerar as operações da matriz, os principais cálculos por trás da IA e de deep learning. Ao lidar com cálculos complexos com mais eficiência, eles aceleram processos como treinamento e inferência de modelos.

Os Tensor Cores permitem cálculos mais rápidos para operações de matriz comuns, especialmente à medida que as empresas migram para precisões mais baixas, como FP8 para treinamento de modelos, quase dobrando a taxa de transferência a cada passo para baixo na precisão, mantendo a precisão. Atualmente, apenas determinadas operações em cargas de trabalho de simulação podem aproveitar os Tensor Cores. Essas operações geralmente são uma pequena fração do tempo de execução total e raramente são consequentes para o desempenho geral entregue.

À medida que mais e mais espaço físico nas GPUs está sendo dedicado a Tensor Cores de baixa precisão construídos para IA, isso oferece uma oportunidade para a comunidade HPC redirecionar novamente o hardware para avançar na descoberta científica.

Para permitir isso, a NVIDIA está investindo em novos métodos para usar Tensor Cores para um conjunto maior de casos de uso relevantes para a simulação científica.

Um artigo de Yuki Uchino, do RIKEN Center for Computational Science, e Katsuhisa Ozaki, professor do Shibaura Institute of Technology, demonstraram como unidades inteiras em GPUs podem atingir precisão arbitrária, incluindo FP64, usando os Aceleradores de Multiplicação de Matriz Inteira em Tensor Cores e um algoritmo chamado esquema de Ozaki.

Inspirada por esse esquema, a NVIDIA está desenvolvendo bibliotecas para acelerar cálculos de tensores e matrizes de alta precisão usando um conjunto maior de GPUs com Tensor Core, com foco em maior precisão, desempenho e eficiência energética.

O uso dessas bibliotecas já demonstrou alguns benefícios surpreendentes: uma simulação de silício com cerca de 1.000 átomos expostos à luz ultravioleta foi executada 1,8 vezes mais rápido usando as bibliotecas do que com o hardware FP64, ao mesmo tempo em que forneceu resultados idênticos, economizando tempo e energia.

Com a ajuda dessas novas bibliotecas, simulações comuns de HPC, como BerkeleyGW, em breve poderá aproveitar os Tensor Cores de baixa precisão, permitindo saltos no desempenho e na eficiência energética.

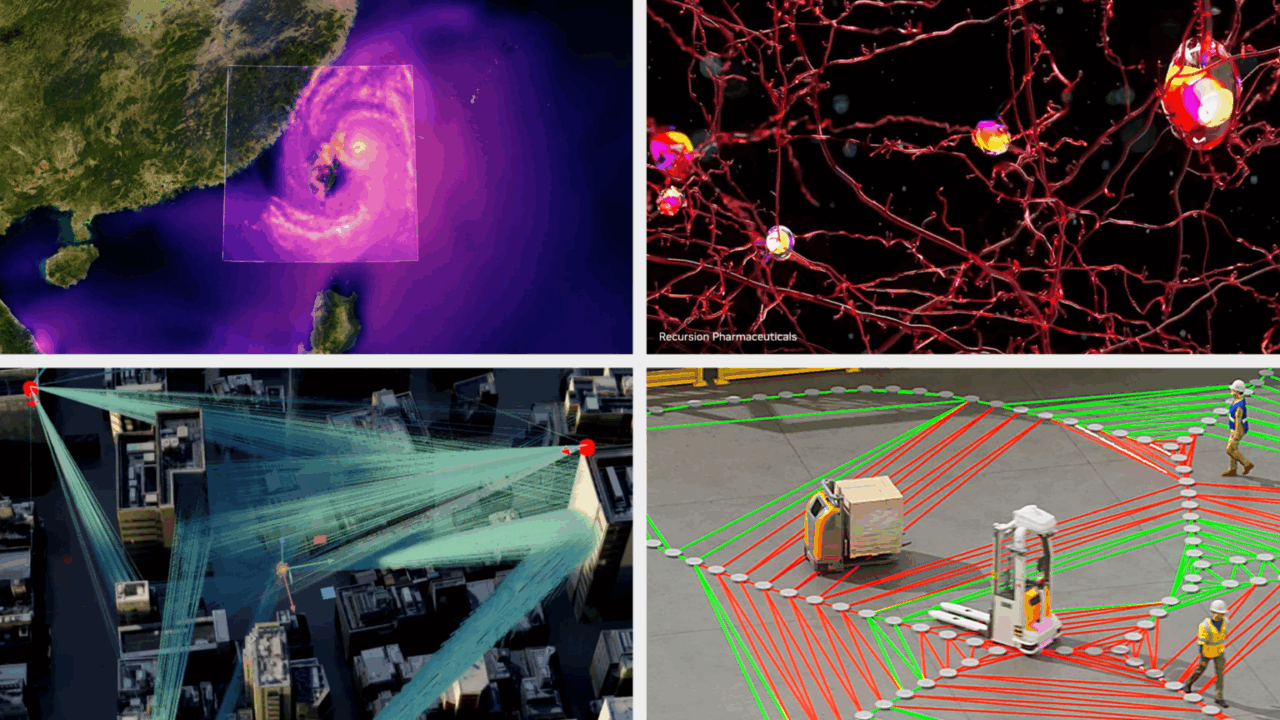

A Supercomputação de IA Avança a Ciência

Embora a lista TOP500 destaque a velocidade de alta precisão dos supercomputadores de hoje, ela não conta a história de seu incrível impacto impulsionando a descoberta científica com precisão mista e IA.

No ano passado, os prêmios Nobel de química e física reconheceram pesquisadores que usam IA, incluindo Demis Hassabis e John Jumper, que ganharam os prêmios por seu trabalho no modelo AlphaFold do Google DeepMind para previsão de estrutura de proteínas, e Geoff Hinton, professor emérito da Universidade de Toronto, e John Hopfield, professor emérito da Universidade de Princeton, foram homenageados pelo avanço das arquiteturas de redes neurais.

O prestigioso Prêmio Gordon Bell de computação de alto desempenho também foi para a equipe de David Keyes na KAUST por seus métodos de precisão mista emulando o enorme conjunto de dados climáticos ERA5, que fornece estimativas horárias de variáveis atmosféricas, de superfície terrestre e de ondas oceânicas dos últimos 80 anos com 137 níveis de altitude da superfície até uma altura de 80 km.

A precisão mista é uma técnica que combina vários formatos de precisão de ponto flutuante. O uso de tipos de dados de baixa precisão pode fornecer desempenho e eficiência aprimorados, permitindo que as aplicações usem menos recursos e aumentem o desempenho.

O uso de precisão mista na ciência está se tornando mais comum à medida que os cientistas constroem novos modelos de IA para acelerar os workflows científicos.

No Reino Unido, o sistema Isambard-AI da Universidade de Bristol, desenvolvido pela NVIDIA Grace Hopper, usou precisão mista para treinar modelos como o Nightingale AI.

O Nightingale AI, desenvolvido sob a liderança do Prof. Aldo Faisal, é um modelo base multimodal para área da saúde e pesquisa biomédica, integrando imagens, cardiologia e registros eletrônicos de saúde. Ao contrário de outros grandes modelos de linguagem da área da saúde, o Nightingale AI não usa apenas raciocínio baseado em texto: em vez disso, baseia-se em padrões de imagem e técnicas de diagnóstico padrão para fornecer insights médicos, usando grandes quantidades de dados do paciente. O objetivo da Nightingale AI é servir como base para outras aplicações da área da saúde, incluindo assistentes de consultório médico e sistemas de triagem de telessaúde.

Usando precisão mista, o Isambard-AI alcançou a escala massiva e a precisão precisa necessárias para treinar LLMs multimodais como o Nightingale AI sem exigir hardware excessivo para treinamento ou inferência.

Rumo à Próxima Iteração de HPC

A combinação de computação acelerada, tecnologias avançadas de tensores e métodos de precisão mista está transformando a ciência computacional, demonstrando o potencial para ainda mais avanços habilitados para IA.

Com sistemas como o JUPITER se juntando ao TOP500, trabalhos emergentes sobre o uso de IA para fins científicos, como o Isambard-AI e inovações como o método de emulação Ozaki acelerando o desempenho do Tensor Core para tarefas de alta precisão, uma nova era está surgindo.

Os supercomputadores continuarão a ficar mais rápidos em algumas medidas, mas a velocidade por si só não é suficiente. Encontrar novos insights para questões científicas importantes dependerá de abordagens inteligentes e flexíveis que acelerem a descoberta sem comprometer o rigor científico para atender às necessidades das comunidades científicas e de HPC e do mundo.