As GPUs têm sido chamadas de metais raros da Terra (até mesmo o ouro) da inteligência artificial, porque são fundamentais para a era da IA generativa de hoje.

Três razões técnicas, e muitas histórias, explicam por que isso acontece. Cada razão tem várias facetas que valem a pena explorar, mas em geral:

- As GPUs empregam processamento paralelo

- Os sistemas de GPU escalam até alturas de supercomputação

- O stack de software de GPU para IA é amplo e profundo

O resultado líquido é que as GPUs realizam cálculos técnicos mais rapidamente e com maior eficiência energética do que as CPUs. Isso significa que eles oferecem desempenho líder para treinamento e inferência de IA, bem como ganhos em uma ampla gama de aplicações que usam computação acelerada.

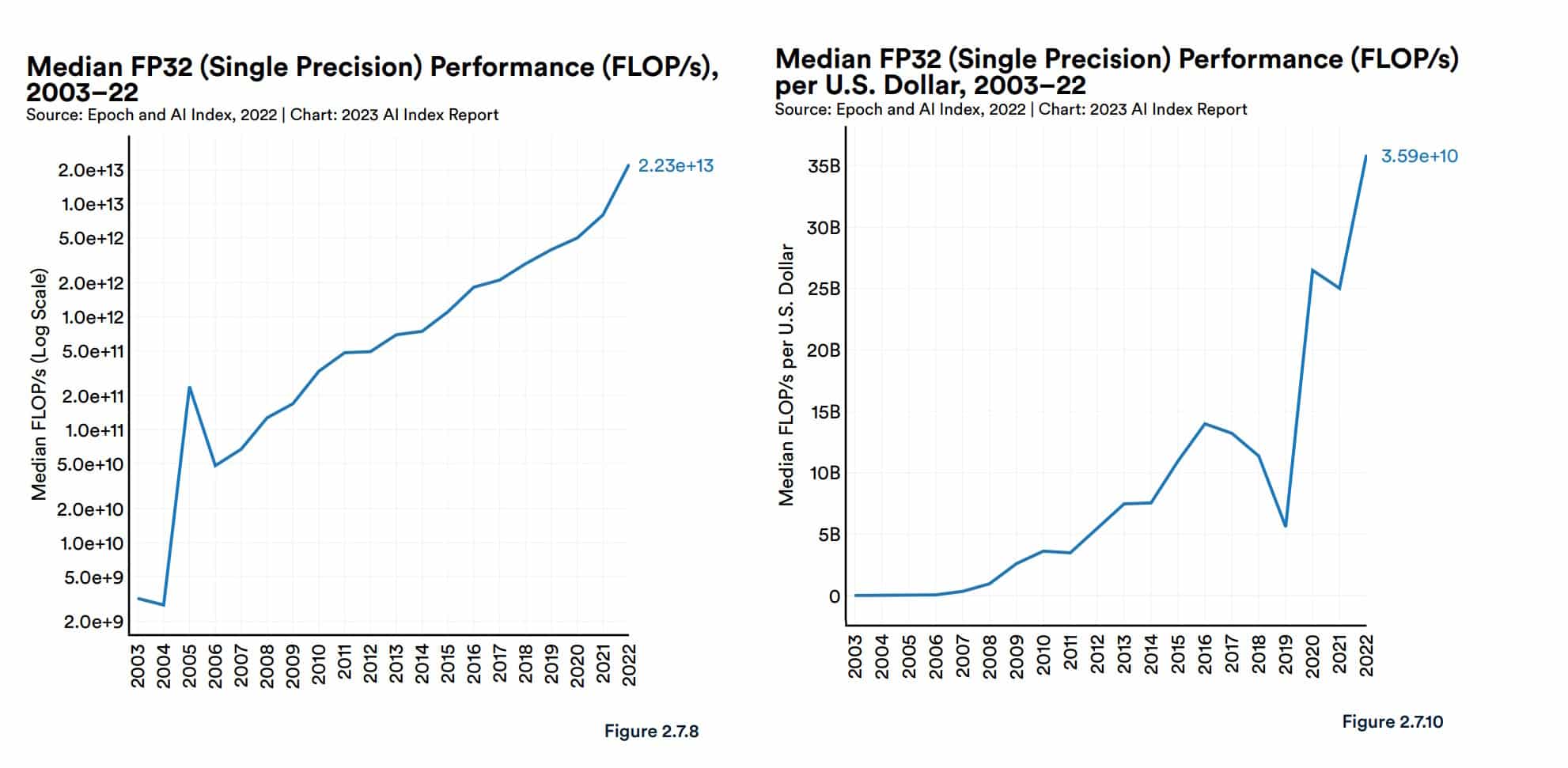

Em seu recente relatório sobre IA, o grupo de IA Centrada no Ser Humano da Universidade de Stanford forneceu algum contexto. O desempenho da GPU “aumentou cerca de 7.000 vezes” desde 2003 e o preço por desempenho é “5.600 vezes maior”, informou.

O relatório também citou análises da Epoch, um grupo de pesquisa independente que mede e prevê os avanços da IA.

“As GPUs são a plataforma de computação dominante para acelerar as cargas de trabalho de machine learning, e a maioria (se não todos) dos maiores modelos nos últimos cinco anos foram treinados em GPUs… [eles] contribuíram centralmente para o progresso recente em IA”, disse a Epoch em seu site.

Um estudo de 2020 avaliando a tecnologia de IA para o governo dos EUA chegou a conclusões semelhantes.

“Esperamos que os chips de IA [de ponta] sejam de uma a três ordens de magnitude mais econômicos do que as CPUs de nó líder ao contar os custos de produção e operação”, disse.

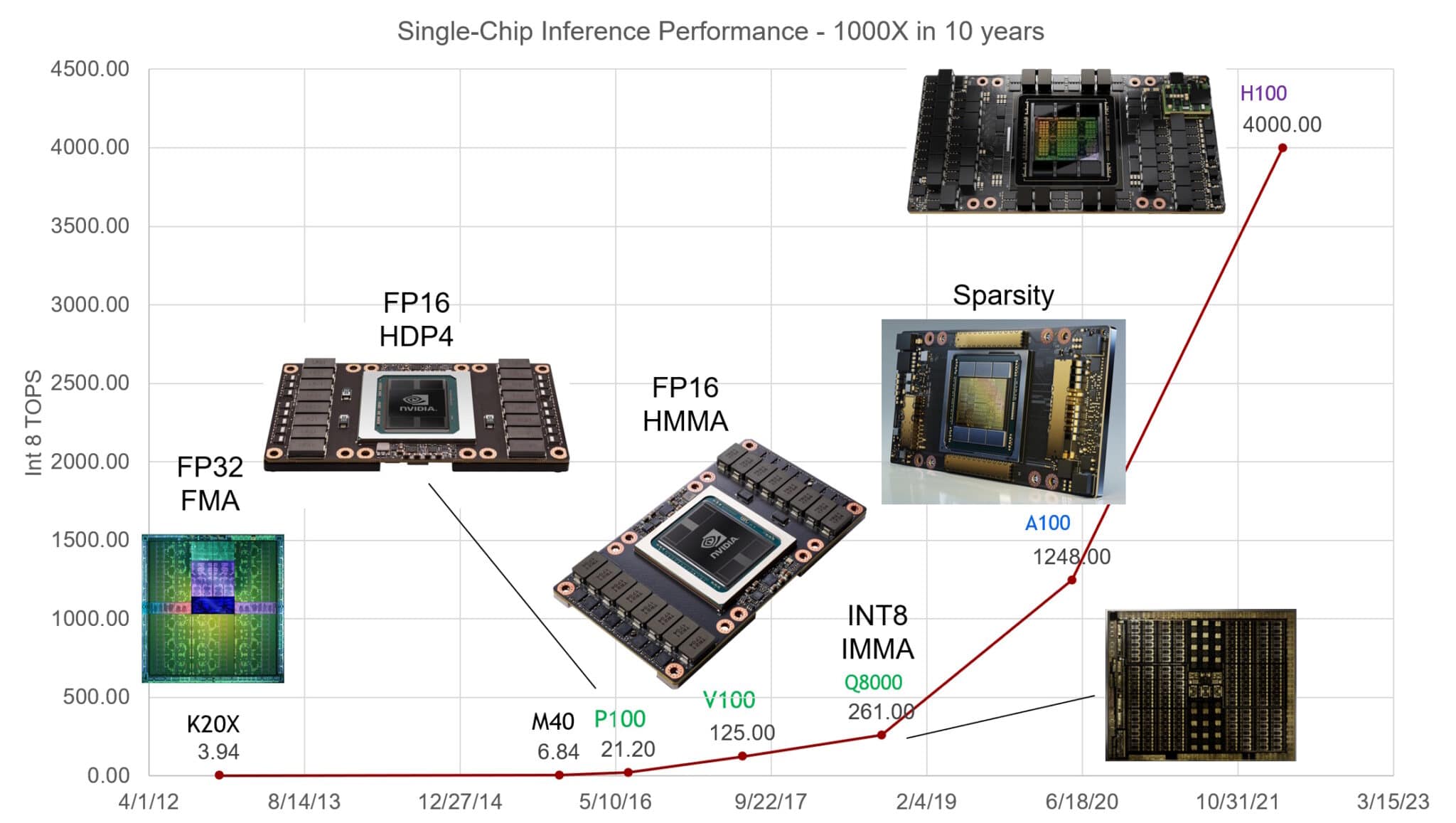

As GPUs NVIDIA aumentaram o desempenho na inferência de IA em 1.000 vezes nos últimos dez anos, disse Bill Dally, cientista-chefe da empresa, em uma apresentação especial no Hot Chips, um encontro anual de engenheiros de semicondutores e sistemas.

ChatGPT Espalhar a Notícia

O ChatGPT forneceu um exemplo poderoso de como as GPUs são ótimas para IA. Os grandes modelos de linguagem (LLM), treinados e executados em milhares de GPUs NVIDIA, realizam serviços de IA generativa usados por mais de 100 milhões de pessoas.

Desde seu lançamento em 2018, o MLPerf, o benchmark padrão da indústria para IA, forneceu números que detalham o desempenho líder das GPUs NVIDIA tanto no treinamento quanto na inferência de IA.

Por exemplo, o Superchip NVIDIA Grace Hopper dominou a última rodada de testes de inferência. O NVIDIA TensorRT-LLM, software de inferência lançado desde esse teste, oferece um aumento de até 8 vezes no desempenho e uma redução de mais de 5 vezes no uso de energia e no custo total de propriedade. De fato, as GPUs NVIDIA venceram todas as rodadas de treinamento e testes de inferência MLPerf desde que o benchmark foi lançado em 2019.

Em fevereiro, as GPUs NVIDIA entregaram resultados líderes para inferência, servindo milhares de inferências por segundo nos modelos mais exigentes no benchmark STAC-ML Markets, um importante indicador de desempenho de tecnologia para o setor de serviços financeiros.

Uma equipe de engenharia de software da RedHat disse sucintamente em um blog: “As GPUs se tornaram a base da inteligência artificial”.

IA Sob o Capô

Uma breve olhada sob o capô mostra por que GPUs e IA fazem um emparelhamento poderoso.

Um modelo de IA, também chamado de rede neural, é essencialmente uma lasanha matemática, feita de camada sobre camada de equações de álgebra linear. Cada equação representa a probabilidade de que um dado esteja relacionado a outro.

Por sua vez, as GPUs embalam milhares de núcleos, pequenas calculadoras trabalhando em paralelo para cortar a matemática que compõe um modelo de IA. Isso, em alto nível, é como a computação de IA funciona.

Núcleos Tensor Altamente Ajustados

Ao longo do tempo, os engenheiros da NVIDIA ajustaram os núcleos de GPU às necessidades em evolução dos modelos de IA. As GPUs mais recentes incluem Núcleos Tensor que são 60 vezes mais poderosos do que os designs de primeira geração para processar o uso de redes neurais matemáticas matriciais.

Além disso, as GPUs NVIDIA Hopper Tensor Core incluem um Transformer Engine que pode se ajustar automaticamente à precisão ideal necessária para processar modelos transformers, a classe de redes neurais que gerou IA generativa.

Ao longo do tempo, cada geração de GPU incorporou mais memória e técnicas otimizadas para armazenar um modelo inteiro de IA em uma única GPU ou conjunto de GPUs.

Modelos Crescem, Sistemas Se Expandem

A complexidade dos modelos de IA está se expandindo 10 vezes por ano.

O LLM atual de última geração, GPT4, contém mais de um trilhão de parâmetros, uma métrica de sua densidade matemática. Isso é acima de menos de 100 milhões de parâmetros para um LLM popular em 2018.

Os sistemas de GPU acompanharam o ritmo e se uniram ao desafio. Eles escalam para supercomputadores, graças às suas rápidas interconexões NVLink e redes NVIDIA Quantum InfiniBand.

Por exemplo, o DGX GH200, um supercomputador de IA de grande memória, combina até 256 Superchips NVIDIA GH200 Grace Hopper em uma única GPU do tamanho de um data center com 144 terabytes de memória compartilhada.

Cada superchip GH200 é um único servidor com 72 núcleos de CPU Arm Neoverse e quatro petaflops de desempenho de IA. Uma nova configuração de sistemas Grace Hopper de quatro vias coloca em um único nó de computação 288 núcleos Arm e 16 petaflops de desempenho de IA com até 2,3 terabytes de memória de alta velocidade.

E as GPUs NVIDIA H200 Tensor Core anunciadas em novembro embalam até 288 gigabytes da mais recente tecnologia de memória HBM3e.

Software Cobre a Orla

Um oceano em expansão de software de GPU evoluiu desde 2007 para permitir todas as facetas da IA, desde recursos de tecnologia profunda até aplicações de alto nível.

A plataforma de IA da NVIDIA inclui centenas de bibliotecas de software e aplicações. A linguagem de programação CUDA e a biblioteca cuDNN-X para deep learning fornecem uma base sobre a qual os desenvolvedores criaram softwares como o NVIDIA NeMo, um framework para permitir que os usuários criem, personalizem e executem inferência em seus próprios modelos de IA generativa.

Muitos desses elementos estão disponíveis como software de código aberto, o básico dos desenvolvedores de software. Mais de uma centena deles são empacotados na plataforma NVIDIA AI Enterprise para empresas que exigem total segurança e suporte. Cada vez mais, eles também estão disponíveis nos principais provedores de serviços de nuvem como APIs e serviços no NVIDIA DGX Cloud.

O SteerLM, uma das mais recentes atualizações de software de IA para GPUs NVIDIA, permite que os usuários ajustem os modelos durante a inferência.

Um Incremento de Velocidade de 70 Vezes em 2008

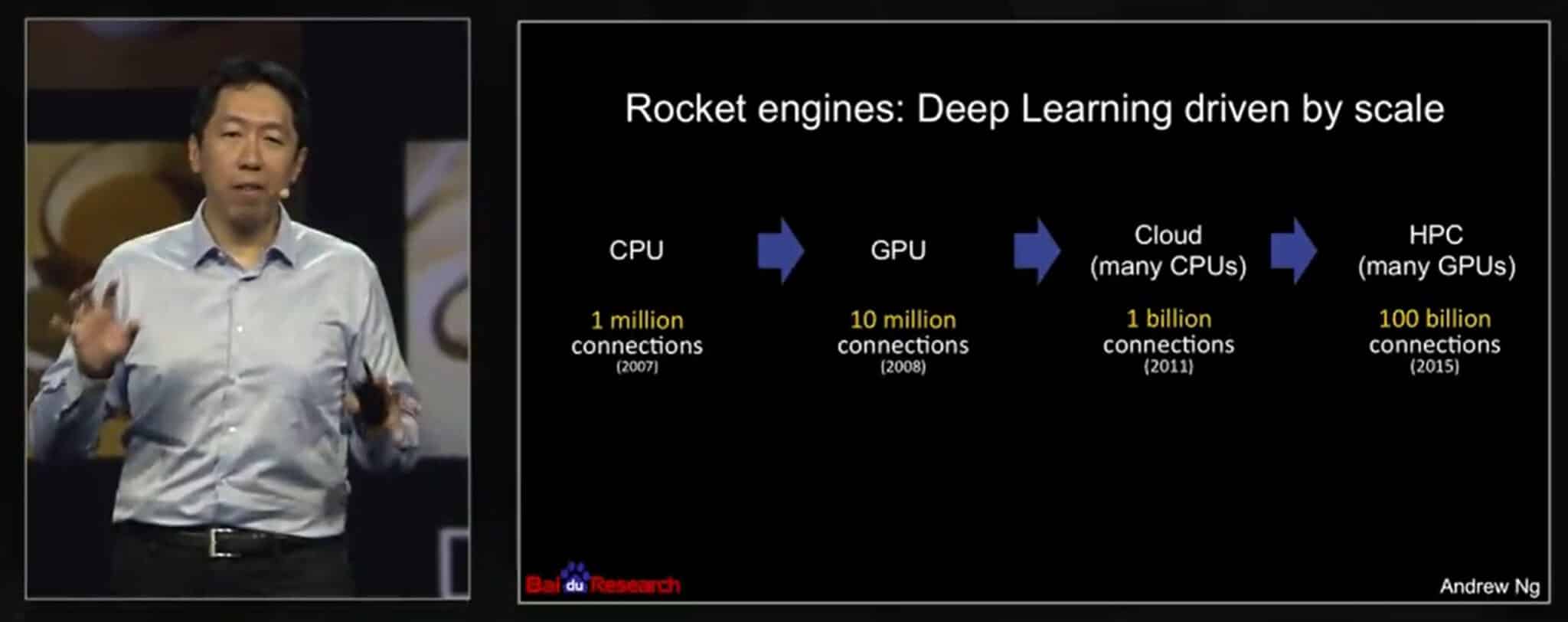

As histórias de sucesso remontam a um artigo de 2008 do pioneiro da IA Andrew Ng, então pesquisador de Stanford. Usando duas GPUs NVIDIA GeForce GTX 280, sua equipe de três pessoas conseguiu uma aceleração de 70 vezes em relação às CPUs que processam um modelo de IA com 100 milhões de parâmetros, terminando um trabalho que costumava exigir várias semanas em um único dia.

“Os processadores gráficos modernos superam em muito as capacidades computacionais das CPUs multicore e têm o potencial de revolucionar a aplicabilidade de métodos de deep learning não supervisionada”, relataram.

Em uma palestra de 2015 no GTC da NVIDIA, Ng descreveu como continuou usando mais GPUs para escalar seu trabalho, rodando modelos maiores no Google Brain e no Baidu. Mais tarde, ele ajudou a fundar o Coursera, uma plataforma de educação online onde ensinou centenas de milhares de estudantes de IA.

Ng conta com Geoff Hinton, um dos padrinhos da IA moderna, entre as pessoas que ele influenciou. “Lembro-me de ir a Geoff Hinton dizer para verificar CUDA, acho que pode ajudar a construir redes neurais maiores”, disse ele na palestra do GTC.

O professor da Universidade de Toronto espalhou a notícia. “Em 2009, lembro-me de dar uma palestra no NIPS [agora NeurIPS], onde disse a cerca de 1.000 pesquisadores que todos deveriam comprar GPUs porque as GPUs serão o futuro do machine learning”, disse Hinton em um relatório à imprensa.

Avance rapidamente com GPUs

Espera-se que os ganhos da IA repercutam em toda a economia global.

Um relatório da McKinsey em junho estimou que a IA generativa poderia adicionar o equivalente a US$ 2,6 trilhões a US$ 4,4 trilhões anuais nos 63 casos de uso analisados em setores como bancos, área da saúde e varejo. Portanto, não é surpresa que o relatório de IA de 2023 da Stanford disse que a maioria dos líderes empresariais espera aumentar seus investimentos em IA.

Hoje, mais de 40.000 empresas usam GPUs NVIDIA para IA e computação acelerada, atraindo uma comunidade global de 4 milhões de desenvolvedores. Juntos, eles estão avançando na ciência, na área da saúde, nas finanças e em praticamente todos os setores.

Entre as conquistas mais recentes, a NVIDIA descreveu uma aceleração de 700.000 vezes usando IA para reduzir as mudanças climáticas, mantendo o dióxido de carbono fora da atmosfera (veja o vídeo abaixo). É uma das muitas maneiras pelas quais a NVIDIA está aplicando o desempenho das GPUs à IA e além.

Saiba como as GPUs colocam a IA em produção.