A inteligência artificial, como qualquer tecnologia transformadora, é um trabalho em progresso, crescendo continuamente em suas capacidades e seu impacto social. Iniciativas de IA confiável reconhecem os efeitos do mundo real que a IA pode ter nas pessoas e na sociedade e visam canalizar esse poder de forma responsável para mudanças positivas.

O Que É IA Confiável?

A IA confiável é uma abordagem para o desenvolvimento de IA que prioriza a segurança e a transparência para aqueles que interagem com ela. Os desenvolvedores de IA confiável entendem que nenhum modelo é perfeito e tomam medidas para ajudar os clientes e o público em geral a entender como a tecnologia foi construída, seus casos de uso pretendidos e suas limitações.

Além de cumprir as leis de privacidade e proteção ao consumidor, modelos de IA confiável são testados para segurança e mitigação de vieses indesejados. Eles também são transparentes, fornecendo informações como benchmarks de precisão ou uma descrição do conjunto de dados de treinamento, para vários públicos, incluindo autoridades reguladoras, desenvolvedores e consumidores.

Princípios da IA Confiável

Princípios de IA confiáveis são fundamentais para o desenvolvimento de IA de ponta a ponta da NVIDIA. Eles têm um objetivo simples: permitir confiança e transparência na IA e apoiar o trabalho de parceiros, clientes e desenvolvedores.

Privacidade: Cumprindo os Regulamentos, Protegendo os Dados

A IA é frequentemente descrita como faminta por dados. Muitas vezes, quanto mais dados um algoritmo é treinado, mais precisas são suas previsões.

Mas os dados têm que vir de algum lugar. Para desenvolver IA confiável, é fundamental considerar não apenas quais dados estão legalmente disponíveis para uso, mas quais dados são socialmente responsáveis para usar.

Os desenvolvedores de modelos de IA que se baseiam em dados como imagem, voz, trabalho artístico ou registros de saúde de uma pessoa devem avaliar se os indivíduos forneceram consentimento apropriado para que suas informações pessoais sejam usadas dessa maneira.

Para instituições como hospitais e bancos, construir modelos de IA significa equilibrar a responsabilidade de manter os dados de pacientes ou clientes privados enquanto treina um algoritmo robusto. A NVIDIA criou uma tecnologia que permite o aprendizado federado, onde pesquisadores desenvolvem modelos de IA treinados em dados de várias instituições sem que informações confidenciais saiam dos servidores privados de uma empresa.

Os sistemas NVIDIA DGX e o software NVIDIA FLARE permitiram vários projetos de aprendizagem federada em serviços financeiros e da área de saúde, facilitando a colaboração segura de vários provedores de dados em modelos de IA mais precisos e generalizáveis para análise de imagens médicas e detecção de fraudes.

Segurança e Proteção: Evitando Danos Não Intencionais, Ameaças Maliciosas

Uma vez implantados, os sistemas de IA têm impacto no mundo real, por isso é essencial que eles funcionem como pretendido para preservar a segurança do usuário.

A liberdade de usar algoritmos de IA disponíveis publicamente cria imensas possibilidades para aplicações positivas, mas também significa que a tecnologia pode ser usada para fins não intencionais.

Para ajudar a mitigar os riscos, o NVIDIA NeMo Guardrails mantém os modelos de linguagem de IA no caminho certo, permitindo que os desenvolvedores corporativos estabeleçam limites para suas aplicações. Guardrails tópicas garantem que os chatbots se atenham a assuntos específicos. Os guardrails de segurança estabelecem limites para o idioma e as fontes de dados que as aplicações usam em suas respostas. Os guardrails de segurança buscam impedir o uso mal-intencionado de um grande modelo de linguagem conectado a aplicações de terceiros ou interfaces de programação de aplicações.

O NVIDIA Research está trabalhando com o programa SemaFor administrado pela Darpa para ajudar especialistas em perícia digital a identificar imagens geradas por IA. No ano passado, pesquisadores publicaram um novo método para abordar o viés social usando o ChatGPT. Eles também estão criando métodos para impressão digital de avatar, uma maneira de detectar se alguém está usando uma imagem animada por IA de outro indivíduo sem seu consentimento.

Para proteger dados e aplicações de IA contra ameaças de segurança, as GPUs NVIDIA H100 e H200 Tensor Core são construídas com computação confidencial, o que garante que dados confidenciais sejam protegidos durante o uso, seja implantado no local, na nuvem ou no edge. A Computação Confidencial da NVIDIA usa métodos de segurança baseados em hardware para garantir que entidades não autorizadas não possam visualizar ou modificar dados ou aplicações enquanto estão em execução, tradicionalmente um momento em que os dados são deixados vulneráveis.

Transparência: Tornando a IA Explicável

Para criar um modelo de IA confiável, o algoritmo não pode ser uma caixa preta: seus criadores, usuários e partes interessadas devem ser capazes de entender como a IA funciona para confiar em seus resultados.

A transparência na IA é um conjunto de melhores práticas, ferramentas e princípios de design que ajuda os usuários e outras partes interessadas a entender como um modelo de IA foi treinado e como ele funciona. A IA explicável, ou XAI, é um subconjunto de transparência que abrange ferramentas que informam às partes interessadas como um modelo de IA faz certas previsões e decisões.

Transparência e XAI são cruciais para estabelecer confiança nos sistemas de IA, mas não há uma solução universal para se adequar a todos os tipos de modelo de IA e partes interessadas. Encontrar a solução certa envolve uma abordagem sistemática para identificar quem a IA afeta, analisar os riscos associados e implementar mecanismos eficazes para fornecer informações sobre o sistema de IA.

A geração aumentada de recuperação, ou RAG, é uma técnica que avança a transparência da IA conectando serviços de IA generativa a bancos de dados externos autorizados, permitindo que os modelos citem suas fontes e forneçam respostas mais precisas. A NVIDIA está ajudando os desenvolvedores a começar com um fluxo de trabalho RAG que usa o framework NVIDIA NeMo para desenvolver e personalizar modelos de IA generativa.

A NVIDIA também faz parte do Consórcio do Instituto Nacional de Padrões e Tecnologia dos EUA do Instituto de Segurança de Inteligência Artificial (AISIC) para ajudar a criar ferramentas e padrões para o desenvolvimento e implantação responsáveis de IA. Como membro do consórcio, a NVIDIA promoverá IA confiável, aproveitando as melhores práticas para implementar a transparência do modelo de IA.

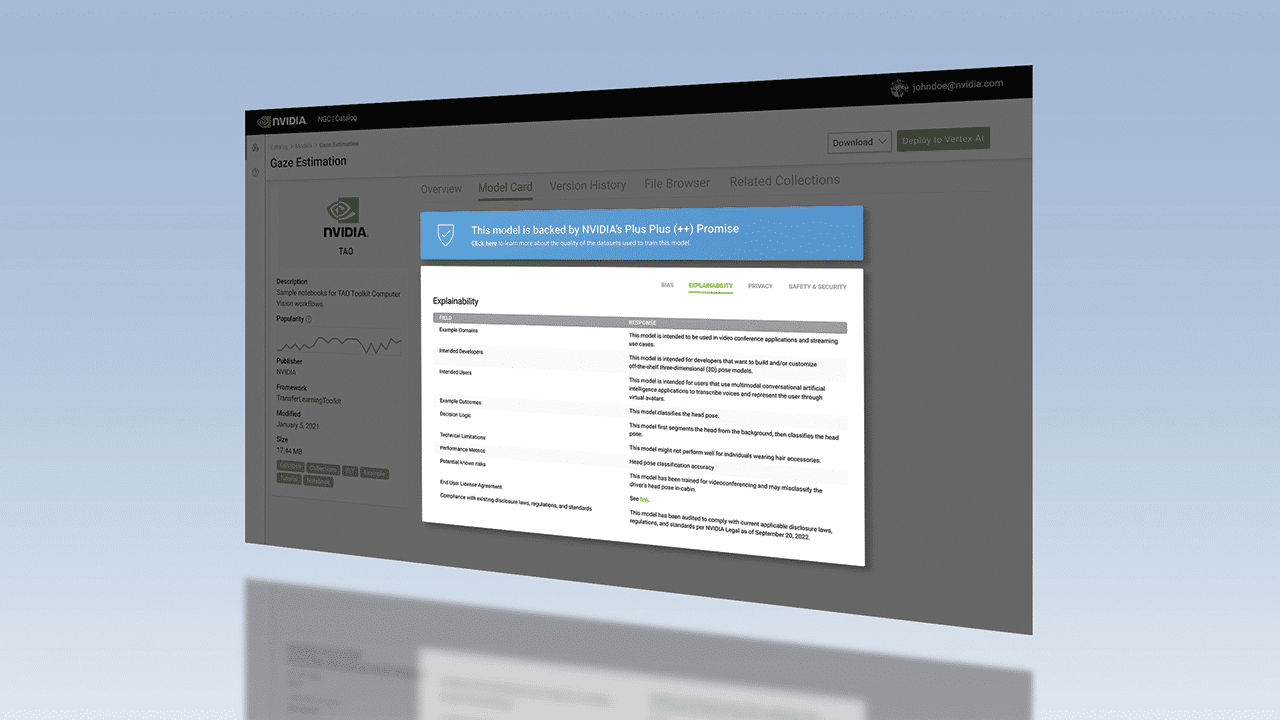

E no hub da NVIDIA para software acelerado, NGC, as placas modelo oferecem informações detalhadas sobre como cada modelo de IA funciona e foi construído. O formato Model Card ++ da NVIDIA descreve os conjuntos de dados, métodos de treinamento e medidas de desempenho usados, informações de licenciamento, bem como considerações éticas específicas.

Não Discriminação: Minimizando o Viés

Os modelos de IA são treinados por humanos, muitas vezes usando dados limitados por tamanho, escopo e diversidade. Para garantir que todas as pessoas e comunidades tenham a oportunidade de se beneficiar dessa tecnologia, é importante reduzir o viés indesejado nos sistemas de IA.

Além de seguir as diretrizes governamentais e as leis antidiscriminação, os desenvolvedores de IA confiável mitigam potenciais vieses indesejados procurando pistas e padrões que sugerem que um algoritmo é discriminatório ou envolve o uso inadequado de certas características. O viés racial e de gênero nos dados é bem conhecido, mas outras considerações incluem o viés cultural e o viés introduzido durante a rotulagem dos dados. Para reduzir o viés indesejado, os desenvolvedores podem incorporar diferentes variáveis em seus modelos.

Os conjuntos de dados sintéticos oferecem uma solução para reduzir o viés indesejado nos dados de treinamento usados para desenvolver IA para veículos autônomos e robótica. Se os dados usados para treinar carros autônomos subrepresentam cenas incomuns, como condições climáticas extremas ou acidentes de trânsito, os dados sintéticos podem ajudar a aumentar a diversidade desses conjuntos de dados para representar melhor o mundo real, ajudando a melhorar a precisão da IA.

O NVIDIA Omniverse Replicator, um framework construído sobre a plataforma NVIDIA Omniverse para criar e operar pipelines 3D e mundos virtuais, ajuda os desenvolvedores a configurar pipelines personalizados para geração de dados sintéticos. E ao integrar o Kit de Ferramentas NVIDIA TAO para aprendizado de transferência com o Innotescus, uma plataforma web para curadoria de conjuntos de dados imparciais para visão computacional, os desenvolvedores podem entender melhor os padrões e vieses do conjunto de dados para ajudar a resolver desequilíbrios estatísticos.

Saiba mais sobre IA confiável no NVIDIA.com e no Blog da NVIDIA. Para saber mais sobre como combater o preconceito indesejado na IA, assista a esta apresentação do NVIDIA GTC.