A geração de conteúdo com inteligência artificial já está integrada a ferramentas do dia a dia como Adobe e Canva, com diversas agências e estúdios incorporando a tecnologia em seus fluxos de trabalho. Os modelos de imagem agora entregam resultados fotorrealistas de forma consistente, os modelos de vídeo conseguem gerar clipes longos e coerentes, e ambos podem seguir as diretrizes criativas.

Os criadores estão cada vez mais executando esses fluxos de trabalho localmente em PCs para manter os assets sob controle direto, eliminar os custos de serviços em nuvem e a dificuldade de iteração — facilitando o aprimoramento dos resultados no ritmo exigido por projetos criativos reais.

Desde o seu lançamento, os PCs com NVIDIA RTX têm sido o sistema de escolha para executar IA criativa devido ao seu alto desempenho — reduzindo o tempo de iteração — e ao fato de os usuários poderem executar modelos neles gratuitamente, eliminando a preocupação com tokens.

Com as recentes otimizações RTX e os novos modelos open-weight apresentados na CES no início deste mês, os criativos podem trabalhar de forma mais rápida, eficiente e com muito mais controle criativo.

Como começar

Começar a usar IA generativa visual pode parecer complexo e limitador. Os geradores de IA online são fáceis de usar, mas oferecem controle limitado.

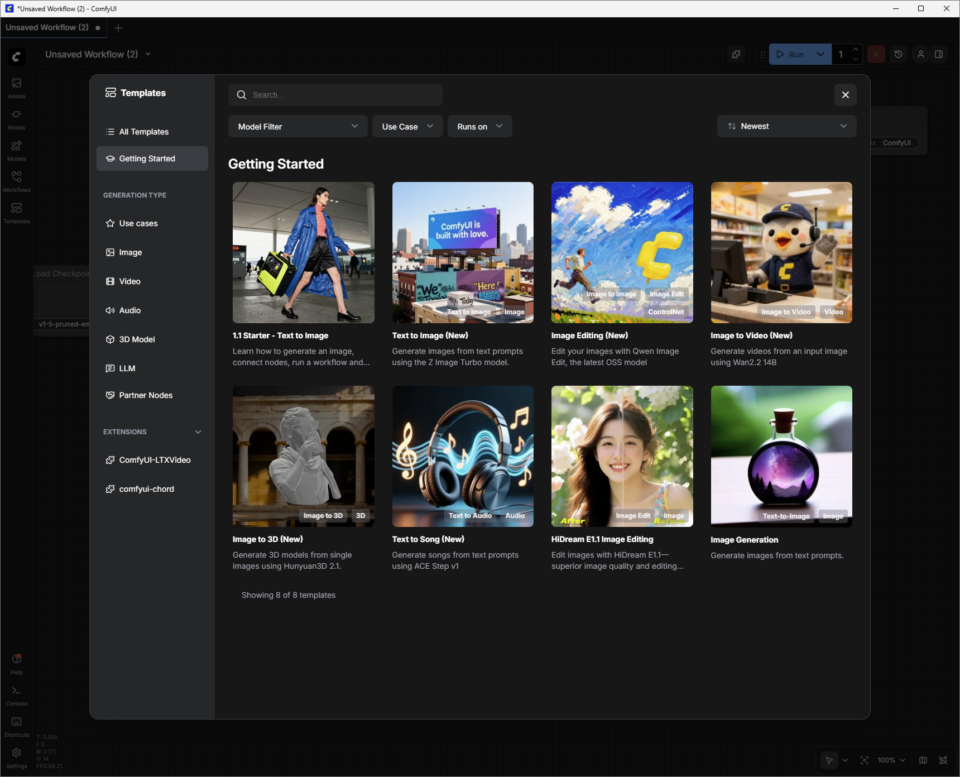

Ferramentas de código aberto da comunidade, como o ComfyUI, simplificam a configuração de fluxos de trabalho criativos avançados e são fáceis de instalar. Elas também oferecem uma maneira fácil de baixar os modelos mais recentes e melhores, como o FLUX.2 e o LTX-2, bem como os principais fluxos de trabalho da comunidade.

Veja como começar a usar IA generativa visual localmente em PCs com RTX usando o ComfyUI e modelos populares:

- Acesse comfy.org para baixar e instalar o ComfyUI para Windows.

- Inicie o ComfyUI.

- Crie uma imagem inicial usando o modelo inicial:

-

- Clique no botão “Modelos”, depois em “Primeiros passos” e escolha “1.1 Starter – Texto para imagem”.

- Conecte o “Node” do modelo ao “Node de Salvar Imagem”. Os Nodes funcionam em um pipeline para gerar conteúdo usando IA.

- Pressione o botão azul “Executar” e observe o destaque verde “Node” enquanto o PC com RTX gera sua primeira imagem.

Altere o prompt e execute o programa novamente para mergulhar mais profundamente no mundo criativo da IA generativa visual.

Leia mais abaixo sobre como explorar modelos adicionais do ComfyUI que utilizam modelos de imagem e vídeo mais avançados.

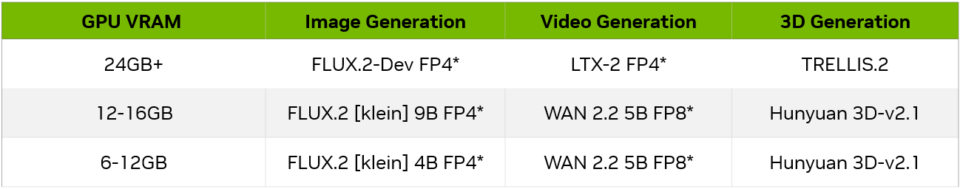

Tamanhos de modelos e GPUs

À medida que os usuários se familiarizam com o ComfyUI e os modelos que o suportam, precisarão considerar a capacidade de VRAM da GPU e se um determinado modelo atenderá a essa capacidade. Aqui estão alguns exemplos para começar, dependendo da VRAM da GPU:

Geração de imagens

Para explorar como melhorar a qualidade da geração de imagens usando o FLUX.2-Dev:

Na seção “Modelos” do ComfyUI, clique em “Todos os Modelos” e procure por “FLUX.2 Dev Text to Image”. Selecione-o e o ComfyUI carregará a coleção de Nodes conectados, ou “Fluxo de Trabalho”.

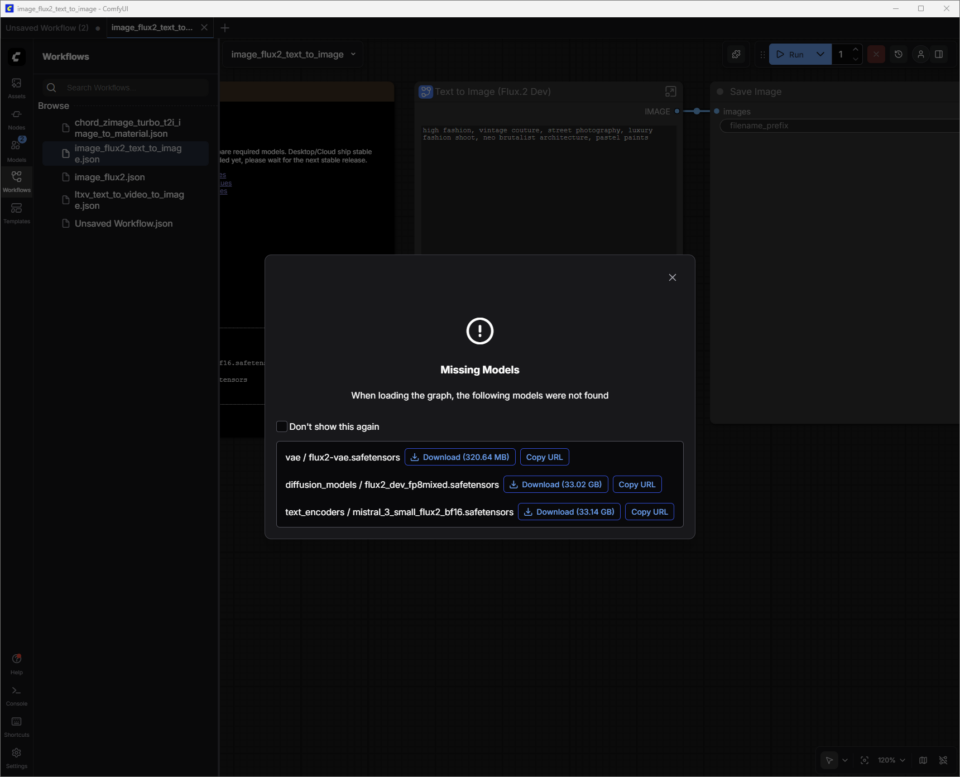

O FLUX.2-Dev possui pesos de modelo que precisam ser baixados.

Os pesos do modelo são o “conhecimento” dentro de um modelo de IA — pense neles como as sinapses em um cérebro. Quando um modelo de geração de imagens como o FLUX.2 foi treinado, ele aprendeu padrões a partir de milhões de imagens. Esses padrões são armazenados como bilhões de valores numéricos chamados “pesos”.

O ComfyUI não inclui esses pesos por padrão. Em vez disso, ele os baixa sob demanda de repositórios como o Hugging Face. Esses arquivos são grandes (FLUX.2 pode ter mais de 30 GB, dependendo da versão), por isso os sistemas precisam de espaço de armazenamento e tempo de download suficientes para obtê-los.

Uma caixa de diálogo será exibida para orientar os usuários no download dos pesos do modelo. Os arquivos de peso (nome do arquivo.safetensors) são salvos automaticamente na pasta ComfyUI correta no computador do usuário.

Salvando fluxos de trabalho:

Agora que os pesos do modelo foram baixados, o próximo passo é salvar esse modelo recém-baixado como um “Fluxo de Trabalho”.

Os usuários podem clicar no menu hambúrguer (três linhas) no canto superior esquerdo e escolher “Salvar”. O fluxo de trabalho agora está salvo na lista de “Fluxos de Trabalho” do usuário (pressione W para mostrar ou ocultar a janela). Feche a guia para sair do fluxo de trabalho sem perder nenhum progresso.

Caso a caixa de diálogo de download tenha sido fechada acidentalmente antes da conclusão do download dos pesos do modelo:

- Pressione W para abrir rapidamente a janela “Fluxos de trabalho”.

- Selecione o fluxo de trabalho e o ComfyUI o carregará. Isso também solicitará o download de quaisquer pesos de modelo ausentes.

- O ComfyUI agora está pronto para gerar uma imagem usando o FLUX.2-Dev.

Dicas rápidas para FLUX.2-Dev:

- Comece com descrições claras e concretas do assunto, cenário, estilo e atmosfera — por exemplo: “Close cinematográfico de um carro de corrida antigo na chuva, reflexos de neon no asfalto molhado, alto contraste, fotografia 35mm”. Instruções de curta a média duração — uma ou duas frases concisas — geralmente são mais fáceis de controlar do que instruções longas e narrativas, especialmente no início.

- Adicione restrições para orientar a consistência e a qualidade. Especifique aspectos como:

- Enquadramento (“plano geral” ou “retrato”)

- Nível de detalhe (“alto detalhe, foco nítido”)

- Realismo (ilustração “fotorrealista” ou “ilustração estilizada”)

- Se os resultados estiverem muito carregados, remova adjetivos em vez de adicionar mais.

- Evite estímulos negativos — limite-se a estimular o que se deseja.

Saiba mais sobre o recurso de prompts FLUX.2 neste guia da Black Forest Labs.

Locais de salvamento no disco:

Após refinar a imagem, clique com o botão direito do mouse em “Salvar Node da imagem” para abrir a imagem em um navegador ou salve-a em um novo local.

As pastas de saída padrão do ComfyUI são normalmente as seguintes, dependendo do tipo de aplicativo e do sistema operacional:

- Windows (Versão Independente/Portátil): A pasta geralmente é encontrada em C:\ComfyUI\output ou em um caminho semelhante dentro de onde o programa foi descompactado.

- Windows (Aplicativo de Área de Trabalho): O caminho geralmente está localizado dentro do diretório AppData, como: C:\Users\%username%\AppData\Local\Programs\@comfyorgcomfyui-electron\resources\ComfyUI\output

- Linux: O local de instalação padrão é ~/.config/ComfyUI.

Vídeos de incentivo

Descubra como melhorar a qualidade da geração de vídeo, usando o novo modelo LTX-2 como exemplo:

O LTX-2 da Lightrick é um modelo avançado de áudio e vídeo projetado para geração de vídeo controlável, no estilo storyboard, no ComfyUI. Depois de baixar o modelo de imagem para vídeo LTX-2 e os pesos do modelo, comece tratando o prompt como uma breve descrição de cena, em vez de um roteiro completo de filme.

Diferentemente dos dois primeiros modelos, o LTX‑2 Image to Video combina uma imagem e um texto de entrada para gerar um vídeo.

Os usuários podem pegar uma das imagens geradas no FLUX.2-Dev e adicionar um texto para dar vida a ela.

Dicas rápidas para LTX‑2:

Para obter os melhores resultados no ComfyUI, escreva um único parágrafo fluido no presente do indicativo ou use um formato simples, no estilo de roteiro, com títulos de cena (cabeçalhos), ação, nomes de personagens e diálogos. Procure usar de quatro a seis frases descritivas que abranjam todos os aspectos principais:

- Defina o enquadramento e a cena (plano geral/médio/fechamento, iluminação, cor, texturas, atmosfera).

- Descreva a ação como uma sequência clara, defina os personagens com características visíveis e linguagem corporal, e especifique os movimentos de câmera.

- Por fim, adicione áudio, como sons ambientes, música e diálogos, usando aspas.

- Ajuste o nível de detalhe à escala da cena. Por exemplo, closes exigem detalhes de textura e de personagem mais precisos do que planos gerais. Deixe claro como a câmera se relaciona com o sujeito, e não apenas para onde ela se move.

Detalhes adicionais a considerar para adicionar às perguntas:

- Linguagem de movimento de câmera: Especifique direções como “dolly lento para dentro”, “seguimento com câmera na mão”, “plano sobre o ombro”, “panorâmica lateral”, “inclinação para cima”, “aproximação”, “afastamento” ou “enquadramento estático”.

- Tipos de enquadramento: Especifique planos gerais, médios ou fechados, com iluminação adequada, pouca profundidade de campo e movimento natural.

- Ritmo: Direto para câmera lenta, time-lapses, planos prolongados, planos contínuos, congelamento de imagem ou transições perfeitas que moldam o ritmo e o tom.

- Atmosfera: Adicione detalhes como neblina, bruma, chuva, luz dourada do entardecer, reflexos e texturas de superfície ricas que deem solidez à cena.

- Estilo: Logo no início do enunciado, especifique estilos como pictórico, filme noir, filme analógico, stop-motion, bordas pixelizadas, editorial de moda ou surreal.

- Iluminação : retroiluminação direta, paletas de cores específicas, luz de contorno suave, reflexos de lente ou outros detalhes de iluminação usando uma linguagem específica.

- Emoções : Concentre-se em estimular performances individuais com expressões faciais claras e gestos sutis.

- Voz e áudio : Incentive os personagens a falar ou cantar em diferentes idiomas, com o auxílio de descrições sonoras ambientes claras.

Otimizando o uso de VRAM e a qualidade da imagem.

Como um modelo de vanguarda, o LTX-2 utiliza quantidades significativas de memória de vídeo (VRAM) para fornecer resultados de qualidade. O uso de memória aumenta conforme a resolução, a taxa de quadros, a duração ou o número de passos aumentam.

A ComfyUI e a NVIDIA colaboraram para otimizar um recurso de streaming de peso que permite aos usuários transferir partes do fluxo de trabalho para a memória do sistema caso a GPU fique sem VRAM — mas isso tem um custo em termos de desempenho.

Dependendo da GPU e do caso de uso, os usuários podem querer restringir esses fatores para garantir tempos de geração razoáveis.

O LTX-2 é um modelo incrivelmente avançado — mas, como acontece com qualquer modelo, ajustar as configurações tem um grande impacto na qualidade.

Saiba mais sobre como otimizar o uso do LTX-2 com GPUs RTX no Guia de Início Rápido para LTX-2 no ComfyUI.

Criando um fluxo de trabalho personalizado com FLUX.2-Dev e LTX-2

Os usuários podem simplificar o processo de alternar entre fluxos de trabalho do ComfyUI com o FLUX.2-Dev para gerar uma imagem, localizá-la no disco e adicioná-la como um prompt de imagem ao fluxo de trabalho de imagem para vídeo do LTX-2, combinando os modelos em um novo fluxo de trabalho:

- Abra o fluxo de trabalho salvo FLUX.2-Dev Texto para Imagem.

- Ctrl+clique com o botão esquerdo do mouse no nó FLUX.2-Dev Text to Image.

- No fluxo de trabalho de imagem para vídeo do LTX-2, cole o nó usando Ctrl+V.

- Basta posicionar o cursor sobre o ponto IMAGE do nó FLUX.2-Dev Text to Image, clicar com o botão esquerdo do mouse e arrastar até o ponto Resize Image/Mask Input. Um conector azul aparecerá.

Salve com um novo nome e insira o texto de solicitação para imagens e vídeos em um único fluxo de trabalho.

Geração 3D Avançada

Além de gerar imagens com FLUX.2 e vídeos com LTX‑2, o próximo passo é adicionar orientação 3D. O NVIDIA Blueprint para IA generativa guiada por 3D mostra como usar cenas e ativos 3D para criar fluxos de trabalho de imagem e vídeo mais controláveis e com qualidade profissional em PCs RTX — com fluxos de trabalho prontos que os usuários podem inspecionar, ajustar e expandir.

Os criadores podem exibir seus trabalhos, conectar-se com outros usuários e encontrar ajuda no subreddit Stable Diffusion e no Discord do ComfyUI.

#ParaQuemPerdeu — Os mais recentes avanços em PCs NVIDIA RTX com IA

Os anúncios da CES incluíram aceleração de geração de vídeo 4K por IA em PCs com atualizações de LTX-2 e ComfyUI. Além disso, grandes acelerações de RTX em ComfyUI, LTX-2, Llama.cpp, Ollama, Hyperlink e outros recursos desbloqueiam casos de uso de geração de vídeo, imagem e texto em PCs com IA.

FLUX.2 [klein] é um conjunto de modelos compactos e ultrarrápidos que suportam tanto a geração quanto a edição de imagens, oferecendo qualidade de imagem de última geração. Os modelos são acelerados por NVFP4 e NVFP8, aumentando a velocidade em até 2,5 vezes e permitindo que sejam executados com alto desempenho em uma ampla gama de GPUs RTX.

Com um novo “Modo de Raciocínio” ativado por padrão, o Project G-Assist ganha maior precisão e inteligência, além da capacidade de executar vários comandos simultaneamente. O G-Assist agora pode controlar configurações em monitores G-SYNC, periféricos CORSAIR e componentes de PC CORSAIR através do iCUE — abrangendo iluminação, perfis, desempenho e refrigeração.

Em breve, também haverá suporte para Elgato Stream Decks, aproximando o G-Assist de uma interface de IA unificada para ajustar e controlar praticamente qualquer sistema. Para desenvolvedores de plug-ins do G-Assist, um novo construtor de plug-ins baseado em Cursor acelera o desenvolvimento usando o ambiente de codificação ágeis do Cursor.

Conecte-se com a NVIDIA AI PC no Facebook, Instagram, TikTok e X, e mantenha-se informado assinando a newsletter sobre PCs RTX com IA.

Siga a NVIDIA Workstation no LinkedIn e no X.

Consulte o aviso referente às informações do produto de software.