O ábaco, o sextante, a régua de cálculo e o computador. Instrumentos matemáticos marcam a história do progresso humano.

Eles possibilitaram o comércio e ajudaram a navegar pelos oceanos, além de permitir uma compreensão e qualidade de vida avançadas.

A mais atual ferramenta que impulsiona a ciência e o setor é computação de AI.

Definição de Computação de AI

A computação de AI é o processo com uso intenso de matemática para calcular algoritmos de machine learning, geralmente usando sistemas e software acelerados. Ela pode extrair novos insights de grandes conjuntos de dados, aprendendo novas habilidades ao longo do caminho.

É a tecnologia mais transformadora de nossos tempos, porque vivemos em uma era centrada em dados, e a computação de AI pode encontrar padrões que nenhum humano consegue.

A American Express, por exemplo, usa computação de AI para detectar fraudes em bilhões de transações anuais com cartão de crédito. Os médicos usam-na para localizar tumores, identificando pequenas anomalias em montanhas de imagens médicas.

Três Etapas para Computação de AI

Antes de abordar os muitos casos de uso da computação de AI, vamos explorar como ela funciona.

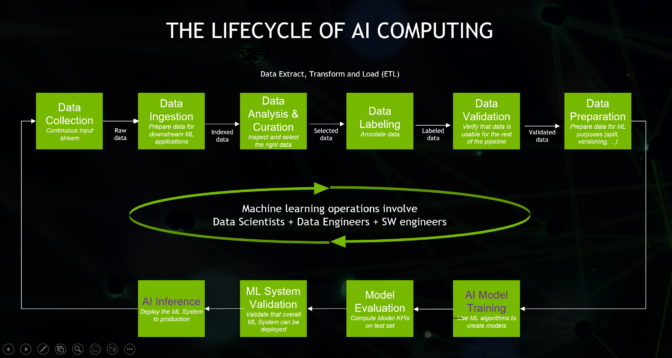

Em primeiro lugar, os usuários, muitas vezes, cientistas de dados, selecionam e preparam conjuntos de dados, um estágio chamado de extração/transformação/carregamento ou ETL. Agora, esse trabalho pode ser acelerado em GPUs NVIDIA com o Apache Spark 3.0, um dos engines de código aberto mais populares para minerar big data.

Em segundo lugar, os cientistas de dados escolhem ou projetam modelos de AI que melhor se adaptam a suas aplicações.

Algumas empresas projetam e treinam seus próprios modelos do zero porque são pioneiras em um novo campo ou buscam uma vantagem competitiva. Esse processo requer alguma experiência e, potencialmente, um supercomputador de AI, os quais são recursos que a NVIDIA oferece.

Muitas empresas escolhem modelos pré-treinados de AI que podem personalizar conforme necessário para suas aplicações. A NVIDIA oferece dezenas de modelos e ferramentas pré-treinados para personalizá-los no NGC, um portal para software, serviços e suporte.

Em terceiro lugar, as empresas analisam seus dados por meio de seus modelos. Essa etapa-chave, chamada inferência, é onde a AI fornece insights úteis.

O processo de três etapas envolve trabalho duro, mas há ajuda disponível, para que todos possam usar computação de AI.

Por exemplo, o Kit de Ferramentas NVIDIA TAO pode dividir as três etapas em uma usando a aprendizagem por transferência, uma maneira de personalizar um modelo de AI existente para uma nova aplicação sem precisar de um grande conjunto de dados. Além disso, o NVIDIA LaunchPad oferece aos usuários treinamento prático na implantação de modelos para uma ampla variedade de casos de uso.

Dentro de um Modelo de AI

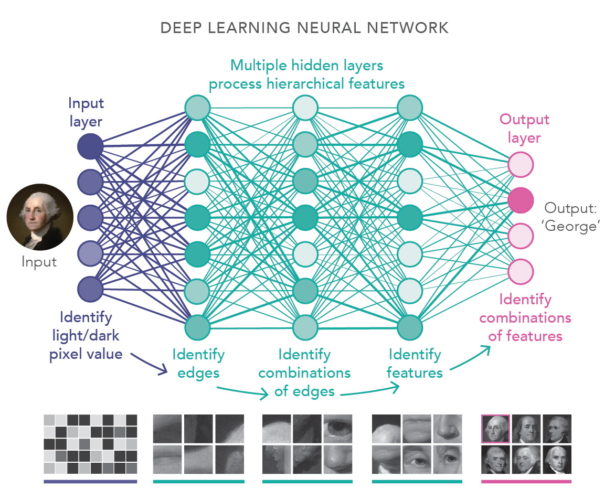

Modelos de AI são chamados de redes neurais porque são inspirados nas conexões que lembram redes no cérebro humano.

Se você os dividir em um desses modelos de AI, poderá parecer uma lasanha matemática, composta de camadas de equações de álgebra linear. Uma das formas mais populares de AI é chamada de deep learning porque usa muitas camadas.

Se você aumentar o zoom, verá que cada camada é composta de pilhas de equações. Cada uma representa a probabilidade de que um dado esteja relacionado a outro.

A computação de AI multiplica junto todas as pilhas de equações em cada camada para encontrar padrões. É um trabalho enorme que requer processadores altamente paralelos compartilhando enormes quantidades de dados em redes de computadores rápidas.

A Computação de GPU Encontra a AI

As GPUs são os engines de fato da computação de AI.

A NVIDIA estreou a primeira GPU em 1999 para renderizar imagens 3D para videogames, um trabalho que exigia cálculos altamente paralelos.

Logo depois, a computação de GPU se espalhou para uso em servidores gráficos para filmes de sucesso. Cientistas e pesquisadores integraram GPUs aos maiores supercomputadores do mundo para estudar tudo, desde a química de moléculas minúsculas até a astrofísica de galáxias distantes.

Quando a computação de AI surgiu há mais de uma década, os pesquisadores rapidamente adotaram a plataforma programável da NVIDIA para o processamento paralelo. O vídeo abaixo celebra esta breve história da GPU.

A História da Computação de AI

A ideia da inteligência artificial remonta, pelo menos, a de Alan Turing, o matemático britânico que ajudou a decifrar mensagens codificadas durante a Segunda Guerra Mundial.

“O que queremos é uma máquina que possa aprender com a experiência”, disse Turing em uma palestra em 1947 em Londres.

Reconhecendo suas percepções, a NVIDIA nomeou uma de suas arquiteturas de computação em homenagem a ele.

A visão de Turing tornou-se realidade em 2012, quando pesquisadores desenvolveram modelos de AI que conseguiam reconhecer imagens com mais rapidez e precisão do que os humanos. Os resultados da competição da ImageNet também aceleraram muito o progresso da visão computacional.

Hoje, empresas como a Landing AI, fundada pelo especialista em machine learning, Andrew Ng, estão aplicando AI e visão computacional para tornar a manufatura mais eficiente. E a AI está levando a visão humana aos esportes, cidades inteligentes e muito mais.

Computação de AI Inicia a AI Conversacional

A computação de AI gerou grandes avanços no processamento de linguagem natural após a invenção do modelo transformer em 2017. Ela estreou uma técnica de machine learning chamada “atenção” que pode capturar contexto em dados sequenciais, como texto e fala.

Hoje, a AI conversacional está por toda a parte. Ela analisa frases que os usuários digitam em caixas de pesquisa. Lê mensagens de texto quando você está dirigindo e permite que você dite respostas.

Esses grandes modelos de linguagem também estão encontrando aplicações na descoberta de medicamentos, tradução, chatbots, desenvolvimento de software, automação de call center e muito mais.

AI + Gráficos Criam Mundos 3D

Os usuários de muitas áreas, muitas vezes, inesperadas, estão sentindo o poder da computação de AI.

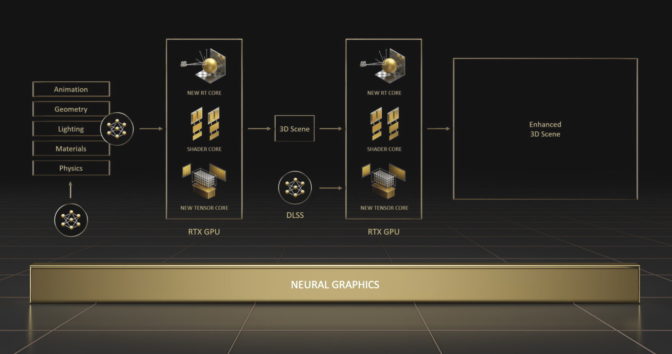

Os videogames mais atuais atingem novos níveis de realismo graças ao ray tracing em tempo real e ao NVIDIA DLSS, que usa AI para oferecer um gameplay extremamente fluido na plataforma GeForce RTX.

E isso é só o começo. O campo emergente dos gráficos neurais acelerará a criação de mundos virtuais para preencher o metaverso, a evolução 3D da internet.

Para iniciar esse trabalho, a NVIDIA lançou várias ferramentas de gráficos neurais em agosto.

Casos de Uso para Computação de AI

Carros, Fábricas e Depósitos

As fabricantes de carros estão adotando a computação de AI para proporcionar uma experiência de condução mais fluida e segura e oferecer recursos inteligentes de infotainment para os passageiros.

A Mercedes-Benz está trabalhando com a NVIDIA para desenvolver veículos definidos por software. Suas próximas frotas oferecerão recursos inteligentes e automatizados de condução com a tecnologia de um computador centralizado NVIDIA DRIVE Orin. Os sistemas serão testados e validados no data center usando o software DRIVE Sim, desenvolvido com o NVIDIA Omniverse, para garantir que possam lidar com todos os tipos de cenários com segurança.

Na CES, a montadora anunciou que também usará o Omniverse para projetar e planejar instalações de manufatura e montagem em suas unidades em todo o mundo.

O BMW Group também está entre as muitas empresas que criam digital twins de fábricas habilitados para AI no NVIDIA Omniverse, tornando as fábricas mais eficientes. É uma abordagem também adotada por gigantes de produtos do consumo, como a PepsiCo, para seus centros logísticos, conforme mostrado no vídeo abaixo.

Dentro de fábricas e depósitos os robôs autônomos aumentam ainda mais a eficiência na manufatura e na logística. Muitos contam com a tecnologia da plataforma de AI no edge NVIDIA Jetson e são treinados com AI em simulações e digital twins usando o NVIDIA Isaac Sim.

Em 2022, até mesmo tratores e cortadores de grama tornaram-se autônomos com a AI.

Em dezembro, a Monarch Tractor, uma startup com sede em Livermore, Califórnia, lançou um veículo elétrico com tecnologia fornecida por AI para levar automação à agricultura. Em maio, a Scythe, com sede em Boulder, Colorado, estreou sua M.52 (abaixo), um cortador de grama elétrico autônomo com oito câmeras e mais de uma dúzia de sensores.

Protegendo Redes, Sequenciando Genes

O número e a variedade de casos de uso para computação de AI são impressionantes.

O software de cibersegurança detecta phishing e outras ameaças de rede mais rapidamente com técnicas baseadas em AI, como impressões digitais.

Na área da saúde, os pesquisadores quebraram um recorde em janeiro de 2022, sequenciando um genoma inteiro em menos de oito horas graças à computação de AI. Seu trabalho (descrito no vídeo abaixo) pode levar a curas para doenças genéticas raras.

A computação de AI funciona em bancos, lojas de varejo e agências dos correios. Também é usada em redes de telecomunicações, transporte e energia.

O vídeo abaixo mostra, por exemplo, como a Siemens Gamesa está usando modelos de AI para simular parques eólicos e impulsionar a produção de energia.

À medida que as técnicas de computação de AI de hoje encontram novas aplicações, os pesquisadores estão inventando métodos mais novos e poderosos.

Outra classe poderosa de redes neurais, os modelos de difusão, tornou-se popular em 2022 porque eles poderiam transformar descrições de textos em imagens fascinantes. Os pesquisadores esperam que esses modelos sejam aplicados a muitos usos, ampliando ainda mais o horizonte da computação de AI.