Os data centers tradicionais na nuvem têm servido como base da infraestrutura de computação por mais de uma década, atendendo a uma gama diversificada de usuários e aplicações. No entanto, os data centers evoluíram nos últimos anos para acompanhar os avanços na tecnologia e a crescente demanda por computação orientada por IA. Este post explora o papel fundamental que a rede desempenha na formação do futuro dos data centers e na facilitação da era da IA.

Data Centers Especializados: Fábricas de IA e Nuvens de IA

Duas classes distintas de data centers estão surgindo atualmente: fábricas de IA e nuvens de IA. Ambos são adaptados para atender às demandas exclusivas de cargas de trabalho de IA, que são caracterizadas por sua dependência de computação acelerada.

As fábricas de IA são projetadas para lidar com fluxos de trabalho massivos e em grande escala e o desenvolvimento de grandes modelos de linguagem (LLMs) e outros modelos fundamentais de IA. Esses modelos são a base com os quais os sistemas de IA mais avançados são construídos. Para permitir o dimensionamento contínuo e a utilização eficiente de recursos em milhares de GPUs, uma rede robusta e de alto desempenho é imprescindível.

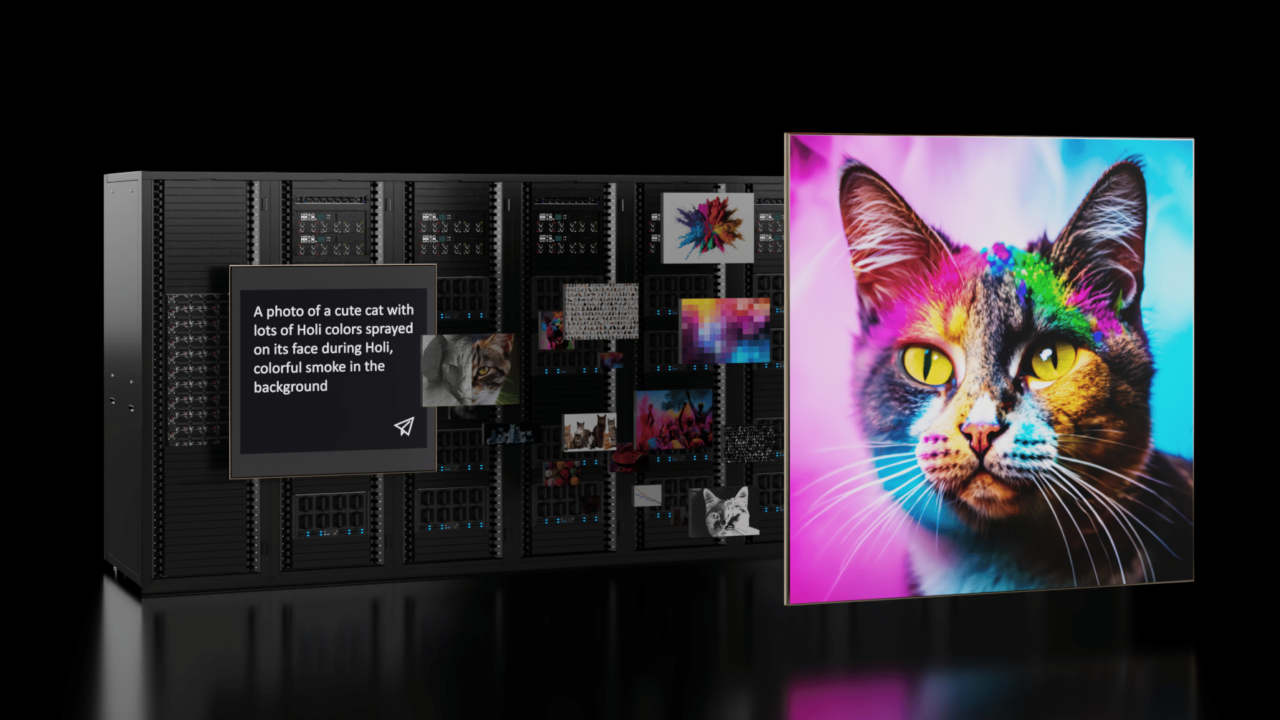

As nuvens de IA ampliam os recursos da infraestrutura de nuvem tradicional para oferecer suporte a aplicações de IA generativa em larga escala. A IA generativa vai além dos sistemas convencionais de IA, criando novos conteúdos, como imagens, texto e áudio, com base nos dados em que foi treinada. Gerenciar nuvens de IA com milhares de usuários requer ferramentas de gerenciamento avançadas e uma infraestrutura de rede que possa lidar com diversas cargas de trabalho de forma eficiente.

IA e Computação Distribuída

As cargas de trabalho de IA são computacionalmente intensivas, particularmente aquelas que envolvem grandes e complexos modelos como ChatGPT e BERT. Para agilizar o treinamento de modelos e o processamento de vastos conjuntos de dados, os profissionais de IA se voltaram para a computação distribuída. Essa abordagem envolve a distribuição da carga de trabalho entre vários servidores ou nós interconectados conectados por meio de uma rede de alta velocidade e baixa latência.

A computação distribuída é fundamental para o sucesso da IA, e a escalabilidade e a capacidade da rede de lidar com um número crescente de nós é crucial. Uma rede altamente escalável permite que os pesquisadores de IA aproveitem mais recursos computacionais, levando a um desempenho mais rápido e aprimorado.

Ao elaborar a arquitetura de rede para data centers de IA, é essencial criar uma solução integrada com computação distribuída como prioridade. Os arquitetos de data centers devem considerar cuidadosamente o design de rede e adaptar as soluções às demandas exclusivas das cargas de trabalho de IA que planejam implantar.

O NVIDIA Quantum-2 InfiniBand e o NVIDIA Spectrum-X são duas plataformas de rede especificamente projetadas e otimizadas para atender aos desafios de rede do data center de IA, cada uma com seus próprios recursos e inovações exclusivos.

InfiniBand Impulsiona o Desempenho da IA

A tecnologia InfiniBand tem sido uma força motriz por trás de implantações de supercomputação em larga escala para computação científica distribuída complexa. Tornou-se a rede de fato para fábricas de IA. Com latências ultrabaixas, a InfiniBand tornou-se um pilar para acelerar as principais aplicações de computação de alto desempenho (HPC) e IA de hoje. Muitos recursos de rede necessários para sistemas de IA eficientes são nativos da plataforma NVIDIA Quantum-2 InfiniBand.

A computação em rede, impulsionada pela InfiniBand, integra mecanismos de computação baseados em hardware à rede. Isso descarrega operações complexas em escala e utiliza o NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP), um mecanismo de agregação na rede. O SHARP oferece suporte a várias operações coletivas simultâneas, dobrando a largura de banda de dados para reduções de dados e aprimoramentos de desempenho.

O roteamento adaptável InfiniBand espalha o tráfego de forma otimizada, reduzindo o congestionamento e aprimorando a utilização de recursos. Dirigido por um Gerenciador de Sub-redes, o InfiniBand seleciona rotas sem congestionamento com base nas condições da rede, maximizando a eficiência sem comprometer a ordem de chegada dos pacotes.

A Arquitetura de Controle de Congestionamento InfiniBand garante largura de banda e latência determinísticas. Ele usa um processo de três estágios para gerenciar o congestionamento, evitando gargalos de desempenho em cargas de trabalho de IA.

Essas otimizações inerentes capacitam a InfiniBand a atender às demandas das aplicações de IA, impulsionando desempenho e eficiência superiores.

Navegando na Ethernet para Implantações de IA

A implantação de redes Ethernet para uma infraestrutura de IA requer atender às necessidades específicas do protocolo Ethernet. Ao longo do tempo, a Ethernet incorporou um conjunto de recursos expansivo, abrangente e (às vezes) complexo que atende a uma enorme variedade de cenários de rede.

Como tal, Ethernet pronta para uso ou tradicional não é explicitamente projetada para alto desempenho. As nuvens de IA que usam Ethernet tradicional para sua malha de computação só podem alcançar uma fração do desempenho que alcançariam com uma rede otimizada.

Em ambientes multilocatários onde vários trabalhos de IA são executados simultaneamente, o isolamento de desempenho é fundamental para evitar uma maior degradação do desempenho. Se houver uma falha de link, a malha Ethernet tradicional pode fazer com que o desempenho de IA do cluster caia pela metade. Isso ocorre porque a Ethernet tradicional foi otimizada principalmente para workflows corporativos diários e não foi projetada para atender às demandas de aplicações de IA de alto desempenho que dependem da NVIDIA Collective Communications Library (NCCL).

Esses problemas de desempenho são devidos a fatores inerentes à Ethernet tradicional, incluindo:

- Latências de switch mais altas, comuns em ASICs de commodities

- Arquitetura de switch de buffer dividido, o que pode levar a injustiças na largura de banda

- Balanceamento de carga subotimizado para os grandes fluxos gerados pelas cargas de trabalho de IA

- Isolamento de desempenho e problemas de vizinhos barulhentos

A plataforma de rede Spectrum-X resolve esses problemas e muito mais. O Spectrum-X baseia-se no protocolo Ethernet padrão com extensões RDMA sobre Ethernet convergente (RoCE), melhorando o desempenho da IA. Essas extensões aproveitam as práticas recomendadas nativas da InfiniBand e trazem inovações como roteamento adaptável e controle de congestionamento para a Ethernet.

O Spectrum-X é a única plataforma Ethernet que oferece a alta largura de banda efetiva e o isolamento de desempenho necessários para nuvens de IA generativa multilocatária, habilitadas devido ao Spectrum-4 trabalhar em estreita coordenação com as DPUs NVIDIA BlueField-3.

Resumo

A era da IA chegou e a rede é a pedra angular de seu sucesso. Para abraçar totalmente o potencial da IA, os arquitetos de data center devem considerar cuidadosamente o design de rede e adaptar esses projetos às demandas exclusivas das cargas de trabalho de IA. Abordar as considerações de rede é fundamental para desbloquear todo o potencial das tecnologias de IA e impulsionar a inovação no setor de data centers.

O NVIDIA Quantum InfiniBand é a escolha ideal para fábricas de IA, graças às suas latências ultrabaixas, desempenho escalável e conjuntos de recursos avançados. O NVIDIA Spectrum-X, com suas inovações tecnológicas para IA, oferece uma solução inovadora para empresas que criam nuvens de IA baseadas em Ethernet.

Para saber mais sobre as demandas de desempenho de IA e os requisitos de rede, consulte o artigo técnico Networking for the Era of AI.