A IA generativa está transformando softwares de PC em experiências inovadoras — de humanos digitais a assistentes de escrita, agentes inteligentes e ferramentas criativas.

Os PCs NVIDIA RTX com IA estão impulsionando essa transformação com tecnologia que torna mais simples começar a experimentar IA generativa e desbloquear maior desempenho no Windows 11.

O NVIDIA TensorRT foi reinventado para PCs RTX com IA, combinando o desempenho líder do setor do TensorRT com construção de mecanismos just-in-time no dispositivo e um tamanho de pacote 8 vezes menor para implantação perfeita de IA em mais de 100 milhões de PCs RTX com IA.

Anunciado no Microsoft Build, o TensorRT para RTX tem suporte nativo do Windows ML — uma nova pilha de inferência que fornece aos desenvolvedores de aplicativos ampla compatibilidade de hardware e desempenho de última geração.

Para desenvolvedores que buscam recursos de IA prontos para integração, os kits de desenvolvimento de software (SDKs) da NVIDIA oferecem uma ampla gama de opções, desde NVIDIA DLSS até aprimoramentos multimídia como o NVIDIA RTX Video. Este mês, os principais aplicativos de software da Autodesk, Bilibili, Chaos, LM Studio e Topaz Labs estão lançando atualizações para desbloquear recursos e aceleração de IA com RTX.

Entusiastas e desenvolvedores de IA podem começar a usar IA facilmente usando o NVIDIA NIM — modelos de IA pré-empacotados e otimizados que podem ser executados em aplicativos populares como AnythingLLM, Microsoft VS Code e ComfyUI. Com lançamento previsto para esta semana, o modelo de geração de imagens FLUX.1-schnell estará disponível como um microsserviço NIM, e o popular microsserviço FLUX.1-dev NIM foi atualizado para oferecer suporte a mais GPUs RTX.

Quem busca uma maneira simples e sem código de se aprofundar no desenvolvimento de IA pode aproveitar o Project G-Assist — o assistente de IA para PCs RTX no NVIDIA App — para criar plug-ins que controlam aplicativos e periféricos de PC usando IA de linguagem natural. Novos plug-ins da comunidade já estão disponíveis, incluindo a busca na web do Google Gemini, Spotify, Twitch, IFTTT e SignalRGB.

Inferência de IA acelerada com TensorRT para RTX

O conjunto de software de IA para PC atual exige que os desenvolvedores comprometam o desempenho ou invistam em otimizações personalizadas para hardware específico.

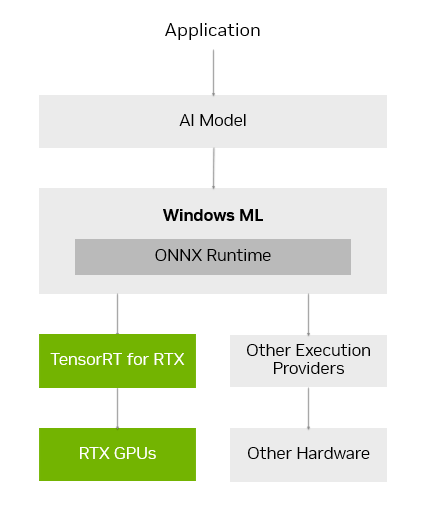

O Windows ML foi criado para solucionar esses desafios. Ele é alimentado pelo ONNX Runtime e se conecta perfeitamente a uma camada de execução de IA otimizada, fornecida e mantida por cada fabricante de hardware.

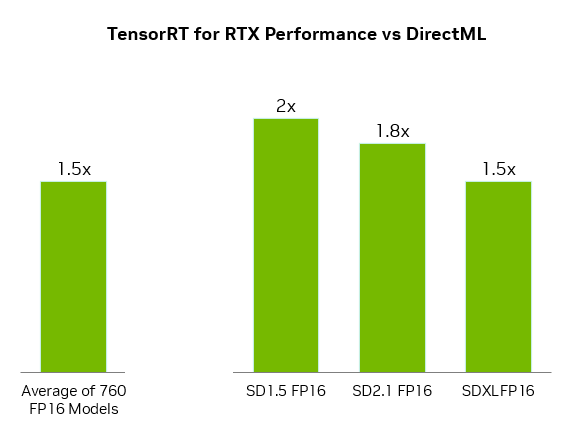

Para GPUs GeForce RTX, o Windows ML usa automaticamente a biblioteca de inferência TensorRT para RTX para alto desempenho e implantação rápida. Comparado ao DirectML, o TensorRT oferece desempenho mais de 50% mais rápido para cargas de trabalho de IA em PCs.

O Windows ML também oferece benefícios de qualidade de vida para desenvolvedores. Ele pode selecionar automaticamente o hardware certo — GPU, CPU ou NPU — para executar cada recurso de IA e baixar o provedor de execução para esse hardware, eliminando a necessidade de empacotar esses arquivos no aplicativo. Isso permite que as otimizações de desempenho mais recentes do TensorRT sejam entregues aos usuários assim que estiverem prontos.

O TensorRT, uma biblioteca originalmente desenvolvida para data centers, foi redesenhado para PCs RTX com IA. Em vez de pré-gerar mecanismos TensorRT e empacotá-los com o aplicativo, o TensorRT para RTX utiliza a construção de mecanismos just-in-time no dispositivo para otimizar a execução do modelo de IA para a GPU RTX específica do usuário em poucos segundos. E o empacotamento da biblioteca foi simplificado, reduzindo significativamente o tamanho do arquivo em 8x.

O TensorRT para RTX está disponível para desenvolvedores por meio da prévia do Windows ML hoje e estará disponível como um SDK independente no NVIDIA Developer em junho.

Os desenvolvedores podem aprender mais no blog de lançamento do TensorRT para RTX ou no blog do Windows ML da Microsoft.

Expandindo o ecossistema de IA em PCs com Windows 11

Desenvolvedores que buscam adicionar recursos de IA ou aprimorar o desempenho de aplicativos podem aproveitar uma ampla gama de SDKs da NVIDIA. Entre eles, estão NVIDIA CUDA e TensorRT para aceleração de GPU; NVIDIA DLSS e Optix para gráficos 3D; NVIDIA RTX Video e Maxine para multimídia; e NVIDIA Riva e ACE para IA Generativa.

Os principais aplicativos estão lançando atualizações este mês para habilitar recursos exclusivos usando esses SDKs NVIDIA, incluindo:

- LM Studio, que lançou uma atualização do seu aplicativo para atualizar para a versão mais recente do CUDA, aumentando o desempenho em mais de 30%.

- Topaz Labs, que está lançando um modelo de vídeo de IA generativo para melhorar a qualidade do vídeo, acelerado por CUDA.

- Chaos Enscape e Autodesk VRED, que estão adicionando DLSS 4 para desempenho mais rápido e melhor qualidade de imagem.

- Bilibili, que está integrando recursos do NVIDIA Broadcast, como o Virtual Background, para melhorar a qualidade das transmissões ao vivo.

A NVIDIA espera continuar trabalhando com a Microsoft e os principais desenvolvedores de aplicativos de IA para ajudá-los a acelerar seus recursos de IA em máquinas com tecnologia RTX por meio da integração do Windows ML e do TensorRT.

IA local simplificada com microsserviços NIM e projetos de IA

Começar a desenvolver IA em PCs pode ser desafiador. Desenvolvedores e entusiastas de IA precisam selecionar entre mais de 1,2 milhão de modelos de IA no Hugging Face, quantizá-los em um formato que rode bem no PC, encontrar e instalar todas as dependências para executá-los e muito mais.

O NVIDIA NIM facilita o início, fornecendo uma lista selecionada de modelos de IA, pré-empacotados com todos os arquivos necessários para executá-los e otimizados para atingir o desempenho máximo em GPUs RTX. E, como são conteinerizados, o mesmo microsserviço NIM pode ser executado perfeitamente em PCs ou na nuvem.

Os microsserviços NVIDIA NIM estão disponíveis para download em build.nvidia.com ou nos principais aplicativos de IA, como Anything LLM, ComfyUI e AI Toolkit for Visual Studio Code.

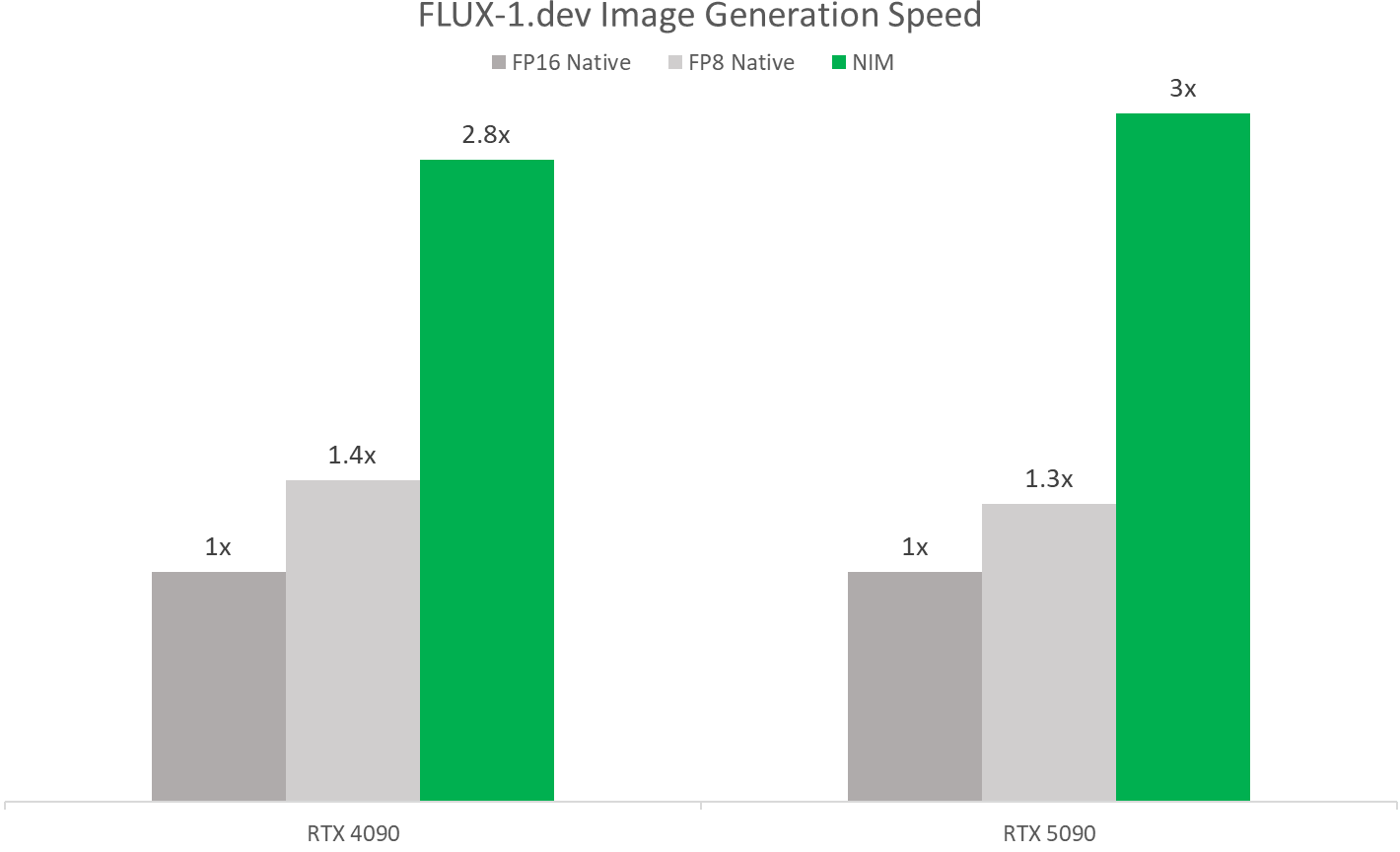

Durante a COMPUTEX, a NVIDIA lançará o microsserviço FLUX.1-schnell NIM — um modelo de geração de imagens do Black Forest Labs para geração rápida de imagens — e atualizará o microsserviço FLUX.1-dev NIM para adicionar compatibilidade com uma ampla gama de GPUs GeForce RTX séries 50 e 40.

Esses microsserviços NIM permitem um desempenho mais rápido com TensorRT e modelos quantizados. Em GPUs NVIDIA Blackwell, eles rodam mais de duas vezes mais rápido do que nativamente, graças às otimizações de FP4 e RTX.

Os desenvolvedores de IA também podem iniciar seu trabalho com o NVIDIA AI Blueprints — exemplos de fluxos de trabalho e projetos usando microsserviços NIM.

No mês passado, a NVIDIA lançou o NVIDIA AI Blueprint para IA generativa guiada em 3D , uma maneira poderosa de controlar a composição e os ângulos de câmera de imagens geradas usando uma cena 3D como referência. Os desenvolvedores podem modificar o blueprint de código aberto de acordo com suas necessidades ou expandi-lo com funcionalidades adicionais.

Novos plug-ins e projetos de amostra do Project G-Assist já disponíveis

A NVIDIA lançou recentemente o Projeto G-Assist como um assistente de IA experimental integrado ao aplicativo NVIDIA. O G-Assist permite que os usuários controlem seus sistemas GeForce RTX usando comandos simples de voz e texto, oferecendo uma interface mais conveniente em comparação com os controles manuais espalhados por diversos painéis de controle antigos.

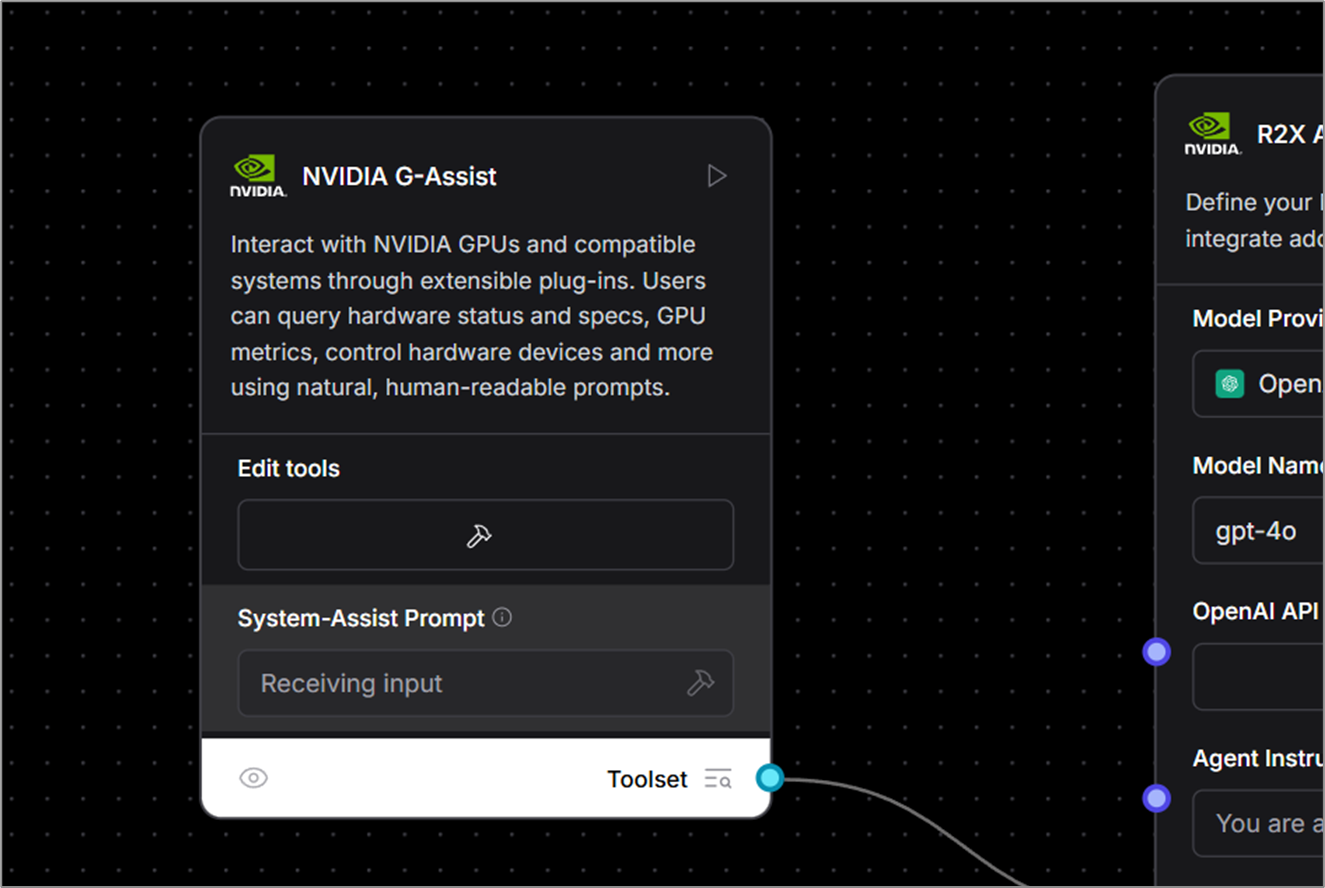

Os desenvolvedores também podem usar o Project G-Assist para criar facilmente plug-ins, testar casos de uso do assistente e publicá-los por meio do Discord e do GitHub da NVIDIA.

O Project G-Assist Plug-in Builder — um aplicativo baseado em ChatGPT que permite desenvolvimento sem código ou com pouco código usando comandos em linguagem natural — facilita a criação de plug-ins. Esses complementos leves e desenvolvidos pela comunidade usam definições JSON simples e lógica Python.

Novos exemplos de plug-ins de código aberto já estão disponíveis no GitHub, apresentando diversas maneiras pelas quais a IA no dispositivo pode aprimorar fluxos de trabalho em PCs e jogos. Entre eles estão:

- Gemini: O plug-in Gemini existente que usa o modelo de linguagem grande e gratuito baseado em nuvem do Google foi atualizado para incluir recursos de pesquisa na web em tempo real.

- IFTTT: um plug-in que permite aos usuários criar automações em centenas de endpoints compatíveis para acionar rotinas de IoT — como ajustar luzes de ambiente ou cortinas inteligentes, ou enviar as últimas notícias sobre jogos para um dispositivo móvel.

- Discord: Um plug-in que permite aos usuários compartilhar facilmente destaques de jogos ou mensagens diretamente nos servidores do Discord sem interromper a jogabilidade.

Explore o repositório do GitHub para mais exemplos — incluindo controle de música sem as mãos via Spotify, verificações de status de transmissão ao vivo com o Twitch e muito mais.

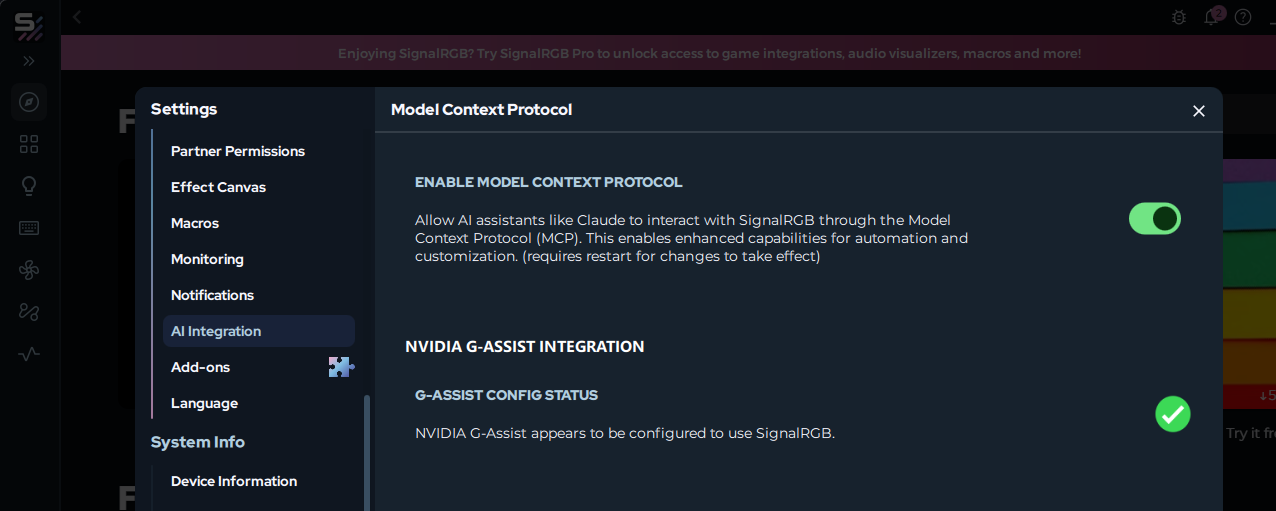

As empresas estão adotando a IA como a nova interface para PC. Por exemplo, a SignalRGB está desenvolvendo um plug-in G-Assist que permite o controle unificado da iluminação entre diversos fabricantes. Em breve, os usuários poderão instalar esse plug-in diretamente do aplicativo SignalRGB.

A partir desta semana, a comunidade de IA também poderá usar o G-Assist como um componente personalizado no Langflow, permitindo que os usuários integrem recursos de chamada de função em fluxos de trabalho de baixo código ou sem código, aplicativos de IA e fluxos de agentes.

Entusiastas interessados em desenvolver e experimentar plug-ins do Projeto G-Assist estão convidados a participar do canal NVIDIA Developer Discord para colaborar, compartilhar criações e obter suporte.

A cada semana, a série de blogs RTX AI Garage apresenta inovações e conteúdo de IA voltados para a comunidade para aqueles que desejam aprender mais sobre microsserviços NIM e Blueprints de IA, além de criar agentes de IA, fluxos de trabalho criativos, humanos digitais, aplicativos de produtividade e muito mais em PCs e workstations de IA.

Veja o aviso sobre informações do produto de software.