A computação acelerada , uma capacidade antes restrita a computadores de alto desempenho em laboratórios de pesquisa do governo, tornou-se popular.

Bancos, montadoras, fábricas, hospitais, varejistas e outros estão adotando supercomputadores de AI para lidar com as crescentes montanhas de dados que precisam processar e entender.

Esses sistemas poderosos e eficientes são superestradas da computação. Eles carregam dados e cálculos em caminhos paralelos em uma jornada relâmpago para resultados acionáveis.

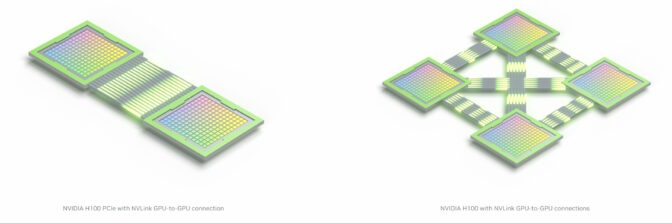

Processadores GPU e CPU são os recursos ao longo do caminho, e suas rampas de acesso são interconexões rápidas. O padrão de excelência em interconexões para computação acelerada é o NVLink .

Então, o que é NVLink?

NVLink é uma conexão de alta velocidade para GPUs e CPUs formada por um protocolo de software robusto, geralmente montado em vários pares de fios impressos em uma placa de computador. Ele permite que os processadores enviem e recebam dados de pools compartilhados de memória na velocidade da luz.

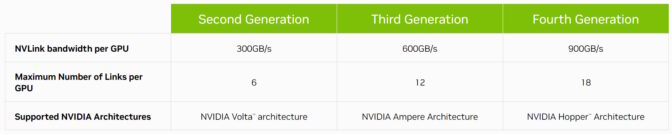

Agora em sua quarta geração, o NVLink conecta host e processadores acelerados a taxas de até 900 gigabytes por segundo (GB/s).

Isso é mais de 7x a largura de banda do PCIe Gen 5, a interconexão usada em servidores x86 convencionais. E o NVLink ostenta 5x a eficiência energética do PCIe Gen 5, graças às transferências de dados que consomem apenas 1,3 picojoules por bit.

A história do link NV

Introduzido pela primeira vez como uma interconexão de GPU com a GPU NVIDIA P100, o NVLink avançou em sincronia com cada nova arquitetura de GPU NVIDIA.

Em 2018, o NVLink atingiu o destaque na computação de alto desempenho quando estreou conectando GPUs e CPUs em dois dos supercomputadores mais poderosos do mundo, Summit e Sierra .

Os sistemas, instalados nos Laboratórios Nacionais Oak Ridge e Lawrence Livermore, estão expandindo os limites da ciência em áreas como descoberta de medicamentos , previsão de desastres naturais e muito mais.

A largura de banda dobra, depois cresce novamente

Em 2020, o NVLink de terceira geração dobrou sua largura de banda máxima por GPU para 600 GB/s, incluindo uma dúzia de interconexões em cada GPU NVIDIA A100 Tensor Core .

O A100 capacita supercomputadores de IA em data centers corporativos, serviços de computação em nuvem e laboratórios de HPC em todo o mundo.

Hoje, 18 interconexões NVLink de quarta geração estão incorporadas em uma única GPU NVIDIA H100 Tensor Core . E a tecnologia assumiu um novo papel estratégico que possibilitará as CPUs e aceleradores mais avançados do planeta.

Link de chip a chip

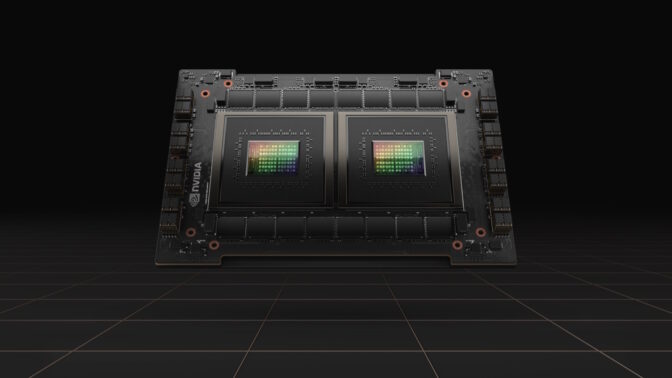

NVIDIA NVLink-C2C é uma versão da interconexão em nível de placa para unir dois processadores dentro de um único pacote, criando um superchip. Por exemplo, ele conecta dois chips de CPU para fornecer 144 núcleos Arm Neoverse V2 no NVIDIA Grace CPU Superchip, um processador criado para oferecer desempenho com eficiência energética para usuários de cloud, empresas e HPC.

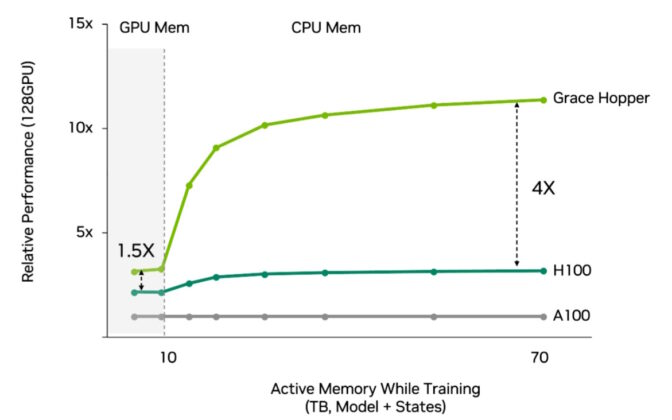

NVIDIA NVLink-C2C também se une a uma CPU Grace e uma GPU Hopper para criar o Grace Hopper Superchip . Ele reúne computação acelerada para os trabalhos de HPC e AI mais difíceis do mundo em um único chip.

O Alps , um supercomputador de AI planejado para o Swiss National Computing Center, estará entre os primeiros a usar o Grace Hopper. Quando estiver online no final deste ano, o sistema de alto desempenho funcionará em grandes problemas científicos em campos da astrofísica à química quântica.

Grace e Grace Hopper também são ótimos para trazer eficiência energética para workloads de computação no cloud exigentes.

Por exemplo, Grace Hopper é um processador ideal para sistemas de recomendação . Esses motores econômicos da internet precisam de acesso rápido e eficiente a muitos dados para atender trilhões de resultados a bilhões de usuários diariamente.

Além disso, o NVLink é usado em um poderoso sistema em chip para montadoras que inclui os processadores NVIDIA Hopper, Grace e Ada Lovelace. O NVIDIA DRIVE Thor é um computador automotivo que unifica funções inteligentes, como painel de instrumentos digital, infoentretenimento, direção automatizada, estacionamento e muito mais em uma única arquitetura.

LEGO Links de Computação

O NVLink também age como o soquete estampado em uma peça LEGO. É a base para construir supersistemas para lidar com os maiores trabalhos de HPC e AI.

Por exemplo, NVLinks em todas as oito GPUs em um sistema NVIDIA DGX compartilham conexões rápidas e diretas por meio de chips NVSwitch. Juntos, eles permitem uma rede NVLink onde cada GPU no servidor faz parte de um único sistema.

Para obter ainda mais desempenho, os próprios sistemas DGX podem ser empilhados em unidades modulares de 32 servidores, criando um cluster de computação poderoso e eficiente .

Os usuários podem conectar um bloco modular de 32 sistemas DGX em um único supercomputador AI usando uma combinação de uma rede NVLink dentro do DGX e NVIDIA Quantum-2 switch Infiniband fabric entre eles. Por exemplo, um NVIDIA DGX H100 SuperPOD contém 256 GPUs H100 para oferecer até um exaflop de desempenho máximo de AI.

Para obter ainda mais desempenho, os usuários podem acessar os supercomputadores AI no cloud, como o que o Microsoft Azure está construindo com dezenas de milhares de GPUs A100 e H100 . É um serviço usado por grupos como o OpenAI para treinar alguns dos maiores modelos de IA generativa do mundo.

E é mais um exemplo do poder da computação acelerada.