A IA generativa está abrindo novas possibilidades para analisar fluxos de vídeo existentes. A análise de vídeo está evoluindo da contagem de objetos para transformar imagens brutas de vídeo em compreensão em tempo real. Isso permite insights mais acionáveis.

O NVIDIA AI Blueprint para busca e sumarização de vídeo (VSS) reúne modelos de linguagem de visão (VLMs), grandes modelos de linguagem (LLMs) e geração aumentada por recuperação (RAG) com pipelines otimizados de ingestão, recuperação e armazenamento. Parte do NVIDIA Metropolis, ele suporta tanto a compreensão de vídeo armazenada quanto em tempo real.

Em versões anteriores, o VSS Blueprint introduziu capacidades como ingesta eficiente de vídeo, RAG consciente do contexto, pipeline de visão computacional (CV) e transcrição de áudio. Para saber mais sobre esses recursos fundamentais, veja Agentes Avançados de Análise de Vídeo Usando o Plano de IA NVIDIA para Busca e Resumo de Vídeo e Construir um Agente de Busca e Sumarização de Vídeo com o Blueprint de IA da NVIDIA.

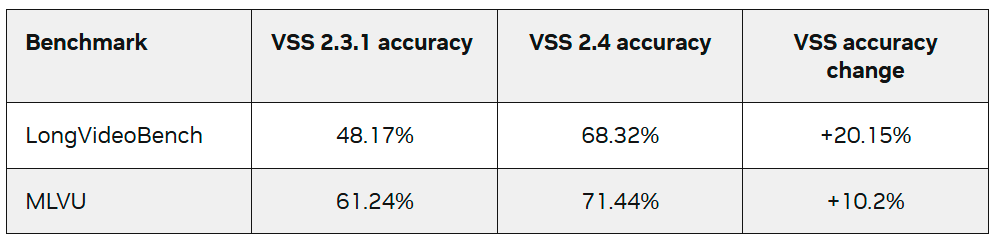

Este post explica os novos recursos da última versão do VSS Blueprint 2.4, que oferece quatro grandes atualizações que permitem aos desenvolvedores:

- Melhore a compreensão do mundo físico: O VSS agora está integrado ao NVIDIA Cosmos Reason, um VLM de raciocínio de última geração que oferece raciocínio avançado de IA física e compreensão de cenas para análises e insights de vídeo mais ricos.

- Aprimore o Q&A: Novos recursos de grafos de conhecimento e suporte a câmeras cruzadas incluem perguntas e respostas multi-fluxo, geração aprimorada de grafos de conhecimento, percorrimento de grafos baseado em agentes, Neo4J e ArangoDB com aceleração cuGraph.

- Desbloqueie IA generativa no edge com o revisor de eventos: Revise eventos de interesse encontrados pelos pipelines de CV e forneça insights contextuais com IA generativa. Novos endpoints permitem configurar o VSS como um complemento inteligente aos pipelines CV. Isso é ideal para implantações de borda de baixa latência.

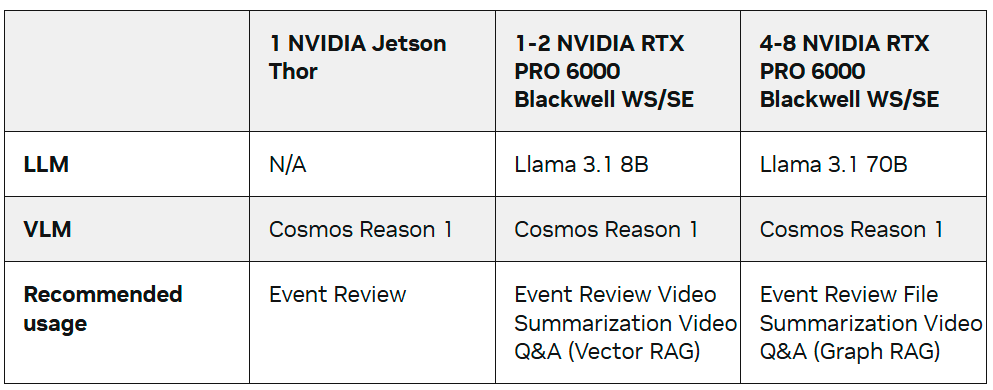

- Implante com suporte de hardware expandido: O VSS agora está disponível em múltiplas plataformas equipadas com NVIDIA Blackwell, incluindo NVIDIA Jetson Thor, NVIDIA DGX Spark e as NVIDIA RTX Pro 6000 para workstations e servidores.

Melhore a Compreensão Física do Mundo com o Cosmos Reason

O Cosmos Reason é um VLM de raciocínio aberto, personalizável, com 7 bilhões de parâmetros e de última geração, para IA física. Ele permite que agentes de IA de visão raciocinem como humanos, usando conhecimento prévio, compreensão física e bom senso para entender e agir no mundo real. O Cosmos Reason permite que desenvolvedores criem agentes de IA capazes de ver, analisar e agir no mundo físico analisando petabytes de vídeos gravados ou milhões de transmissões ao vivo. O Cosmos Reason NIM também está agora disponível, entregando um endpoint VLM pronto para produção para construir agentes de IA visual inteligentes com raciocínio rápido e escalável.

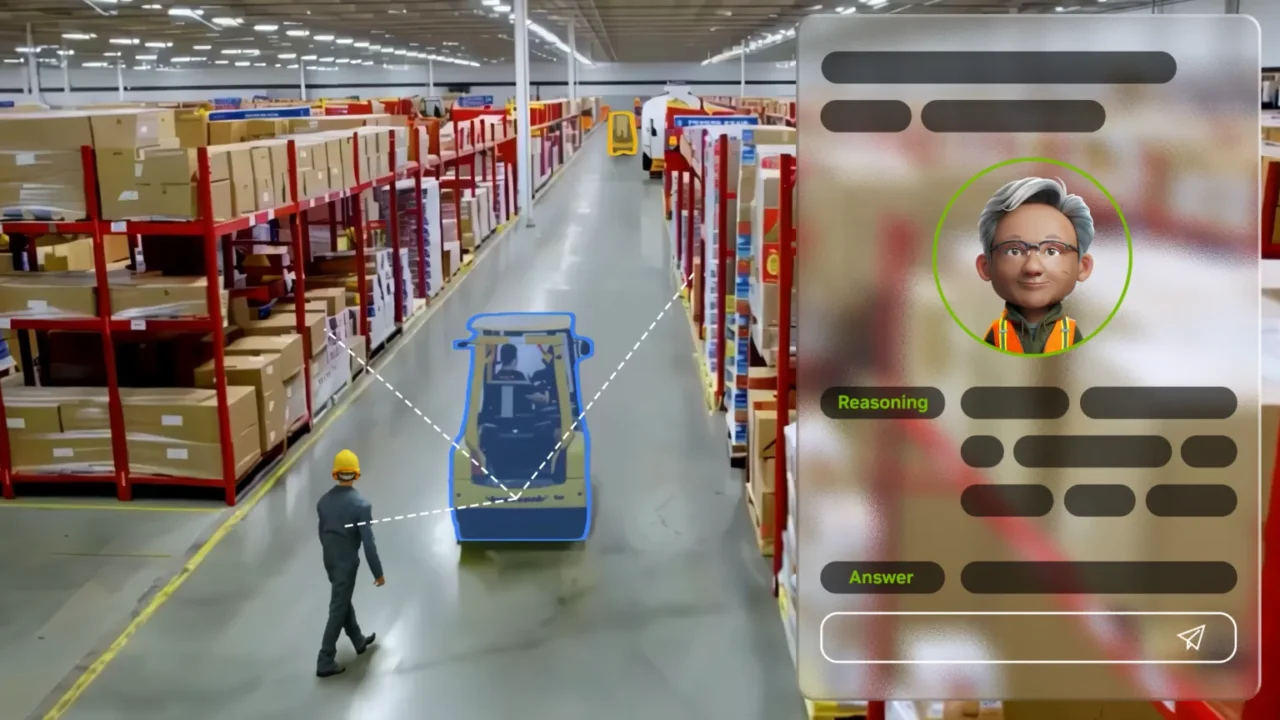

Vídeo 1. Aprenda sobre quatro casos de uso para um agente de IA visual alimentado por um VLM de raciocínio

Agentes de IA de análise de vídeo construídos com o VSS Blueprint 2.4 podem usar o Cosmos Reason para extrair legendas densas e precisas e ricas, enumerar objetos de interesse com um conjunto de indicações de marca, fornecer insights valiosos e realizar análises da causa raiz em imagens de múltiplas indústrias, incluindo linhas de manufatura, armazéns logísticos, lojas de varejo e redes de transporte.

O VSS 2.4 suporta integração nativa com o Cosmos Reason. Esse suporte acopla fortemente o processo de ingestão de vídeo ao VLM para permitir um batch eficiente e acelerações que não são possíveis com interfaces VLM baseadas em API REST. A pequena pegada de 7 bilhões de parâmetros do Cosmos Reason facilita seu uso tanto para implantações na borda quanto na nuvem. O Cosmos Reason é totalmente personalizável e pode ser ajustado com dados proprietários.

Aprimore o Q&A com Suporte a Grafos de Conhecimento e Cross-Câmera

Ingerir grandes quantidades de vídeo é desafiador porque os dados são não estruturados, contínuos e de volume extremamente alto, o que dificulta a busca, indexação ou resumo eficientes. Um único vídeo pode abranger horas de filmagens, incluir múltiplos eventos acontecendo ao mesmo tempo e exigir processamento pesado apenas para decodificar e analisar. Pipelines padrão de visão computacional muitas vezes não conseguem acompanhar em escala, produzindo detecções isoladas sem o contexto mais amplo necessário para entender o que realmente está acontecendo.

O VSS resolve esse problema usando um pipeline de ingestão de vídeo acelerado por GPU. À medida que um arquivo de vídeo ou transmissão ao vivo chega, ele é dividido em partes menores e o Cosmos Reason VLM gera uma descrição ou legenda detalhada de cada parte. Um LLM então extrai as informações necessárias das legendas geradas pelo VLM para construir um grafo de conhecimento que captura os detalhes importantes do vídeo. Uma vez construído o grafo de conhecimento, um grande modelo de linguagem percorre o gráfico para responder às perguntas dos usuários nos vídeos.

O VSS 2.4 aprimora a precisão das perguntas e respostas e o entendimento entre câmeras com:

- Deduplicação de entidades no grafo de conhecimento

- Travessia de grafos baseada em agentes

- Banco de dados de grafos acelerado por CUDA

Em versões anteriores do VSS Blueprint, construir o grafo de conhecimento podia resultar em nós e arestas duplicados. No VSS Blueprint 2.4, um pós-processamento de grafo de conhecimento foi adicionado para remover quaisquer entradas duplicadas e mesclar nós e arestas comuns entre vídeos. Isso significa que entidades comuns, como o mesmo carro se movendo entre várias câmeras, agora são fundidas em uma única entidade, o que melhora a capacidade do VSS de entender objetos únicos enquanto eles se movem em um vídeo e entre câmeras.

Uma vez que o grafo de conhecimento é gerado e pós-processado, um LLM é usado para percorrer o gráfico e reunir as informações necessárias para responder à pergunta do usuário sobre os vídeos.

No VSS 2.4, o raciocínio baseado em agentes foi introduzido para recuperação avançada de grafos de conhecimento. Se ativado, um agente baseado em LLM decompõe inteligentemente a pergunta e então usa um conjunto de ferramentas para pesquisar no gráfico, encontrar metadados relevantes, reinspecionar quadros amostrados do vídeo e iterar, se necessário, para responder com precisão à pergunta do usuário.

Agora é possível responder perguntas através de múltiplos fluxos de câmera usando o pós-processamento do grafo de conhecimento para unir entidades e relacionamentos e a recuperação avançada baseada em agentes.

Para fornecer aos desenvolvedores as ferramentas mais recentes, os backends suportados do banco de dados Graph foram expandidos para incluir o ArangoDB. Os usuários agora têm a capacidade de configurar o VSS para usar tanto o backend de banco de dados de grafos Neo4J quanto ArangoDB. O ArangoDB traz um conjunto de melhorias, incluindo funções de grafo aceleradas por CUDA para acelerar a geração de grafos de conhecimento. Para mais detalhes sobre a integração do ArangoDB no VSS, veja Generate a Video Knowledge Graph: NVIDIA VSS Blueprint with GraphRAG on ArangoDB.

Esses novos recursos para permitir geração de grafos de conhecimento e perguntas e respostas agentivas são mais adequadas para implantações multi-GPU que podem lidar com grandes LLMs e múltiplas requisições VLM simultâneas.

Aumente os Pipelines de CV com o VSS Event Reviewer

Para implantações em menor escala e no edge, o novo recurso VSS Event Reviewer introduz endpoints de API que facilitam a integração do VSS aos pipelines de visão computacional existentes para alertas de baixa latência e perguntas e respostas diretas de VLM em segmentos de vídeo.

Em vez de rodar o VSS continuamente em todos os arquivos ou fluxos, o Event Reviewer permite que o VSS atue como um complemento inteligente que fornece insights VLM apenas para momentos-chave. Essa abordagem reduz muito os custos de computação, tornando o VSS bem adequado para implantações leves e plataformas no edge.

Embora pipelines padrão de CV se destaquem em detectar objetos e pessoas ou aplicar análises para identificar eventos, como possíveis colisões de veículos, eles frequentemente geram falsos positivos e carecem de compreensão mais profunda da cena.

O VSS pode ser usado para aprimorar esses pipelines de CV analisando pequenos clipes de vídeo sinalizados pelo sistema CV, revisando os eventos detectados e descobrindo insights adicionais que métodos tradicionais podem não perceber.

A Figura 4 mostra como o VSS pode complementar um pipeline existente. O pipeline de visão computacional representa qualquer sistema proprietário capaz de receber arquivos de vídeo ou streams e produzir pequenos clipes de interés. Os endpoints do Revisor de Eventos podem então ser chamados para passar esses pequenos clipes de vídeo para o VSS gerar alertas e fazer perguntas de perguntas e respostas com um VLM.

Para demonstrar esse recurso, um pipeline de detecção DeepStream de exemplo é fornecido no repositório VSS GitHub usando GroundingDINO. Esse pipeline de exemplo ingere um vídeo, executa detecção e então gera clipes quando o número de objetos detectados é maior que um limite estabelecido. O objetivo desse pipeline é encontrar os eventos mais importantes do vídeo que precisam ser inspecionados pelo VSS com um VLM.

O VSS então processará cada pequeno clipe usando o VLM respondendo a um conjunto de perguntas sim/não definidas pelo usuário. Essas respostas são convertidas em estados verdadeiro/falso para cada pergunta e podem ser usadas para gerar alertas de baixa latência para o usuário. Depois que o clipe curto for processado pelo VSS, você pode fazer perguntas adicionais mais detalhadas.

Vídeo 2. Assista a uma demonstração de um workflow de referência baseado no VSS Event Reviewer

Essa abordagem usa seletivamente o VLM apenas em clipes de interesse, conforme determinado por um pipeline de detecção leve. Pode reduzir drasticamente o custo de processamento ao diminuir chamadas VLM e liberar a GPU para outras cargas de trabalho.

Implantar de Forma Flexível com Suporte de Hardware Expandido

O VSS Blueprint 2.4 suporta totalmente várias plataformas NVIDIA Blackwell, incluindo as edições de servidor e workstations NVIDIA RTX Pro 6000 e o NVIDIA Jetson Thor para implantações no edge. O suporte para NVIDIA DGX Spark está chegando em breve.

Para uma lista completa das plataformas suportadas, veja a seção Plataformas Suportadas na documentação do VSS.

Comece com IA Visual Baseada em Agente

A nova versão do VSS Blueprint 2.4 traz novas capacidades de IA visual baseada em agente para o edge, melhorias para aumentar a precisão das perguntas e respostas, compreensão entre câmeras e expansão do suporte à plataforma. As melhorias na criação e deslocação de grafos de conhecimento aprimoram a precisão das perguntas e respostas e permitem consultas cruzadas por câmera.

Para implantações no edgee casos de uso de alertas, o recurso Event Reviewer é uma forma de usar o VSS como um complemento inteligente para pipelines CV para alertas de baixa latência. Suporte estendido para plataforma incluindo NVIDIA RTX Pro e NVIDIA Thor.

Para começar rapidamente com o VSS Blueprint, use um NVIDIA Brev Launchable. O launchable oferece implantação rápida com um clique e notebooks Jupyter para explicar como iniciar o VSS, acessar a interface web e usar as APIs REST do VSS. Visite o repositório NVIDIA-AI-Blueprints/vídeo-search-and-summarization no GitHub para mais recursos técnicos, como cadernos de treinamento e código de referência. Para mais perguntas técnicas, visite o Fórum de Desenvolvedores da NVIDIA.

Para detalhes sobre implantações em produção e CSPs, veja a seção Cloud da documentação do VSS.